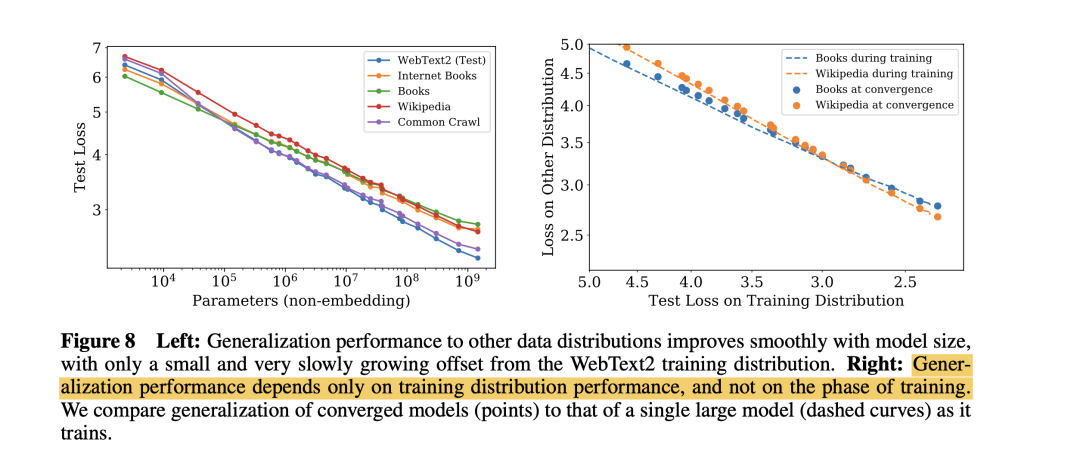

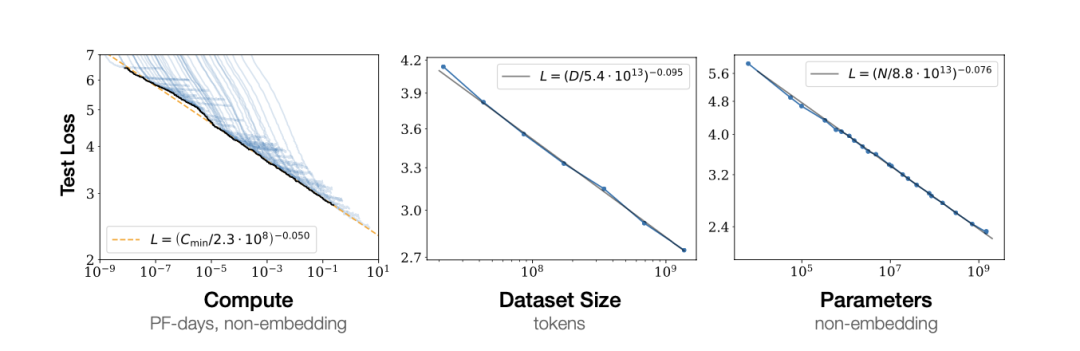

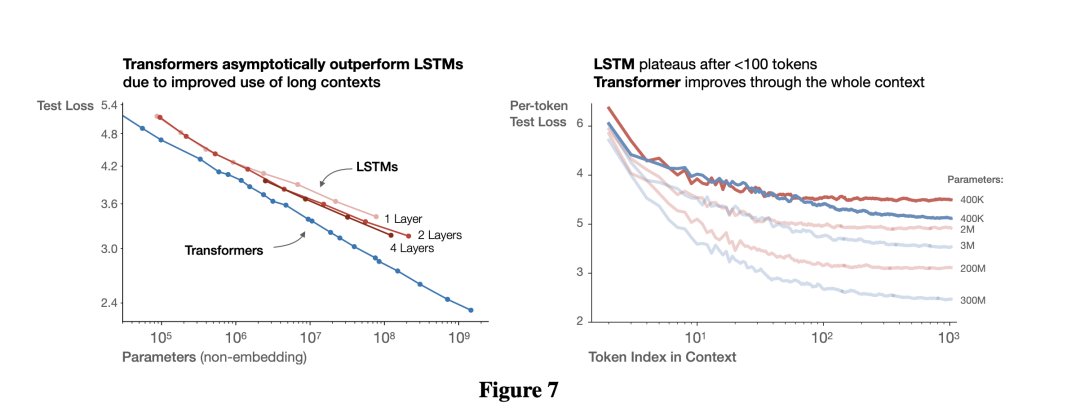

“ language modeling performance improves smoothly and predictably

01

02

-

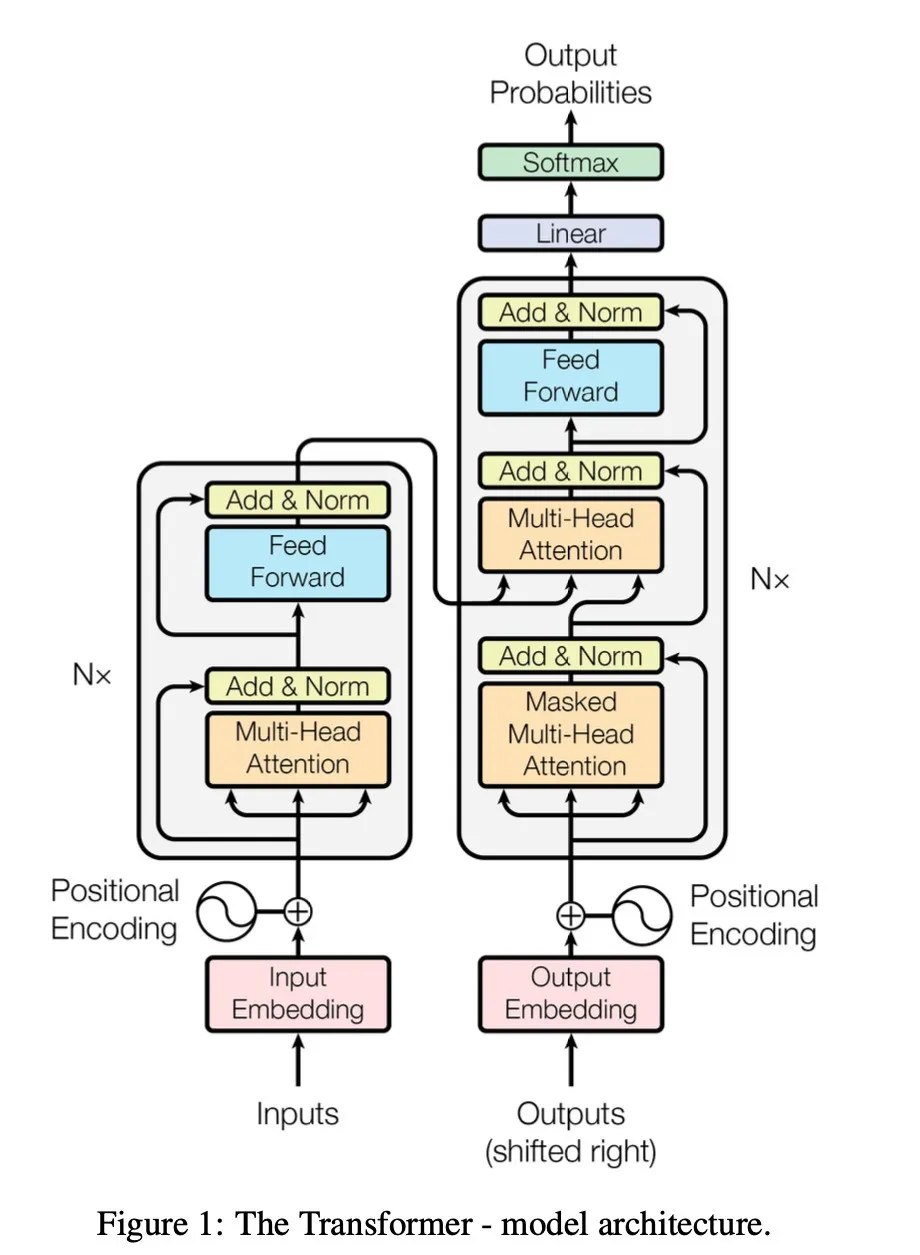

残差连接(Residual Connection):在Transformer模型中,通过允许原始输入直接传递至网络的更深层,这种方法有助于防止信息在深层网络中丢失。 -

残差网络(ResNet):在深层的卷积神经网络(CNN)中,残差连接用于解决梯度消失问题。对于浅层CNN,梯度消失现象较少发生。残差网络的广泛应用使得训练极深的网络成为可能。 -

LSTM和GRU:这两种循环神经网络(RNN)的变体通过引入门控机制来解决梯度消失问题。 -

层归一化(Layer Normalization):通过对神经网络每一层的输出进行归一化处理,使其均值为0,方差为1,这有助于保持梯度在稳定范围内,减少梯度消失问题,并稳定训练过程。层归一化多用于RNN和Transformer;层归一化通常与激活函数一起使用,激活函数一般放在中间层,以确保网络的非线性特性和梯度的稳定性 -

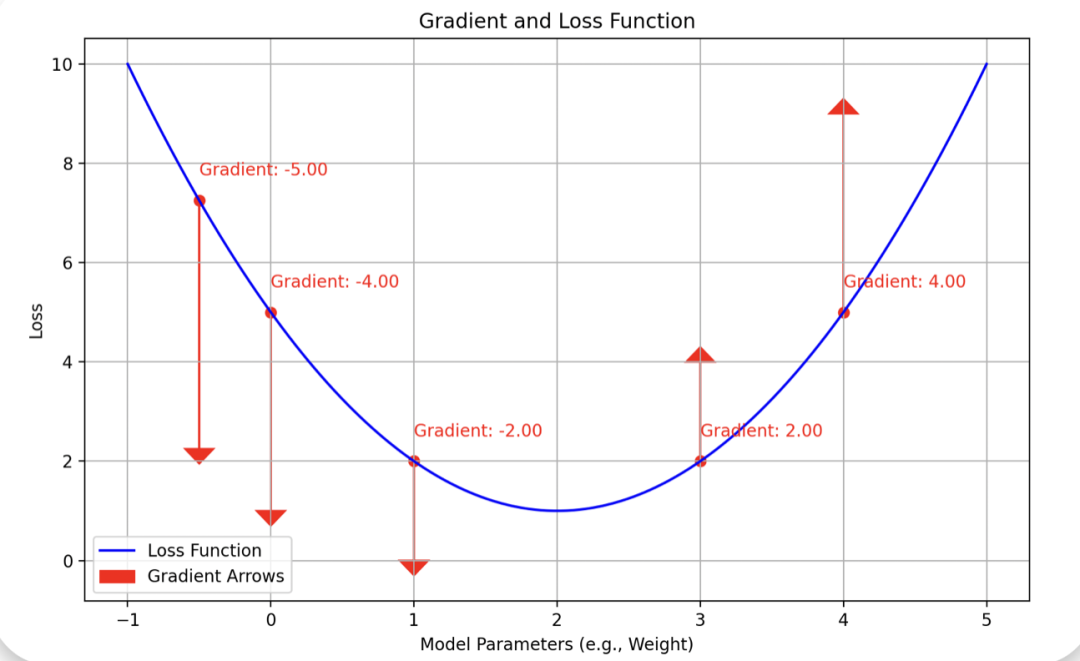

激活函数:激活函数用于引入非线性,使神经网络能够处理复杂和非线性的数据。以下是几种常见的激活函数:

-

Sigmoid:输出范围在0到1之间 -

Tanh:输出范围在-1到1之间 -

ReLU:对于正输入,输出等于输入值;对于负输入,输出为0。ReLU在正区间的梯度恒为1,有效避免了梯度消失问题。 -

梯度修剪(Gradient Clipping):这是一种处理梯度爆炸的策略,通过设定阈值来限制梯度的最大值

03

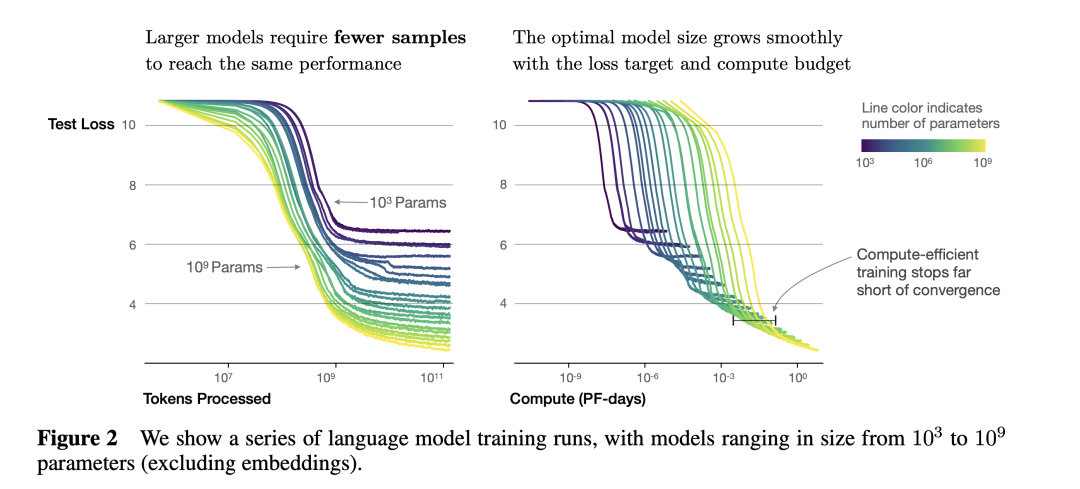

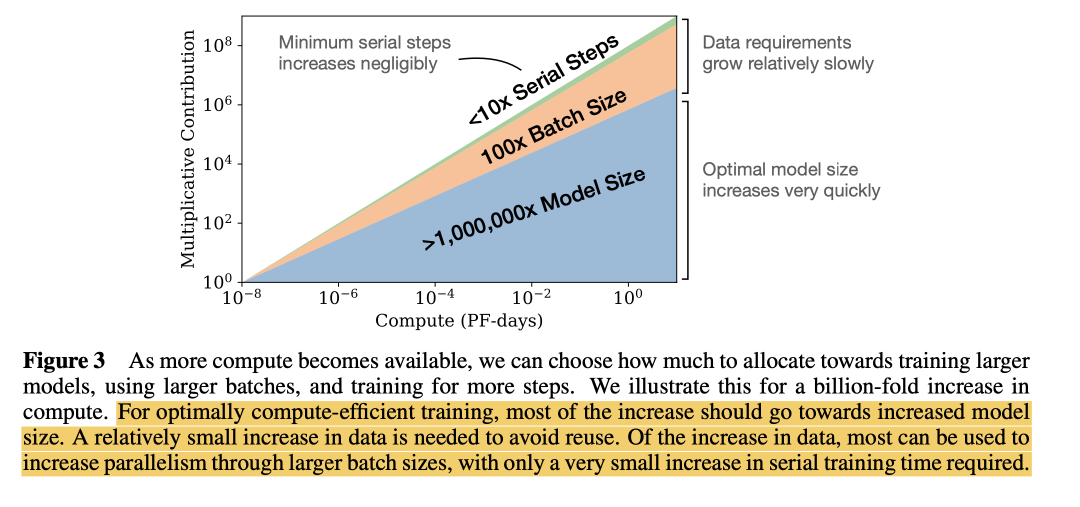

“ 参数多的模型比参数小的模型更能高效地学习,达到相同性能所需的训练数据和所需的步数更少Sample efficiency