AI资讯

-

AI大模型在2C领域的终极目标:心智模型

你还记得第一次看《头脑特工队》是什么时候吗?可能是电影院里的一个夏夜,也可能是在某个疲惫的深夜打开手机,偶然点开的一部动画。但无论什么时候,当看到 Joy 奋力维护 Riley 的快乐,Sadness 却悄然将她引向家人的怀抱——那种又想笑又想哭的感觉,很多人都忘不了。 这部动画的特别之处,不只是可爱的角色或创意的设定,而是它把我们平时不愿直视的“内心运作机制”搬上了银幕:原来快乐和悲伤不是对立的…... -

【解决方案】企业私有化部署大模型解决方案

企业私有化部署大模型并落地智能体应用 ——2025 年现状、架构、案例与决策清单 (所有数据均来自 2025-01~2025-07 公开白皮书、招标书及产业报告) 1. 市场与需求现状(客观事实) 黄金窗口期判定:2024Q4-2026Q2 为“私有化落地黄金期”: ① 国产百亿级模型已成熟(豆包/DeepSeek/Qwen2-72B)且成本 < 公有云 30%; ② 政府/央国企 60% …... -

餐饮业卷生卷死的当下,麦当劳如何用AI突围

点击卡片 关注我们出品丨虎嗅智库 头图丨阿里巴巴瓴羊 走进麦当劳门店,自助点餐机和取餐柜早已成为日常配置,点餐、支付、取餐等环节,顾客几乎可以全自主完成,流程顺畅高效。 不止前端门店,数字化及AI早已渗透到麦当劳业务的方方面面。比如消费者点单时,系统会根据偏好做推荐,门店库存、员工排班靠算法动态优化,供应链上每笔订单,也都有AI在参与调度。 这背后是麦当劳持续多年的数智化探索。在运营复杂、人力密集…... -

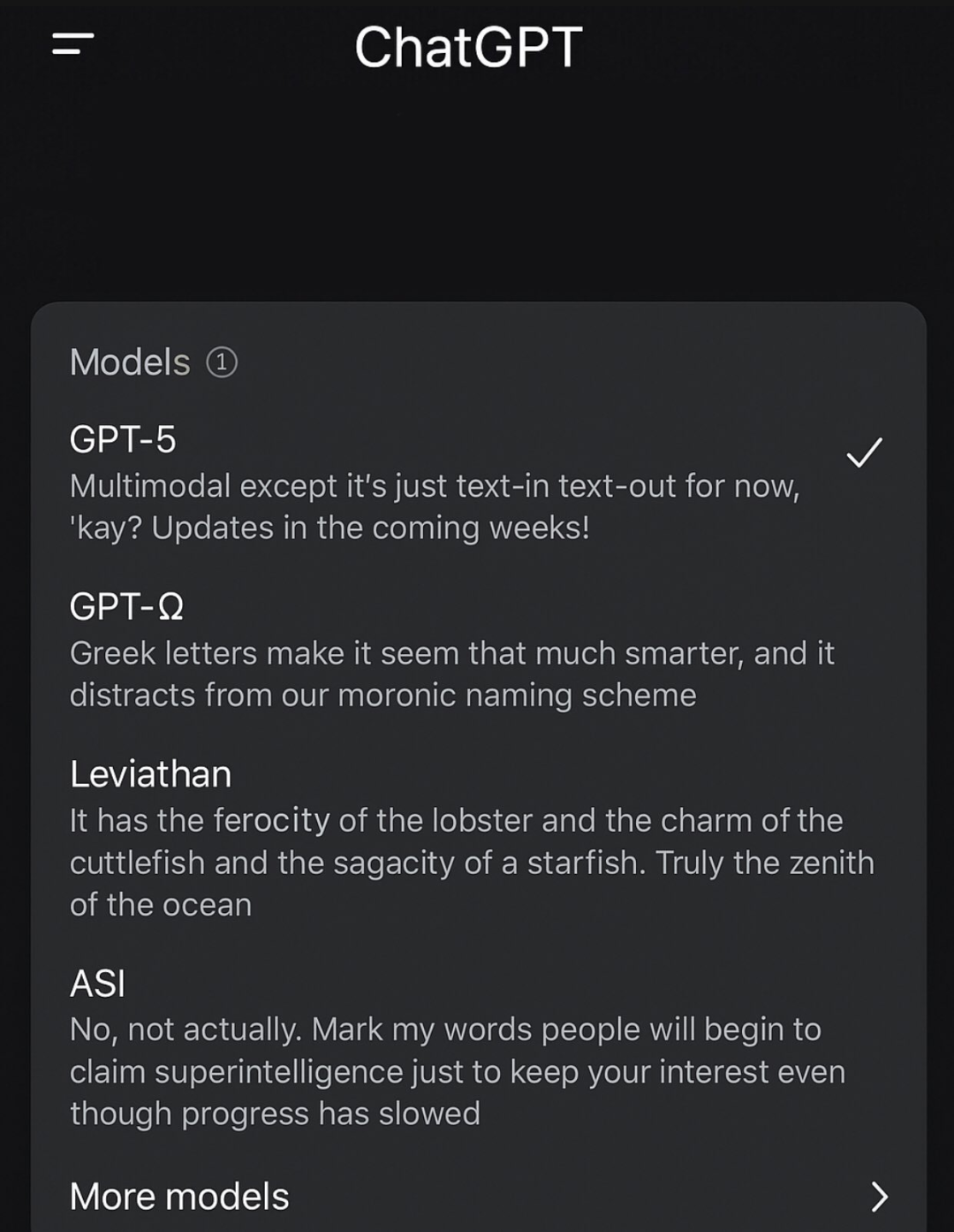

全网疯传GPT-5泄露!首次统一GPT和o系列,编程实测demo抢先曝光,下周发布?

明敏 鹭羽 发自 凹非寺量子位 | 公众号 QbitAI GPT-5这回是真的要来了。 现在,全网都在“偶遇”GPT-5。 不仅是ChatGPT上有踪迹: 而且在MacOS应用的模型列表中也发现了GPT-5。 还有Cursor、微软Copilot以及OpenAI API平台上,也都被网友捉到已经悄悄接入/测试GPT-5。 这一大波泄露,大家对GPT-5的热情和好奇再次被重新拉回高点,还是奥特曼会玩…... -

ODPS重磅升级!全面支撑AI应用爆发

近日,阿里云宣布全面升级自研大数据平台ODPS架构,旗下MaxCompute、Hologres和DataWorks等核心产品将全面拥抱AI,推动大数据与AI的深度融合。 ODPS是阿里云首款产品,过去十五年,ODPS不仅支撑了阿里巴巴集团内部电商、金融、物流等核心业务的数据处理需求,还帮助数万家国内外企业实现了从线下IDC到云原生的平滑过渡。今天,ODPS正式迈入AI Native时代,进化成为A…... -

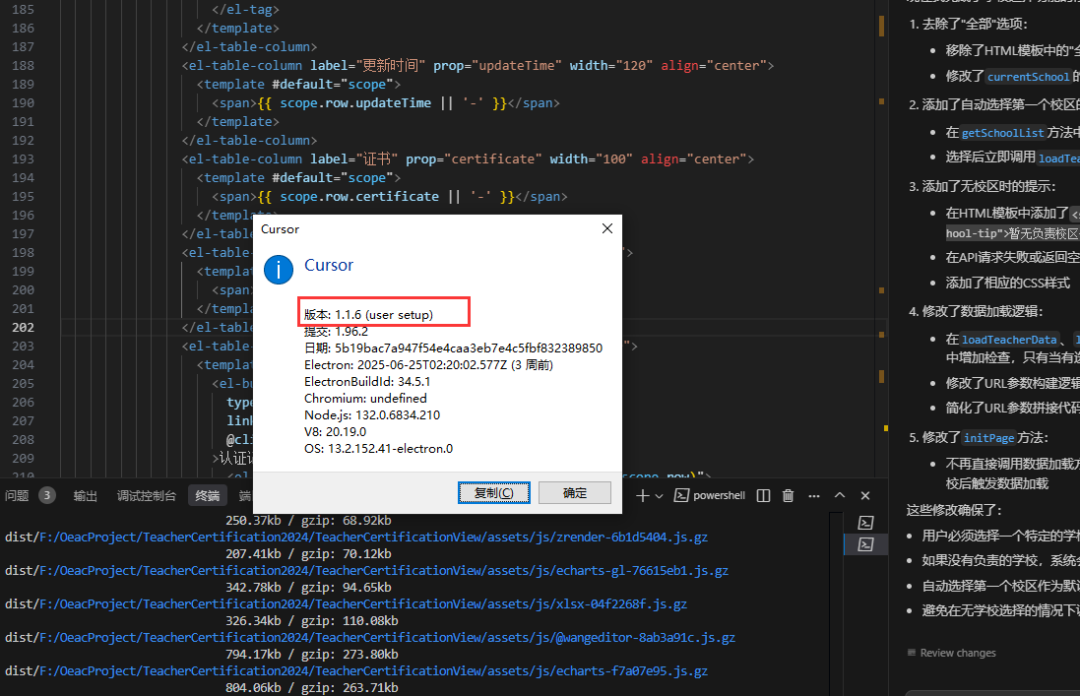

四步搞定Cursor地区限制

小编自从使用了Cursor过后,摸鱼的时间越来越多了,我还一度以为可以解放双手,畅想着让AI帮我工作,我只需要发指令和确认就行,颇有一种指点江山的感觉,但是好景不长啊,兄弟们!说好的科技无国界呢?为了保住为数不多的头发,只能通过魔法打败魔法!通过以下四个步骤,继续解放双手!步骤一:升级cursor到1.0以上版本,小编用的是1.1.6版本步骤二:左上角文件 - 首选项 - 设置-搜索proxy 操…... -

当AI成为团队“隐形搭档”:Anthropic内部如何用AI重构工作流?

最近看了 Anthropic 内部团队使用 Claude Code 的实战案例,突然明白一个道理:真正厉害的 AI 工具,从来不是要取代谁,而是像个 “隐形搭档”,悄悄帮你填平技能鸿沟,把重复工作变成自动流程,让每个人都能专注做更有价值的事。今天就聊聊这些来自一线的真实经验 —— 从工程师到设计师,从财务到法务,不同角色是如何用 AI 打破壁垒、提升效率的,或许能给你的工作带来新启发。1 …... -

微软花重金做的Copilot,居然被WPS一个按钮给秒了?

6 亿人用的 WPS,搞了个智能体灵犀,AI 办公直接开挂。最近,网上流传着一首「打工人之歌」,是这样唱的:「打工人穿的 T 是 PPT,打工人戴的表是 Excel 表,打工人背的包是压缩包,打工人走的道是好的收到。」这简直是当代社畜的真实写照。小时候以为上班就是踩着恨天高,穿着时髦的衣服,坐在高楼大厦里对着电脑键盘敲敲打打。实际的上班是灰头土脸、邋里邋遢,整天不是跟领导扯皮,就是跟客户 batt…... -

国内企业开发的农业AI大模型有哪些?

在传统农业向智能化跃升的关键阶段,一批由国内企业自主开发的农业AI大模型正走进田间地头,成为数智时代的“新农具”。这些农业领域的“超级大脑”正在改变千百年来的种植方式,让农民告别“靠天吃饭”的经验种植模式,迈向“靠数据说话”的智慧农业新时代。虽然农业AI的广泛应用还需要一个过程,但是科技赋能农业的未来可期,这篇笔记简要整理了目前国内由企业主导开发的农业AI大模型,如下。一、种植业大模型1. 中国中…... -

解锁日志分析新姿势:n8n 工作流 + ES 日志 + AI,数据洞察一键 get

01前言运维同学基本都接触过日志系统,最熟悉的应该就是代表性的ELK日志系统,作为日志查询的利器,我想大多数人也只有在排查问题时,才会登陆日志系统去搜索错误日志,平时肯定也懒得主动去看,去分析系统有哪些潜在的风险提示。实际看上去风平浪静,实则暗流涌动,结合上篇文章介绍的n8n工作流编排工具,我想着再把ES日志接入AI,来分析下,想看看,在平时注意不到的地方,到底还有什么隐藏故障,如下是运行后的效果…...