Prompt:移除中间人物以外的所有行人

在 2D 绘画转为真实模特的任务中,SeedEdit 3.0 较好地保持了人物的衣帽穿搭与手提包等细节,生成图片兼具时尚街拍感。

Prompt:使女孩看起来逼真

整个场景的光影变换,模型也可以处理得丝滑、自然。从近处房屋,到远处海水波纹,细节均能合理保留下来,并跟随光线变化,进行“像素级”的渲染调整。

Prompt:把场景变为白天

为了实现上述能力,团队在 SeedEdit 3.0 的研发工作中提出了一种高效的数据融合策略,并构建了多种专用奖励模型。

通过将这些奖励模型与扩散模型联合训练,团队针对性地改善了关键任务的编辑质量(如人脸对齐、文本渲染等)。实际落地中,我们也对推理加速进行了同步优化。

Prompt:将“STOP”更改为“WARM”

1. 图像编辑保持能力突出,真人评测可用率较高

为更好评估升级版的 SeedEdit 3.0,团队收集了数百张真实与合成的测试图像集合,共构建 23 类编辑操作子任务。除了常见的风格化、添加、替换和删除,我们还加入相机运动、物体位移、场景切换等指令式动作,以更全面评估模型表现。

-

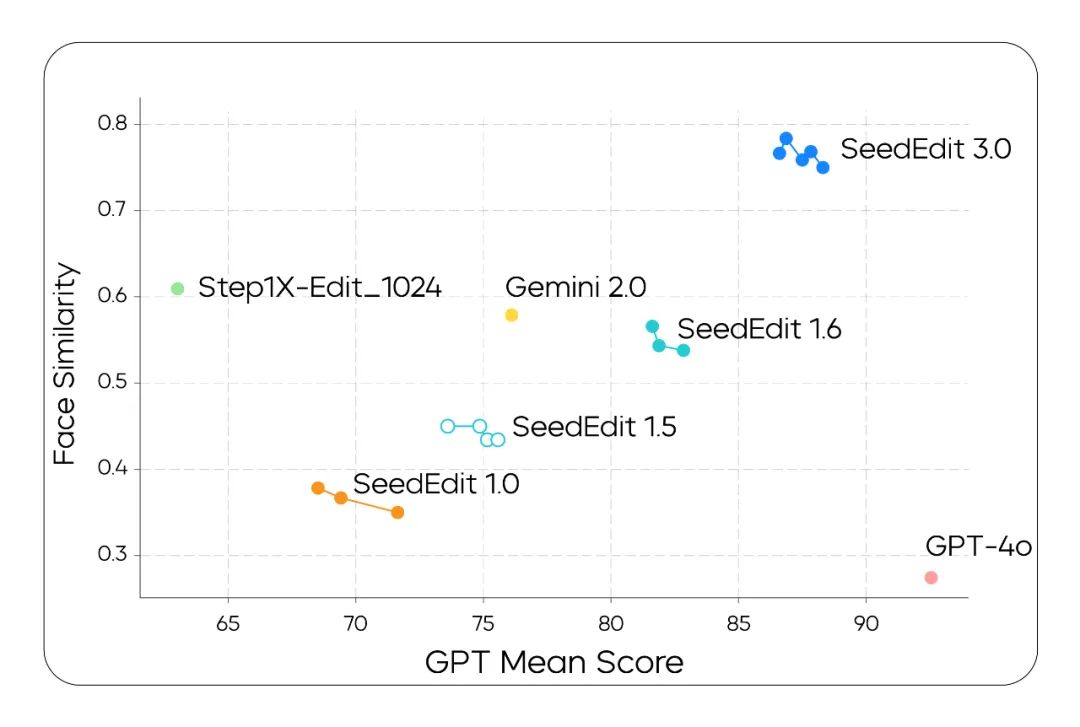

机器评测结果

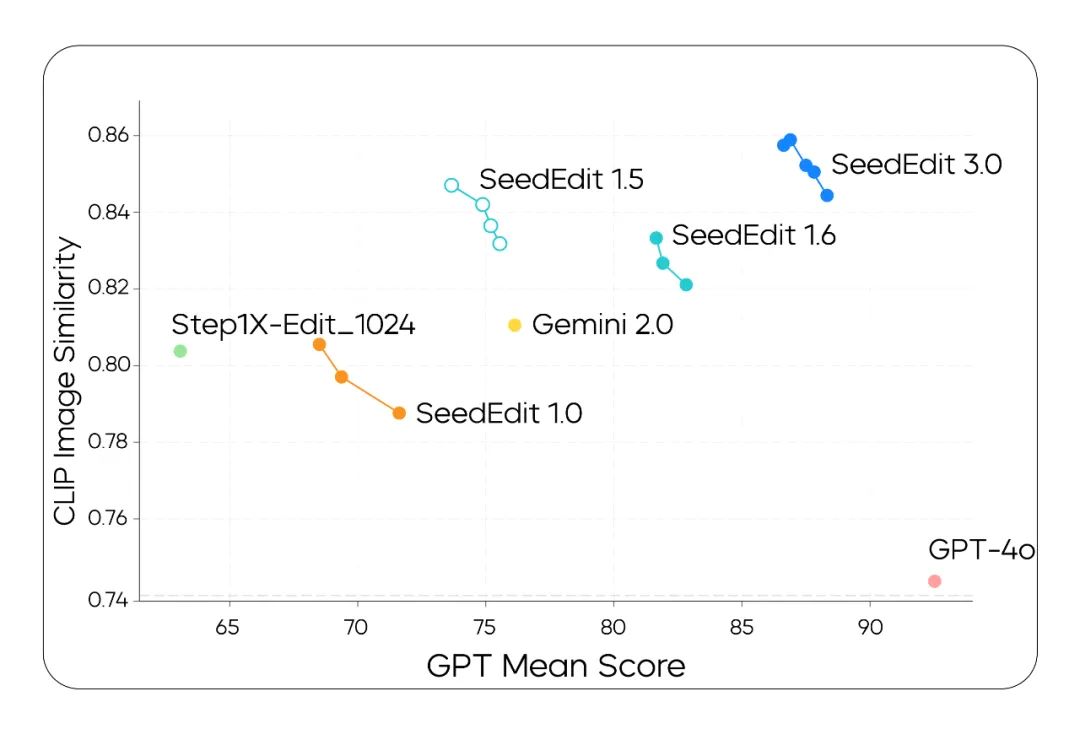

团队以 CLIP 图片相似度评估模型编辑保持效果,利用第三方 VLM 自动化评估“编辑需求是否在最终图片内体现”,即:指令响应程度。

在下方坐标图中,我们可以看到,SeedEdit 3.0 在编辑保持效果、指令响应能力上领先于此前版本 SeedEdit 1.0,以及引入新数据源的 SeedEdit 1.5、进一步加入数据合并策略的 SeedEdit 1.6。对比 Gemini 2.0 和 Step1X,SeedEdit 3.0 也有一定优势。我们同时观察到,GPT-4o 位于右下角,表明其图像保持能力较 SeedEdit 3.0 有差距,但指令遵循更为出色。

纵轴代表图像主体保持效果,横轴代表机器评测的指令响应程度

从下图则可以看到,SeedEdit 3.0 在人脸保持上,也有明显优势。

纵轴代表人脸保持效果,横轴同样代表机器评测的指令响应程度

-

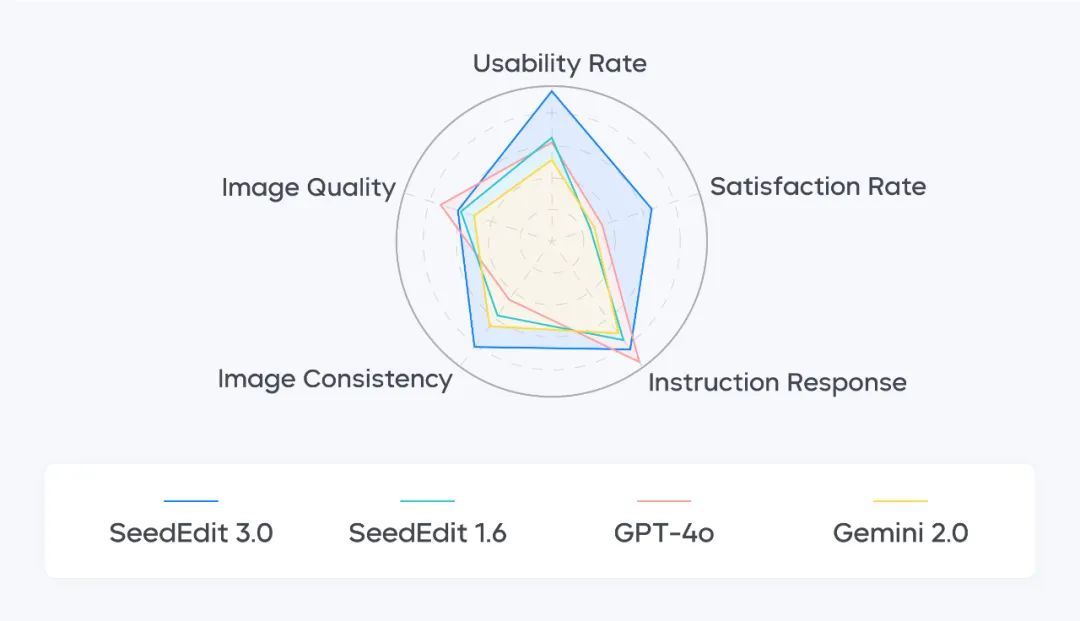

真人评测结果

为增强评估参考性,团队还引入人工评价,采用 0–5 分制评估模型产出与预期差异,共分为五个维度:

-

指令遵循:评估模型是否准确响应编辑指令;

-

图像保持:评估模型是否修改了不该调整的部分;

-

生成质量:评估生成图像质量、美感高低、有无明显伪影;

-

用户满意度:评估不同方法编辑后图像的精品率;

-

可用率:编辑后生成图像结果被用户判断可用的占比。

在综合测评中,SeedEdit 3.0 的图像保持能力最为突出,保持能力得分达到 4.07 分(满分 5 分),较此前版本 SeedEdit 1.6 得分提升 1.19 分;SeedEdit 3.0 可用率达 56.1%,较 SeedEdit 1.6 绝对值增加 17.46 个百分点。同时,SeedEdit 3.0 的指令遵循、生成质量表现也处于行业前列。

不同图像编辑模型在可用率、用户满意度、指令遵循、图像保持、生成质量维度的表现

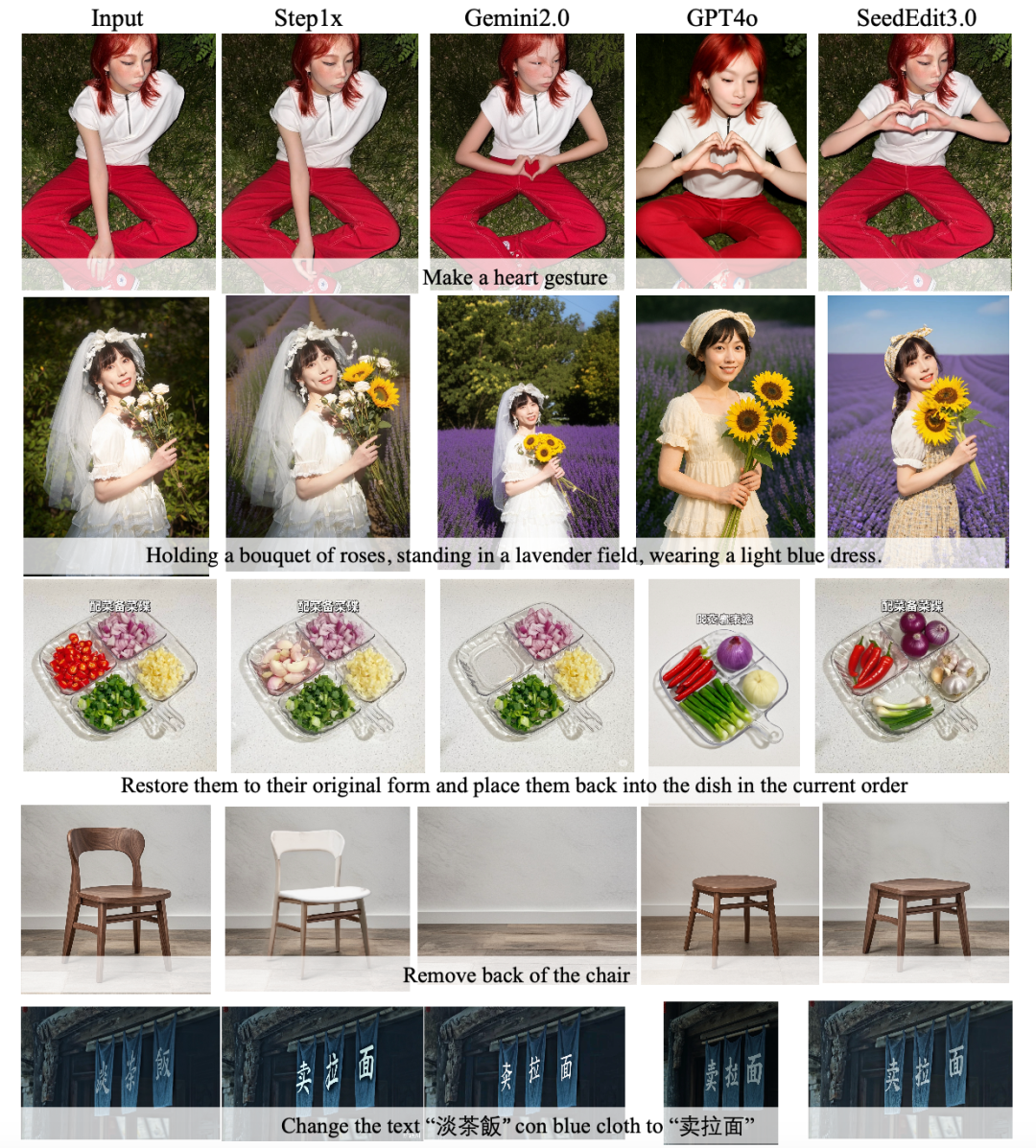

如下为部分对比案例。可以看到,SeedEdit 3.0 对非编辑区域的保持能力强,生成内容自然,细节保持较好,同时兼顾了美感。

通过定性比较能看到,SeedEdit 3.0 在人脸、物体/人物前景、图像细节保留、汉字更改和对齐方面有着较好表现

2. 增强型数据策略,让 AI 理解 P 图任务中的“变”与“不变”

图像编辑任务训练的关键在于——让模型能“听懂”指令、理解不同任务差异、可在画面中区分出“需要改动”和“需要保持”部分。而数据是模型能力的基石,为此,团队专门开发了一套增强型数据融合策略。

考虑不同任务与场景,该方法构建了以下几个类别的数据:

-

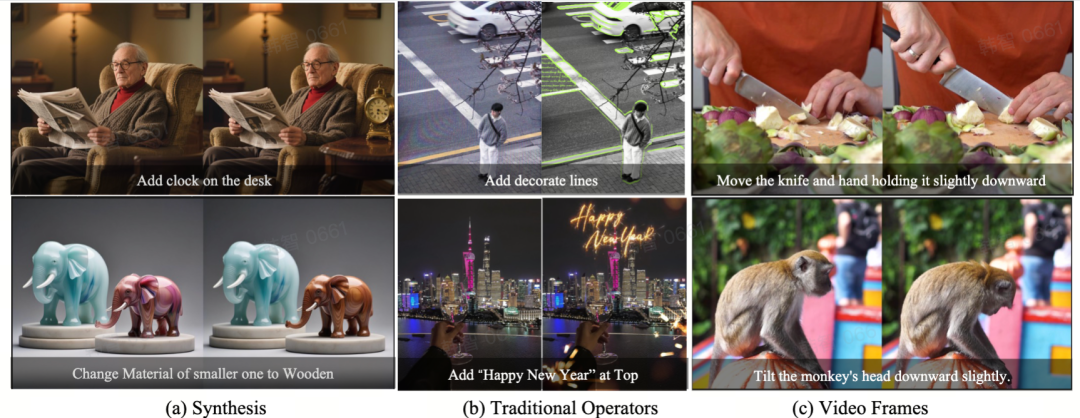

合成数据集

我们专门设计了配对采样策略,该过程既包括语言模型与视觉理解模型生成的提示词采样,也包括文生图模型生成的噪声采样。此类数据使模型能够关注重要和长尾的任务类型与图像主体,理解各种主体姿势的几何推理变化。

-

编辑专家数据

团队以合规方式收集了一部分真实数据,其中包含大量专业图像编辑流程(例如:ComfyUI 工作流、背景&光线调整、文本编辑等),将上述数据与图像生成 API 联合构建出多条数据创建管道,充分覆盖各类专家场景。

-

传统人工编辑操作

我们还基于传统编辑工具制作了高质量编辑操作数据(如:镜头模糊、光照调整、裁剪、按模板生成海报等)。这些数据提供了准确的损失方向信息,进一步让模型“理解”编辑行为中“变”与“不变”的差异。

-

视频帧与多镜头

大规模多样化真实图像对泛化能力至关重要。视频素材为图像配对或组图提供了天然资源,可用于标注并支持图像编辑。于是,我们从视频素材中采样了编辑对——先从视频片段随机抽取若干关键帧,添加文字指令描述区别,再根据 CLIP 图像相似度和光流指标粗筛,最后应用 VLM 精筛。

通过上述方法,我们获取了更多领域的数据,尽可能减少跨领域数据处理产生的域间差距(Domain Gap)问题,提升了模型对图像任务的理解力,让其能像人类设计师一样,处理图像“要改”与“要保持住”的部分。

以下为部分构造的例子:

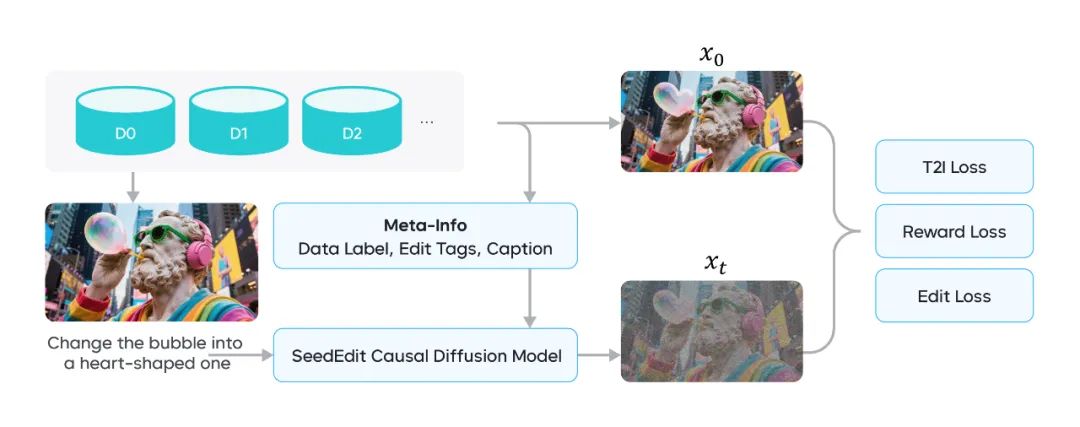

基于上述数据,我们促使扩散模型在真实数据与合成的“输入-输出编辑空间”进行交错学习,在不损失各种编辑任务信息的同时,提高对真实图片的编辑效果。具体训练框架如下:

我们从多个数据源收集元信息,将多个 Loss 融合并插入训练过程中

考虑到不同来源的编辑数据差异较大,直接加入到原始合成图像对将导致性能下降。比如,“更换为巴黎”指令在传统 P 图任务中,可能只涉及简单背景替换,但在基于扩散模型的 IP/ID 保留任务中,则可能意味着对所有像素的彻底修改。

为此,我们提出一种多粒度标签策略,有效融合不同来源的图像编辑数据。对于差别比较大的数据,可通过统一任务标签区分,面向差别较小的,则加入特殊 Caption 以区分,减小模型推理的随机性。鉴于模型需要兼顾中英双语场景,团队对提示词进行了采样,并使用 VLM 生成新的中英文描述。

最后,经过重新描述、过滤和对齐,所有数据均可用于正向和反向的编辑操作训练,从而实现了整体性能的平衡。

3. 对齐不同模态信息,多阶段进行训练

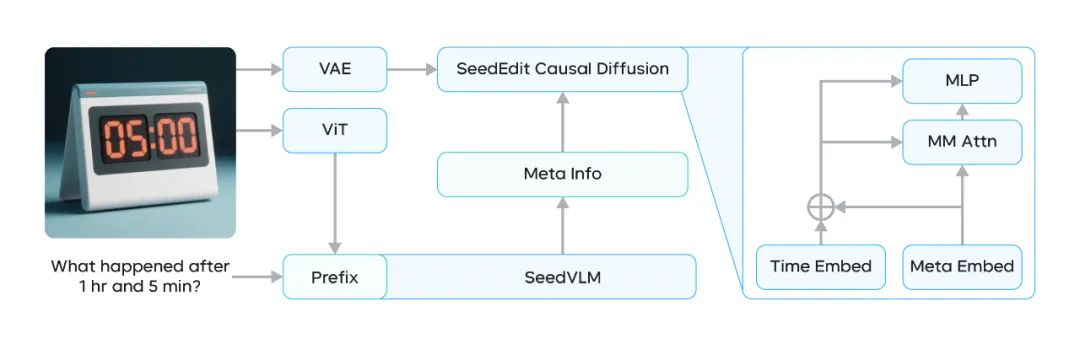

我们沿用此前验证过的框架:底层使用视觉理解模型,推断图像高层语义信息;顶层采用因果扩散网络,并在扩散过程中重新引入图像编码器,以捕捉细节信息。

在视觉理解模型与扩散模型之间,我们加入一条连接,用于将前者获取的编辑推理(如任务类型、编辑标签等)信息与后者对齐。

在其基础上,我们将扩散网络升级为 Seedream 3.0,可原生生成 1K 至 2K 分辨率图像,显著提升了输入图像细节(如人脸与物体特征)的保留效果。此外,这还使得 SeedEdit 3.0 获得了充分的双语文本理解和文本渲染能力,并可轻松拓展到多模态图像生成场景。

改造完成后的 SeedEdit 3.0 结构

为训练该架构,我们采用多阶段训练策略。其中,预训练旨在融合所有收集的图像对数据,精调则聚焦于微调并稳定编辑性能。

具体来说,我们先进行了多长宽比训练,依靠多分辨率批次训练,使模型从低分辨率逐步过渡到高分辨率。

在微调阶段,团队重新采样大量精调数据,从中选出高分辨率、高质量样本,结合多种模型过滤器和人工审核,对数据进行筛选,确保数据高质量且覆盖丰富的编辑类别。接着,采用扩散 Loss 对模型进行微调。

对于部分对用户价值极高的属性(例如人脸身份、一些细节结构或美感等),我们引入特定奖励模型作为额外 Loss,并赋予权重,提升 SeedEdit 3.0 在高价值能力上的表现。

最后,我们将编辑任务与 T2I 任务联合训练,这使得:

(1)注入高质量/高分辨率的 T2I 图像后,模型高分辨率图像编辑能力显著提升;

(2)模型可保留 T2I 模型能力,进一步增强泛化性能。

4. 融合多个加速方法,实现 10 秒级推理

在训练与推理加速方面,SeedEdit 3.0 也采用了更为有效的方案:

-

蒸馏模型方法

我们的加速框架基于 Hyper-SD 和 RayFlow,通过为每个样本设定独特的目标分布,大幅减少路径重叠,提升了生成稳定性和输出多样性,避免了传统方法细粒度控制削弱、反向去噪不稳定的问题。

-

CFG 蒸馏

考虑到无类别引导(Classifier-Free Guidance,CFG)方法导致推理成本几乎翻倍,我们将 CFG 编码为一个可学习模块,与时间步编码联合嵌入。这种蒸馏方法实现约 2 倍的推理加速,且仍可按需调整引导强度。

-

统一噪声参照

为保证采样过程平滑过渡,我们引入由网络预测的单一噪声参照向量。该向量在每个时间步保持不变,为去噪阶段提供持续一致的引导,实现更稳健的采样和更逼真的重建。

-

自适应时间步采样

传统扩散训练过程损失方差较大,并在低信息量区间存在计算浪费,我们引入了一种自适应采样策略,在训练中,神经网络模块会重点选择对损失下降贡献最大的时间步,实现更具针对性的更新,使计算资源利用率提升,降低训练成本。

-

少步高保真采样

SeedEdit 3.0 的框架采用高度压缩去噪调度,相较标准方法,新框架让模型大幅减少采样步数,同时在美感、文本-图像对齐、结构准确性等关键指标上仍有较好表现。

-

量化

面向 DiT 模型的架构与规模,我们通过内核融合(kernel fusion)和内存访问合并(memory access coalescing)等技术手段,对特定算子进行了性能优化。

与原始结构相比,部分算子执行速度提升超过两倍。同时,我们还对 GEMM 和 Attention 模块进行了低比特量化,进一步提升了性能并节省内存。

5. 写在最后

尽管 SeedEdit 3.0 在图像保持、可用率等方面表现不错,团队同样也看到,其在指令遵循方面仍有一定提升空间。

未来,除进一步优化编辑性能外,团队还将探索更丰富的编辑操作,让模型拥有连续多图生成、多张图像合成、故事性内容生成等能力,帮助用户激发更多精彩创意。