OpenAI官方文档深度解读

一、为什么要解读这份指南

最近,OpenAI发布了一份《A Practical Guide to Building Agents》(构建智能体实践指南),这是业界首份来自顶级AI公司的Agent系统化指南。

为什么这份指南值得深度解读?

大型语言模型正变得越来越强大,能够处理复杂的多步骤任务。推理能力、多模态和工具使用的进步解锁了一种新型LLM驱动系统:Agent(智能体)。

为什么要关注AI Agent?三个关键变化:

- 处理复杂性的突破

– Agent能理解上下文、处理异常、做出判断,而不是机械执行规则 - 效率的量级提升

– 从部分自动化到全流程自动化,人类只需设定目标和处理极端情况 - 新的人机协作模式

– 人类专注于创造性和战略性工作,Agent处理执行和优化

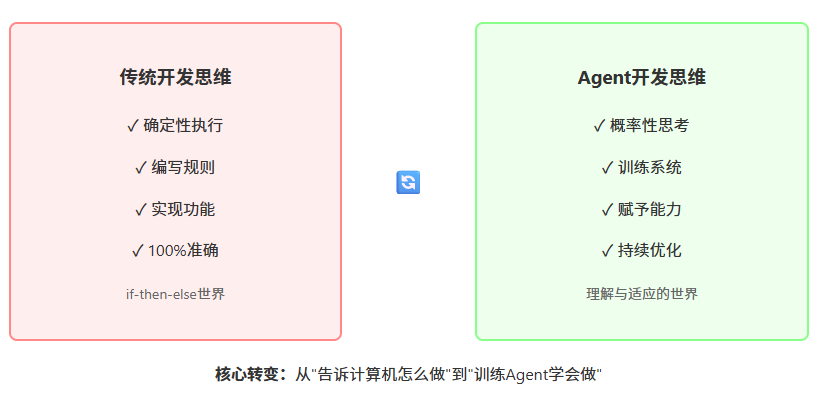

这标志着软件从"工具"向"助手"的根本性转变。对开发者而言,意味着从编写规则到训练智能系统,先进入者将获得巨大优势。

本文将深度解读这份指南的核心内容,结合实践经验,帮助技术爱好者和开发者理解Agent技术的本质与应用。

📄 原文来源:OpenAI – A Practical Guide to Building Agents

发布时间:2025年4月17日

二、理解Agent

什么是AI Agent?

OpenAI的定义:Agent是能够独立完成任务的系统。

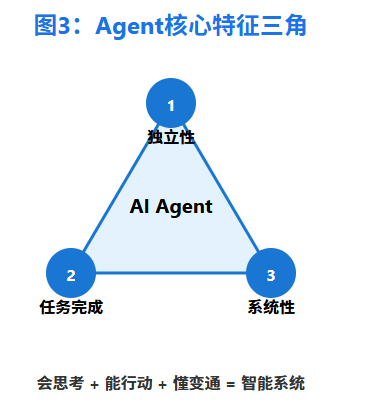

这个定义看似简单,但包含了深刻的内涵。让我们从三个维度理解Agent:

1. 独立性(Independence)

不需要人类在每一步进行指导,而是给定目标后能自主规划和执行。

类比理解:

-

传统AI像计算器 – 你输入2+2,它返回4 -

Agent像助理 – 你说"帮我安排下周去北京的行程",它会查机票、订酒店、规划日程

2. 任务完成能力(Task Completion)

不仅仅是执行指令,而是要判断任务是否真正完成,并在失败时能够自我纠正。

具体表现:

-

判断下一步该做什么 -

识别任务是否完成 -

遇到错误时调整策略 -

知道何时需要人工介入

3. 系统性(Systematic)

Agent不是单一的模型,而是包含多个组件的完整系统。

系统组成:

-

大脑(LLM):负责思考和决策 -

手脚(工具):与外部世界交互 -

规则(指令):定义行为准则

核心特征:

一句话总结: Agent是一个会思考、能行动、懂变通的智能系统,它不是等待命令的工具,而是主动完成任务的伙伴。

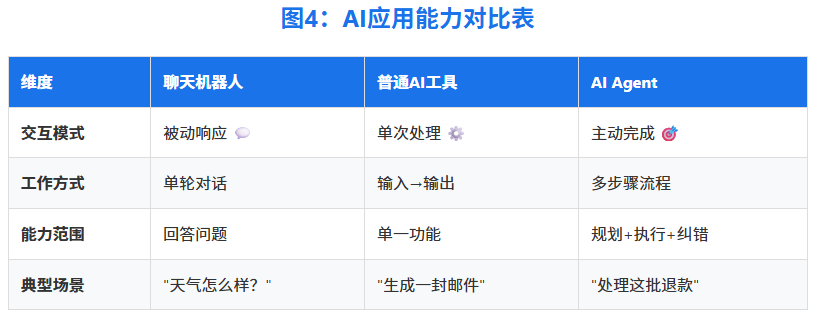

Agent vs 普通AI应用

核心区别:

-

普通AI应用:强大的单点能力,需要人类串联 -

AI Agent:端到端的任务完成,自主协调多个步骤

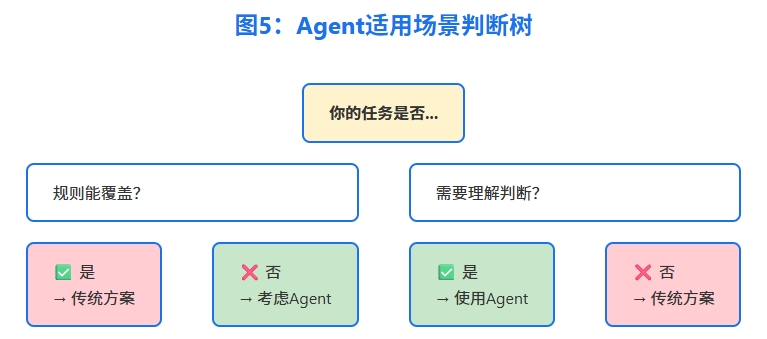

什么时候需要Agent?

核心判断原则: 当传统的"if-then"规则无法覆盖所有情况,需要"理解"和"判断"时,就是Agent的用武之地。

生动案例:支付欺诈分析

-

传统规则引擎:像清单式检查,按预设标准标记交易 -

Agent方式:像经验丰富的调查员,评估上下文、考虑细微模式,即使没有明确规则违反也能识别可疑活动

1. 复杂决策场景

特征:

-

决策因素超过5个 -

规则之间存在冲突 -

需要"理解"而非"匹配"

示例: 客服退款审批需要综合考虑客户历史、产品类型、当前政策等多个因素

2. 规则难以维护

警示信号:

-

规则文档超过100页 -

修改一条规则需要测试数周 -

新员工需要3个月才能理解系统

真实案例: 某金融风控系统从50条规则增长到2000+条,无人能完全理解

3. 大量非结构化数据

适用场景:

-

自动处理客户邮件(理解意图、分类、回复) -

分析合同条款(提取关键信息、风险识别) -

理解语音指令(转文字、理解、执行) -

解读图片内容(损失评估、质量检查)

为什么Agent更适合:传统方法需要复杂的ETL流程或人工处理,Agent可以直接"理解"内容,无需预定义模板。

反向思考 – 不需要Agent的场景:

-

❌ 简单的CRUD操作 -

❌ 明确的数学计算 -

❌ 固定流程的审批 -

❌ 规则清晰且稳定的场景

三、构建Agent

三大核心组件

理解这三个组件及其协作方式,是构建成功Agent的关键。

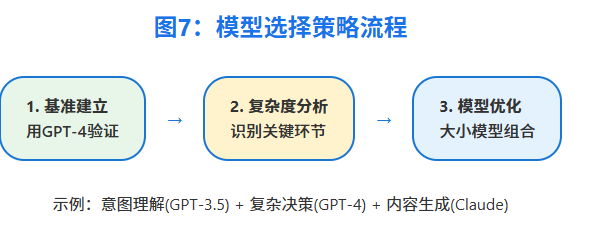

🧠 模型(Model):Agent的大脑

核心作用:

-

理解任务目标和当前状态 -

决定下一步行动 -

从结果中学习和调整

选择策略:

实践建议: 像组建团队一样组合模型 – 不同任务用不同"专家"。例如:意图理解用小模型(快速响应),复杂决策用大模型(准确判断),内容生成用专门优化的模型(更自然的语言)。

🛠️ 工具(Tools):Agent的手脚

三类工具体系:

设计原则:

重要提醒: 工具数量不是越多越好。相似或重叠的工具会让Agent选择困难。10个定义清晰的工具胜过30个功能模糊的工具。

📋 指令(Instructions):Agent的行为准则

指令的三层架构:

最佳实践:

-

从现有文档提炼(操作手册、流程图、客服话术) -

明确异常处理方式(预见常见问题) -

分解复杂任务为清晰步骤 -

定义明确的行动(每步对应具体操作) -

捕获边缘案例(用户信息不全时如何处理) -

持续优化迭代(基于实际运行反馈)

技巧: 可以用GPT-o3等高级模型自动将现有文档转化为Agent指令,提高效率。

🔄 三组件协作机制

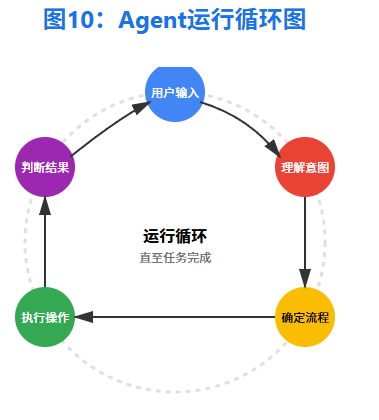

用户输入 → [模型]理解意图

→ [指令]确定流程

→ [工具]执行操作

→ [模型]判断结果

→ 继续或完成

动态过程示例:处理退款请求时:

-

模型理解:"用户要求退款" -

指令指导:"先查询订单状态" -

工具执行:调用订单系统API -

模型判断:"订单符合退款条件" -

继续流程:执行退款操作…

编排模式:从单兵到团队

单Agent系统:大道至简

核心机制 – 运行循环(Run Loop):Agent在循环中运行,直到满足退出条件:

-

任务完成(达到目标) -

遇到错误(无法恢复) -

需要人工介入(超出能力) -

达到最大尝试次数(防止无限循环) -

用户主动终止

每个循环包括:评估现状 → 决定行动 → 执行操作 → 检查结果

扩展路径:

基础Agent

├── 核心功能

├── 工具集1(查询类)

├── 工具集2(操作类)

└── 工具集3(分析类)

何时需要拆分:

-

指令超过500行 -

工具超过15个且功能重叠 -

响应时间超过用户容忍度 -

需要完全不同的专业知识

多Agent系统:专业协作

Manager模式(中央调度)

-

适用:需要统一入口、综合多方信息 - 关键原则:保持Manager"瘦"

-

Manager只做任务路由和结果汇总 -

业务逻辑下沉到专业Agent -

避免Manager成为性能瓶颈

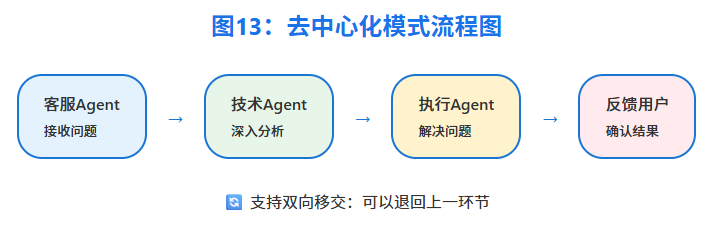

去中心化模式(接力协作)

-

适用:流程明确、专业分工清晰 -

关键:设计好移交协议

选择原则: 从简单开始,让架构随需求演进

混合模式: 结合两种模式优势,如客服场景中,Manager Agent管理多个专业Agent,但专业Agent之间也可直接协作,提供更大灵活性。

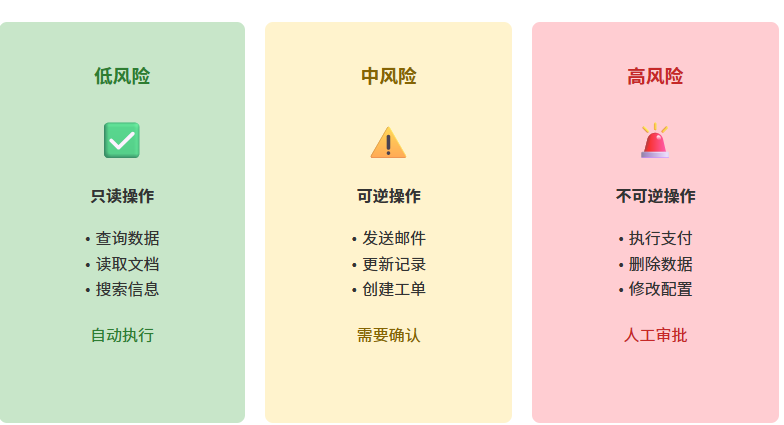

安全护栏:让Agent可控

核心理念: 单一防护措施都不完美,但多层防护能大大提高安全性——就像网络安全中的"纵深防御"。

构建Agent – 工具权限控制

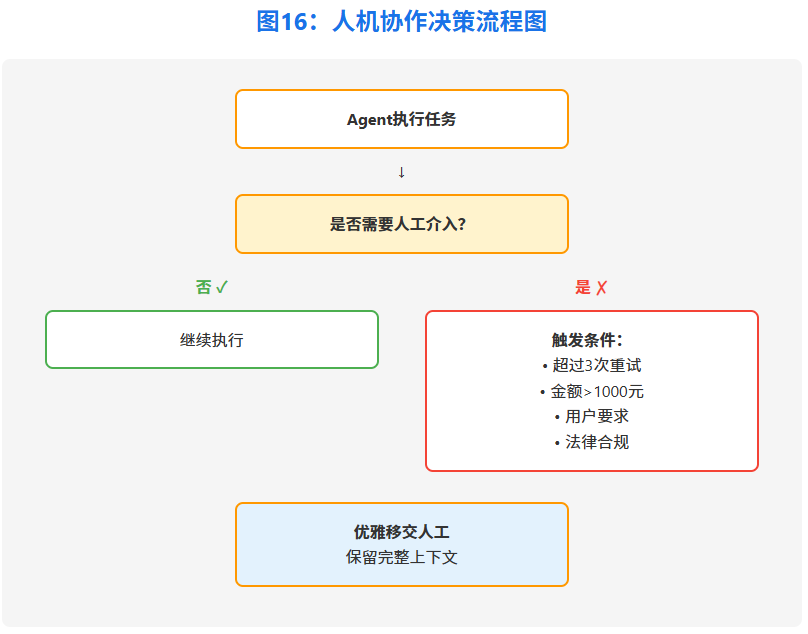

人机协作边界

优雅降级策略:

"这个问题比较复杂,我已经整理了相关信息:

- 问题概述:...

- 已尝试方案:...

- 建议方向:...

正在为您转接专员..."

关键价值: 人工介入不是失败,而是智能体系的安全阀。早期部署时尤其重要,帮助识别失败模式、发现边缘案例、建立评估基准。

四、实践指南

给开发者的建议

必备技能:

-

LLM原理和提示工程 -

API设计和系统集成 -

异步编程和状态管理

推荐学习路径:

-

先用OpenAI Agents SDK快速上手 -

理解Agent运行机制 -

逐步构建自己的框架

思维转变

-

未来的"编程"更多是编写指令和训练Agent -

理解业务流程比纯技术能力更重要 -

软件工程师角色向"Agent训练师"转变

关键提醒:

-

建立完善的评估体系(技术指标+业务价值) -

重视组织准备度(文化、流程、技能) -

Agent是增强而非替代,保持人类的最终控制权

五、结语

Agent不是遥远的未来,而是正在发生的现在。作为开发者,我们正站在软件开发范式转变的关键节点上。

这份OpenAI的指南为我们提供了宝贵的实践经验和清晰的实施路径。但记住,最好的Agent不是最智能的,而是最有用的。

三个深刻认识:

-

Agent代表了软件演进的新阶段- 从确定性执行到智能决策的质的飞跃 -

成功的关键在于场景选择- 选对场景事半功倍,选错场景事倍功半 -

最好的架构是演进出来的- 不要过度设计,让需求驱动架构