-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 0

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

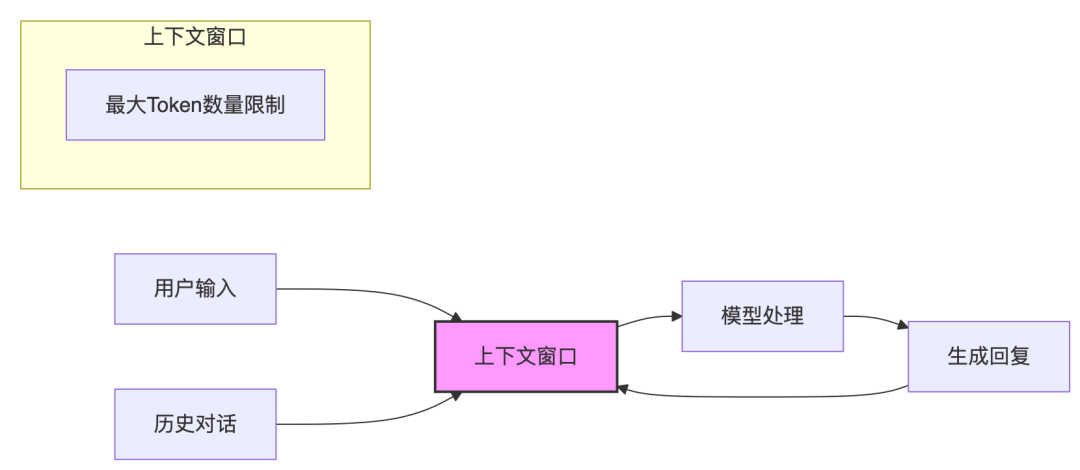

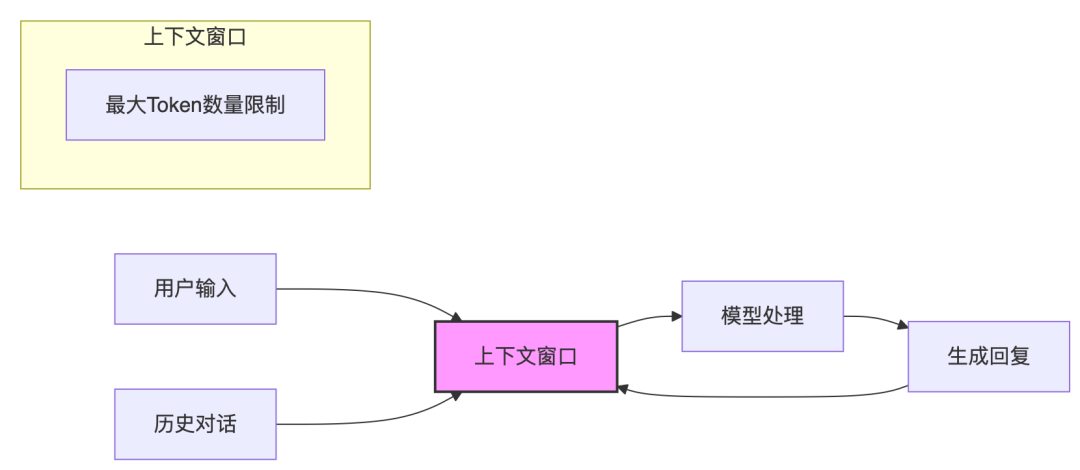

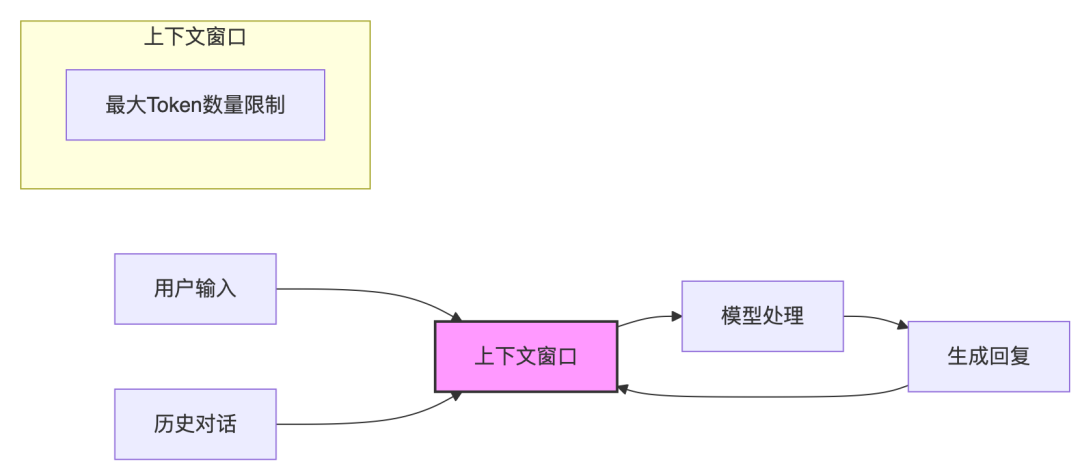

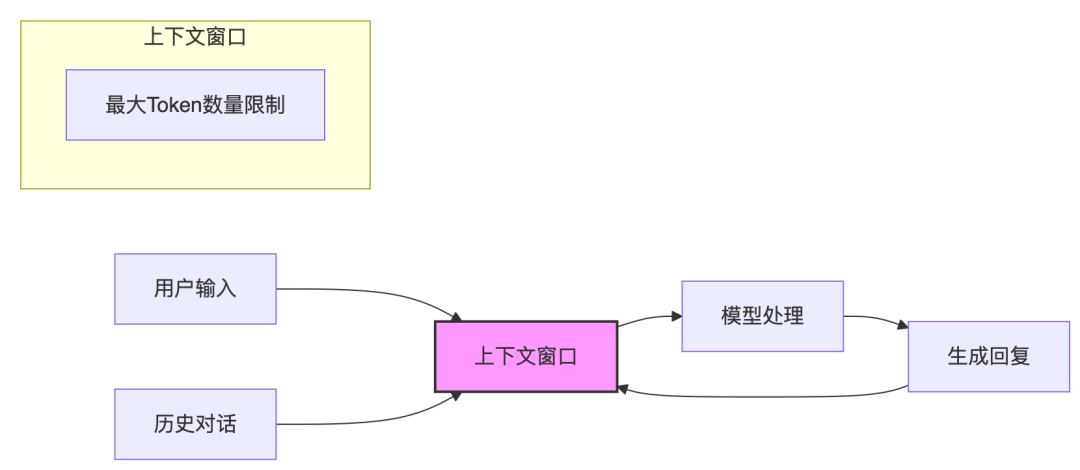

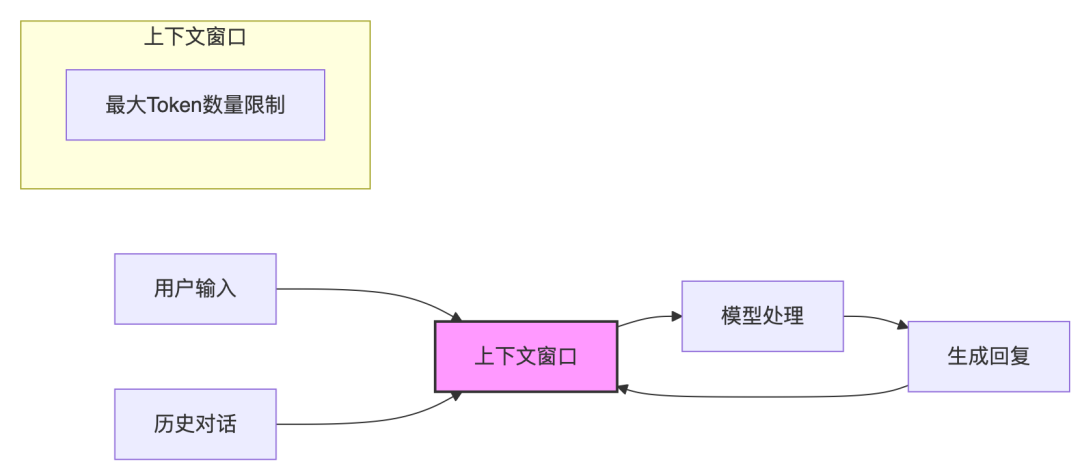

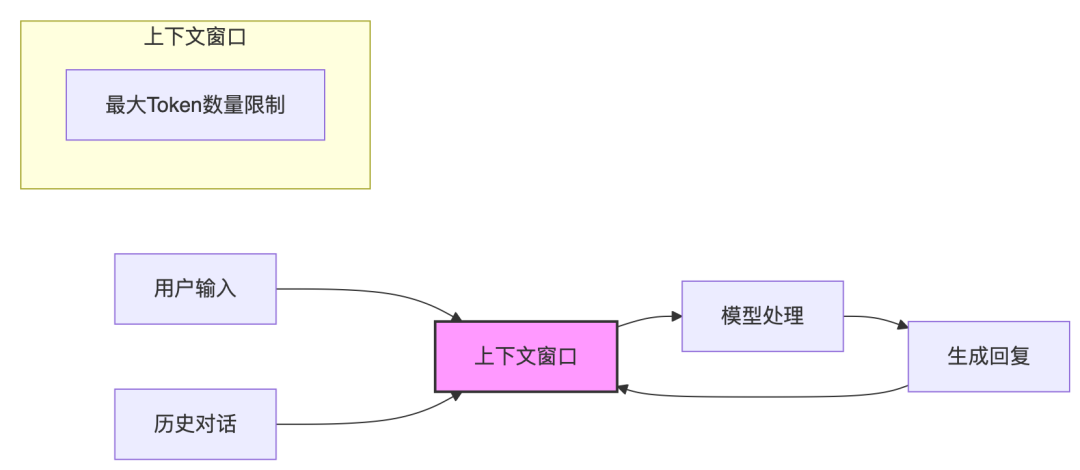

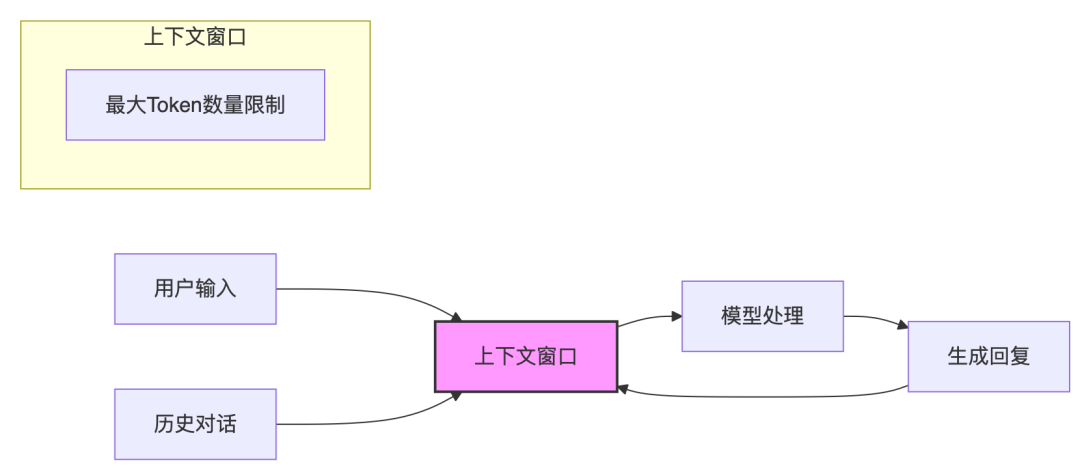

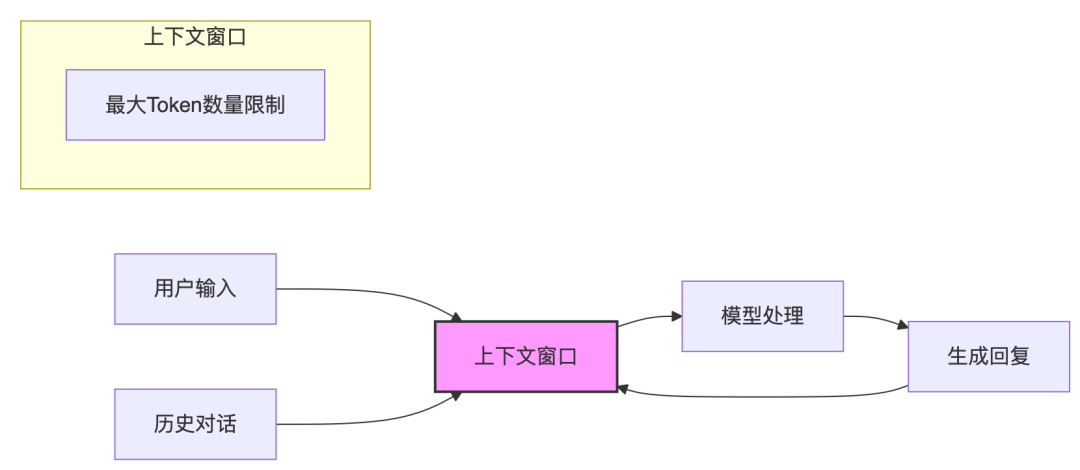

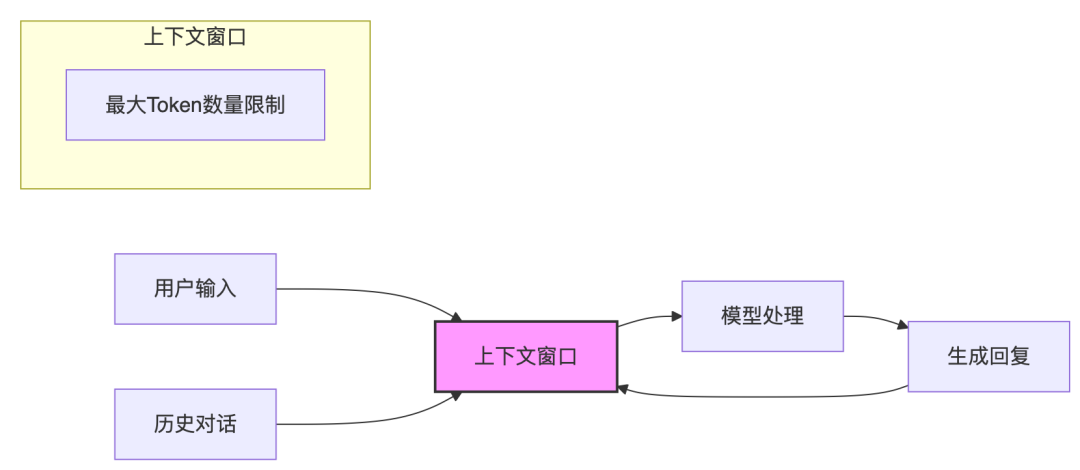

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 0

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 0

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 0

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 0

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 0

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 0

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 0

- 0

-

大模型效果差?可能你输在了上下文工程!

人类再聪明,也受环境所限模型再强大,亦为上下文所困面对大模型的浪潮,一个根本性的选择摆在我们面前:是造模型,还是用模型?造模型:需要基础训练和模型优化。需要AI研究员,聚焦于基础训练与模型优化,解决的是领域理解的问题。用模型:需要应用增强模型能力。需要工程师,聚焦应用增强层落地,解决的是领域流程的问题。现在也不用想了,造模型的就这么几家大玩家,广大的人民群众都转到用模型的赛道上,这也是智能体为什么…- 0

- 0

-

AI 生产力工具研究:拆解海外明星表格产品Clay AI,探索 AI 表格的现状和机会

各位好,见字如面。前段时间,钉钉、飞书都推出了自己最新一代的多维表格产品;其中表格产品和 AI 的结合成为了大家的关注焦点。其实表格已经不是新的概念了,我觉得之所以又一次回到大众视野中来,是大家看到的是一种随着技术的进步,过去表格形态的体验逐渐被解决,而优势逐渐放大,大家甚至看到了逐渐替代传统软件的功能。这次我来细致拆解1款同样是以表格为核心的明星产品 Clay AI,并聊一聊我的思考和见解。这里…- 0

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 0

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 0

- 0

-

【Agent专题】Agent工作原理:Agent的5个关键阶段:输入处理、理解与分析、决策制定、行动执行以及反馈和学习。

想真正用好一个 AI Agent,光会调接口是不够的,你得先理解它背后的运行逻辑。 其实,一个成熟的 AI Agent,并不是简单的“接收指令 → 执行任务”这么直线,它更像一个拥有闭环认知与自我进化能力的智能系统。 它的整个工作过程,就像一个复杂而有机的循环系统,通常包括五个关键阶段:输入处理、理解与分析、决策制定、行动执行以及反馈和学习。 这不仅是 Agent 工作的基本流程,也正是它从“工具…- 1

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 0

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 0

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 0

- 0

-

Qwen3-Embedding最新嵌入模型使用指南

1、概述Qwen3-Embedding嵌入模型是 Qwen 系列的最新(2025年6月)专有模型,专为文本嵌入和排序任务而设计。该系列基于 Qwen3 系列的密集基础模型,提供了全面的文本嵌入和重排序模型,支持各种规模(0.6B、4B 和 8B)。Qwen3嵌入模型继承了基础模型卓越的多语言能力、长文本理解和推理能力。Qwen3 嵌入模型系列在文本检索、代码检索、文本分类、文本聚类和双…- 1

- 0

-

Perplexity CEO访谈,揭露了AI产品目前最大的问题。

今天晚上,我花了一个多小时,看完了Perplexity CEO Aravind Srinivas的最新访谈,有兴趣可以自己去看一下。原视频地址贴在下面了。url:https://www.youtube.com/watch?v=2jOnoTEk-xA看完后,有些想法和总结,想分享给你。#01:关于“护城河”——先有用户,再谈其他Aravind说,AI时代,功能和产品都太容易被复制了。唯一真正的护城河…- 1

- 0

-

AI成熟度模型:评估AI代理的就绪度

引言生成式AI(GenAI)的出现为业务转型创造了前所未有的机遇,越来越多的企业正考虑使用AI代理(AI Agent)来增强和提升其员工的生产力。由Databricks委托Economist Impact进行的一项调查发现,85%的企业至少在一个业务部门中积极使用GenAI,而在年收入超过100亿美元的公司中,这一比例更是高达97%。然而,在实验与价值创造之间存在脱节。尽管许多企业正在试水生成式A…- 0

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 0

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 0

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 0

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 0

- 0

-

聆心智能郑叔亮:用 AI 打开心理服务市场 | ToB AI 十问

AI 在心理健康领域真正的价值在于可规模化的专业服务能力。图由 AI 生成文|Alex编辑|燕子当 AI 大模型的技术浪潮席卷全球,一个专注于人类情感理解的细分领域正在悄然崛起。 聆心智能 CEO 郑叔亮 在最新的访谈中,为我们揭开了情感智能商业化背后的故事。 这家脱胎于清华大学黄民烈教授实验室的创业公司,最初只是尝试让机器理解人类情绪。从 2021 年训练几十亿参数的对话大模型起步,到如今构建起…- 1

- 0

❯

购物车

优惠劵

搜索

扫码打开当前页

联系我们

返回顶部

幸运之星正在降临...

点击领取今天的签到奖励!

恭喜!您今天获得了{{mission.data.mission.credit}}积分

我的优惠劵

-

¥优惠劵使用时效:无法使用使用时效:

之前

使用时效:永久有效优惠劵ID:×

没有优惠劵可用!