-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

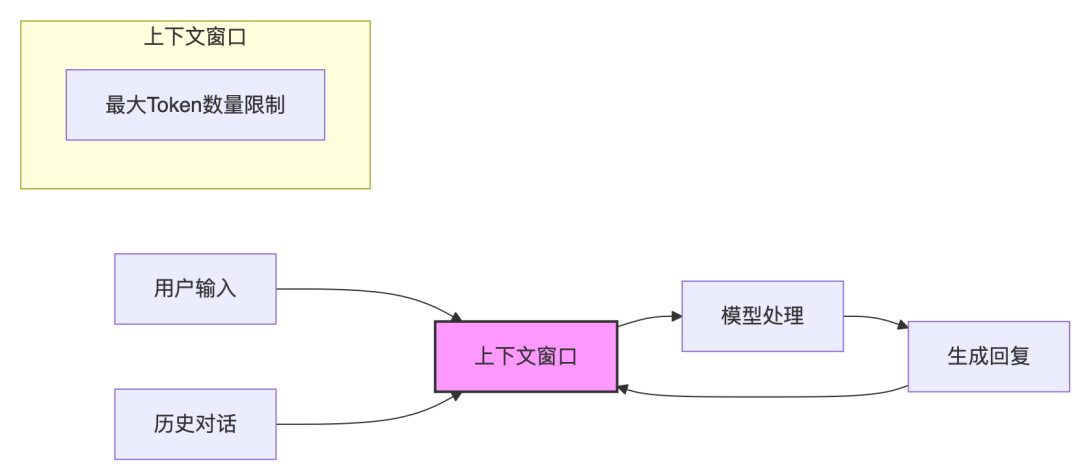

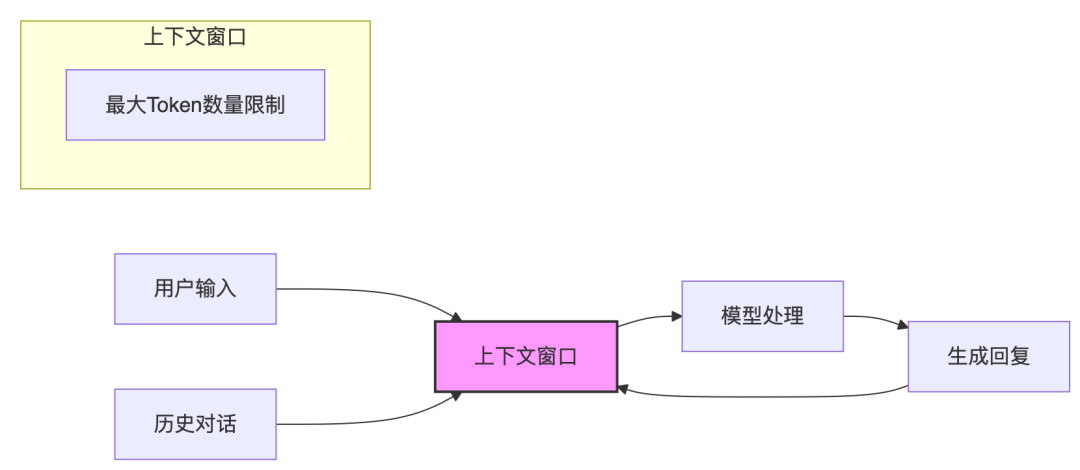

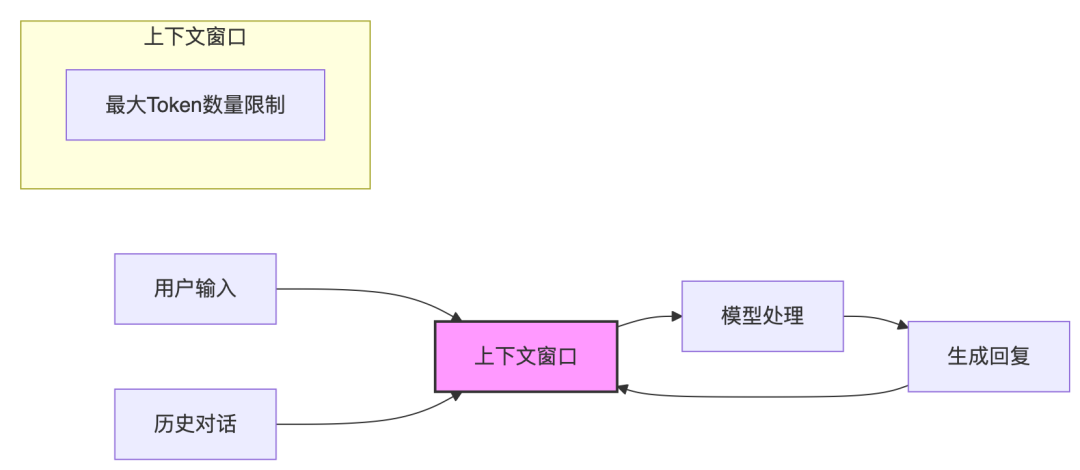

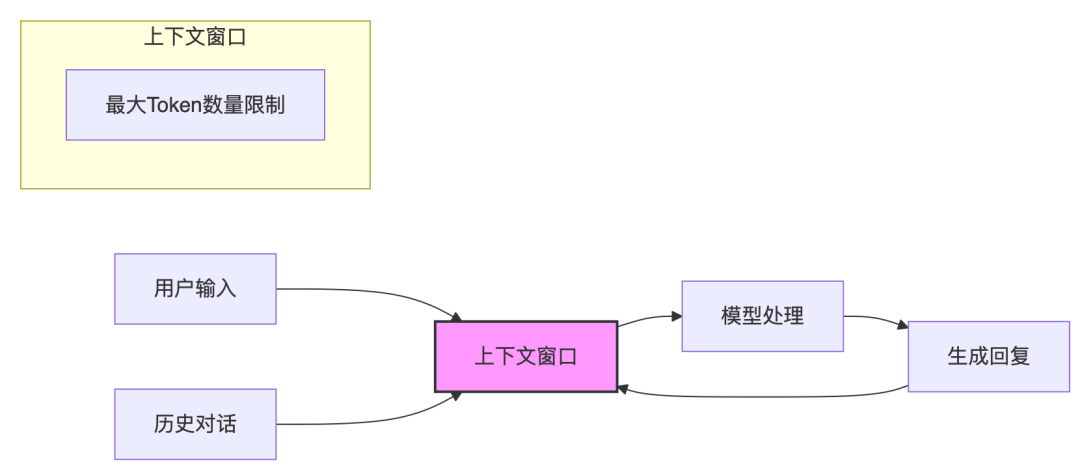

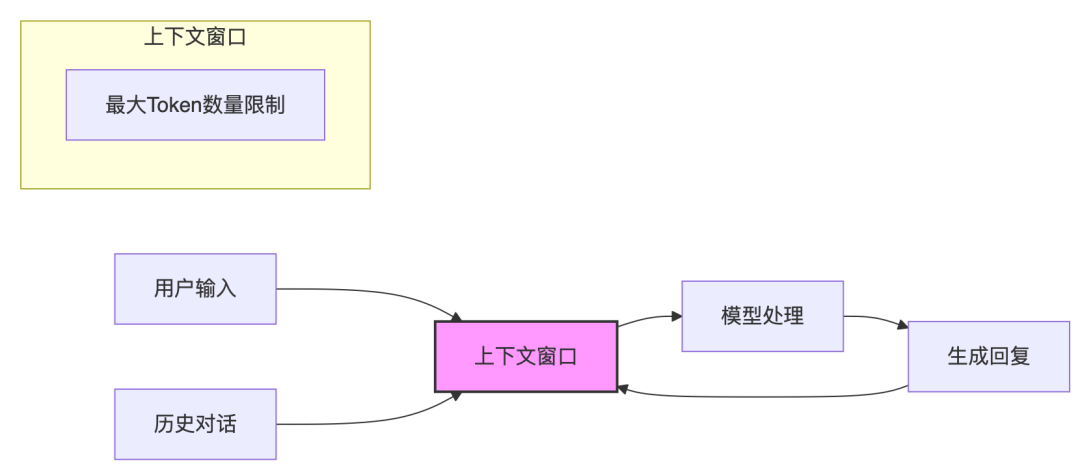

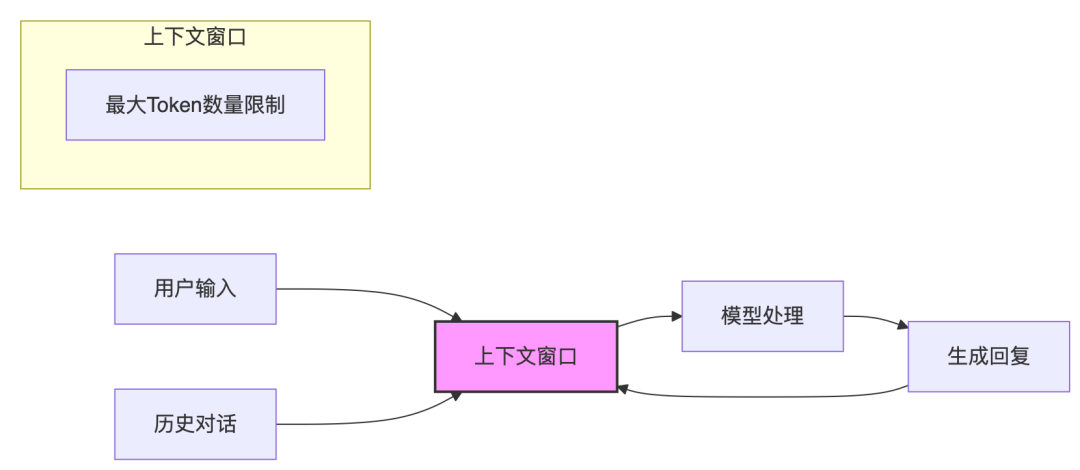

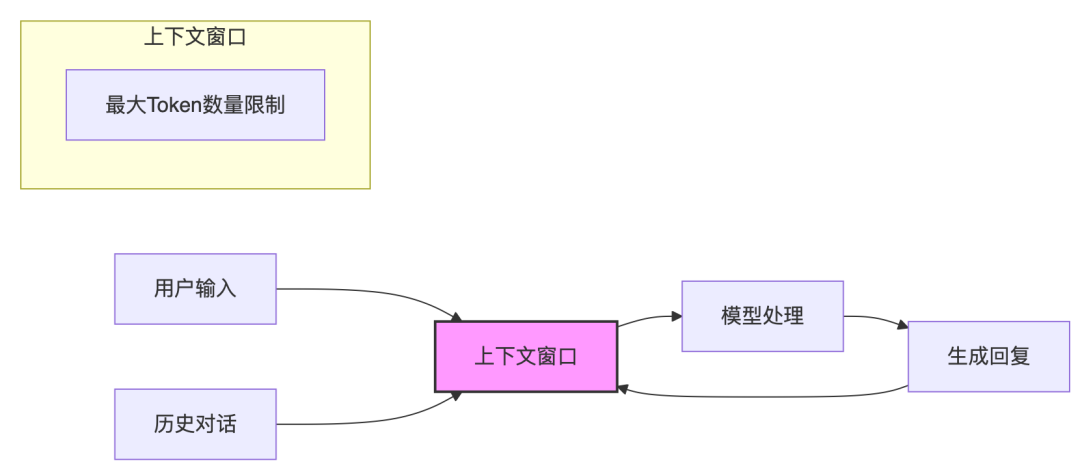

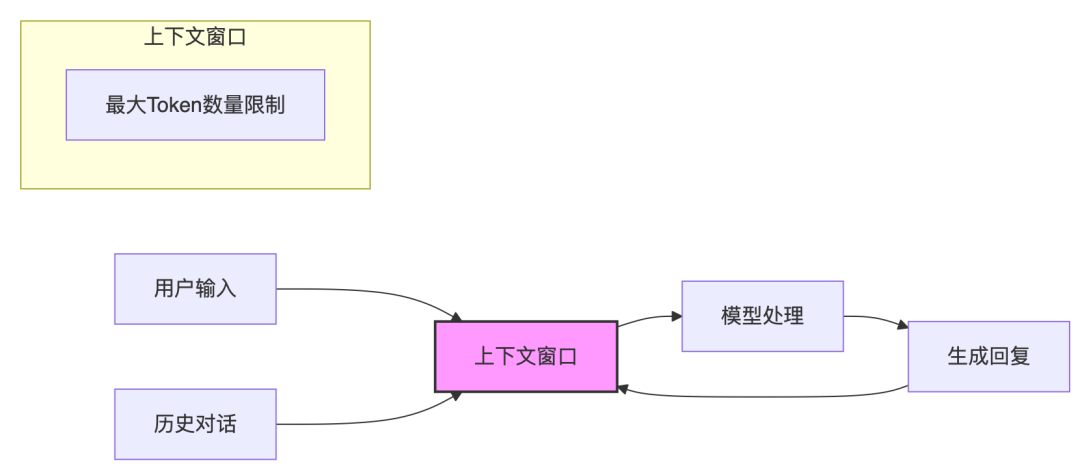

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 0

- 0

-

「企业AI实践」大模型破局之道:聚焦企业运营效率提升

年初的DeepSeek横空出世带领的大模型的喧嚣和冲动,不到半年的时间已经尘埃落定,归于平静,在当前经济增长放缓、收入增长缓慢、IT预算下降、早期大模型的试点乏善可陈的背景下,企业正面临一个核心问题:如何选择合适的场景推进大模型技术的落地?管理者必须面对的考量——是否值得投入?是否可控?是否能快速见效? 一、企业在部署大模型前必须解决三个核心问题:1. 投入是否值得?回报是否明确?企业经营之道,归…- 0

- 0

-

启发:消费级AI产品的未来洞察

以下采访基于 youtu.be/xFQ5mIJdxhA M: 各位mixlab社区的朋友们,大家好!我是mixlab的代表。我们mixlab作为一个跨学科社区,汇聚了来自不同背景的高学历人才,我们始终对前沿科技和商业模式的创新充满热情。 今天,我们非常荣幸地邀请到一位在消费投资领域极具影响力的传奇人物——4Erunner Ventures的联合创始人兼管理合伙人Kirsten Green女士,与…- 0

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 0

- 0

-

中国企业拥抱AI,为何仅9%实现显著价值?

一家汽车零部件工厂的车间里,技术总监老张滑动平板电脑,驾轻就熟调出实时生产数据。屏幕上滚动着由AI驱动的排产计划、质量检测报告和能耗分析。然而他依然眉头紧锁:“系统能精确识别焊接缺陷,却分析不了良率大幅波动的根本原因。我们在AI系统上投入了上千万,但生产线良率提升目标并没有实现。” 这样的情景在中国企业中并不少见。埃森哲最新发布的《2025中国企业数字化转型指数》报告发现,尽管中国企业在更广、更深…- 0

- 0

-

一不小心,AI CAD!跨界打劫!

hi~现在!大量的设施设备、建筑设计、制备生产流程!都围绕一份CAD图纸,设计-->生产,掺杂大量人工,重复+耗时!大到:铁路高铁装配零件的设计图,然后由专业部门人工审核,再发到工厂形成生产图,到流水线生产!小到:家里淋浴房,终端渠道商需要先与客户画一个3D设计图,然后发到工厂,工厂根据要求,画出各个配件型材生产图!如下,是一个淋浴房渠道商,传到工厂的CAD图纸:你可以在我司飞书云盘下载:h…- 27

- 0

-

Open AI 正在教我们如何构建自己的 Agents

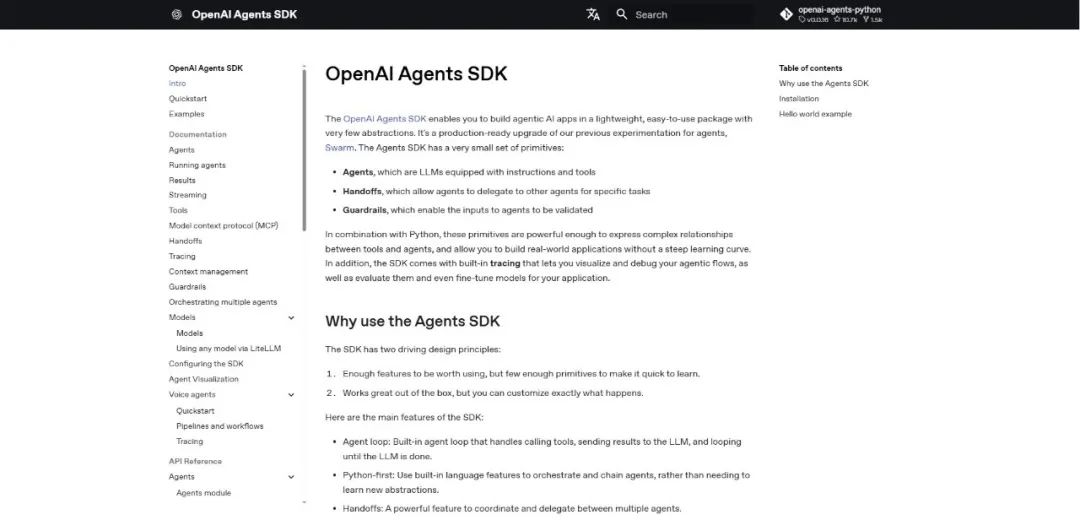

本播客由扣子空间(coze.cn)一键生成首先什么是 AgentOpen AI 给出的解释是:Agent 是能独立完成任务的系统,代表用户行事。它们由大语言模型驱动,能够使用工具、作出决策并能真正完成完整的工作流程。比如:处理退款、预订行程、更新数据库或撰写报告。所以那些只会回答常见聊天任务的大模型,不算是 Agent。能够连接工具,完成用户实际目标的大模型才是。什么时候才应该去构建 Agent不…- 2

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 1

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 1

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 1

- 0

-

AI 不止会答题,它还能“自己想”了?带你揭秘 Agentic RAG!

设想一下:你问 AI 一个复杂问题,比如: “请帮我分析一下OpenAI和Google在多模态技术上的布局差异,并预测未来三年的发展方向。” 大多数 AI 模型会像一个“背书机器”,努力从训练数据里翻找答案,或者从知识库里“检索+复制”。 但有一天,你的 AI 不再只是“信息搬运工”,而是像一个聪明的助理,先理解你的问题 → 再去查资料 → 还会判断哪些资料靠谱 → 最后整合一个条理清晰、逻辑自洽…- 6

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 1

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 2

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 2

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 2

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 14

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 2

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 8

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 9

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 2

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 7

- 0

-

AI工程化最佳实践:从技术狂欢到确定性红利

如何破解软件定制交付的“时间、成本、质量”不可能三角。 “帮我生成一套MES系统,具备设备监控、生产追溯等功能模块。” 短短10余分钟后,AI开发助手就能将一个菜单层清晰、功能完整、界面直观的业务系统呈现在眼前。 过去AI自动生成软件系统似乎是不敢想象、也几乎是不可能的事,但如今用户却能真实获得带演示数据的可运行系统原型,下一步的开发交付将更简单。20…- 22

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 9

- 0

-

AI写代码的“上下文陷阱”:为什么AI总是写错?如何系统性解决?

一、如何充分使用模型能力关键要点:完整+精确+聚焦的上下文是充分使用模型能力的关键。在这个认知之下思考如何系统性的构建满足这个条件的上下文? 合理的任务分解:本质上是在有限上下文宽度和注意力的约束下,怎么恰当的把握任务的复杂度边界,让模型能够在一个聚焦的任务上作业。 完整的背景信息:在一个真实的项目中写代码,需要理解系统架构和规范、了解业务需求、清楚关键代码实现路径、知道如何修改代码满足新的需求,…- 11

- 0

❯

购物车

优惠劵

搜索

扫码打开当前页

联系我们

返回顶部

幸运之星正在降临...

点击领取今天的签到奖励!

恭喜!您今天获得了{{mission.data.mission.credit}}积分

我的优惠劵

-

¥优惠劵使用时效:无法使用使用时效:

之前

使用时效:永久有效优惠劵ID:×

没有优惠劵可用!