-

一文吃透Dify账户系统:多租户 + 多登录方式 + 权限模型全揭底

之前写了篇10分钟搞定企业级登录!dify无缝集成LDAP实战指南,当时就是几个方法对接了LDAP,后来想了下对接规范吗? 本篇通过源码来释疑下。 实体关系模型 dify的账户系统,直接看api/models/account.py就行了,里面包含了相关的实体 111110..*0..*0..*0..*1Account+String id+String name+String email+Str…- 17

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

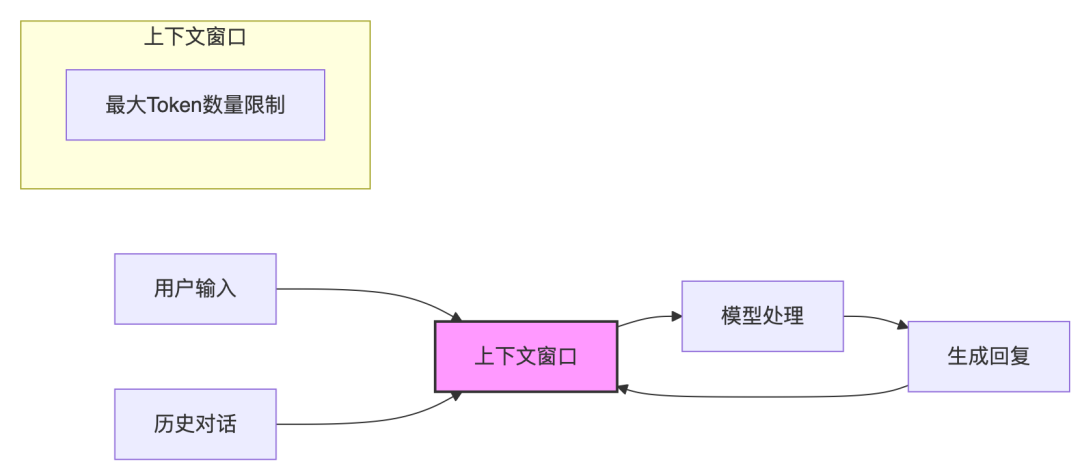

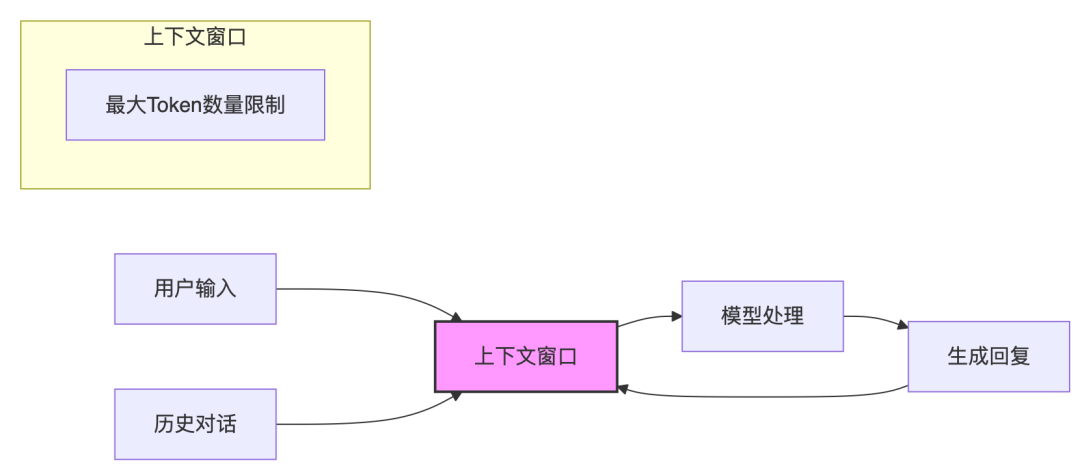

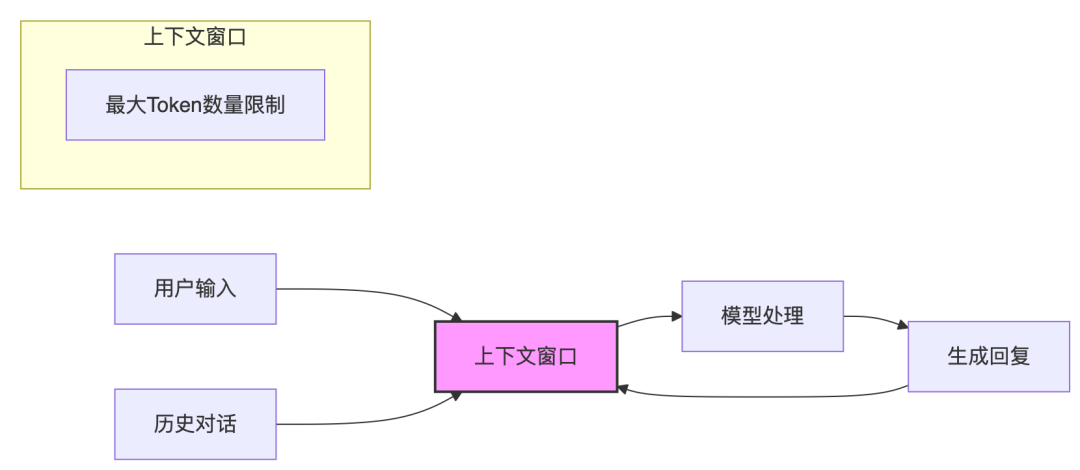

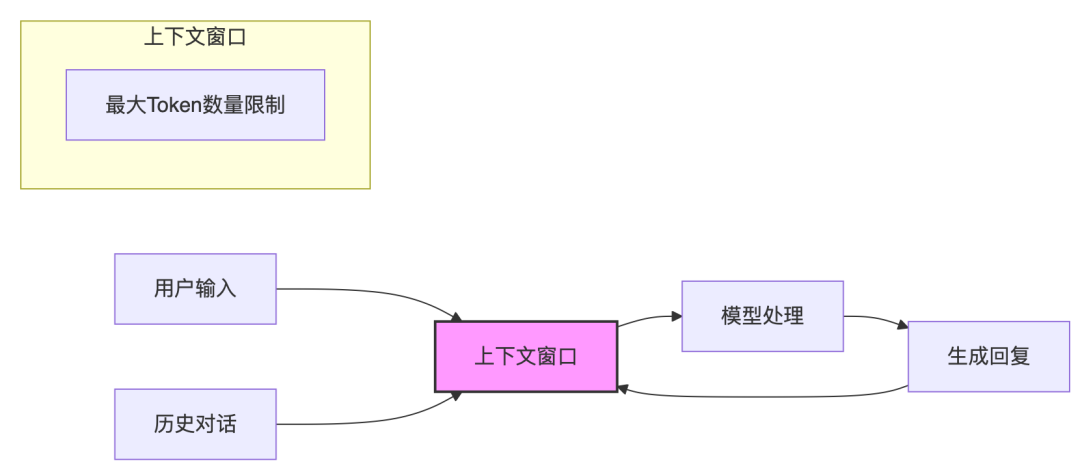

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 1

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 1

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 2

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 2

- 0

-

没有RAG的突破,一切Agent都是纸老虎

在经历了无数ToB与ToC项目的洗礼后,一个残酷的现实愈发清晰:要让各方(客户、用户、开发、产品、老板)在AI应用的认知上对齐,并最终共同完成有价值的交付,我们面前的路,远比想象中漫长。AI的“魔力”在实验室和Demo中令人惊叹,但在真实世界的复杂泥沼中,却频频遭遇尴尬时刻。 一、AI应用两大尴尬时刻:1、“不像人”的专家:隐形知识的鸿沟 大模型的回复常常缺乏“人味儿”,更难以像领域专家般思…- 2

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 2

- 0

-

ToB 增长的残酷拐点:会不会用 AI,才是生死线

红衣教主要干掉市场部?市场部成了目前市场环境下的第一个牺牲品?除此之外,客户成功团队(CSM)会不会是下一个被 AI 干掉的岗位?在 AI 席卷一切的风口下,ToB 行业最讽刺的现状是:人人都在谈增长,真正能跑出来的,却寥寥无几。有人还在幻想靠一个爆款广告、一个爆火话题就能收割订单;有人自嗨着把大模型当万能药,却没发现客户早就不吃这一套了。真正的穿透式增长从来不是靠一招鲜,而是靠一套体系 ——&n…- 3

- 0

-

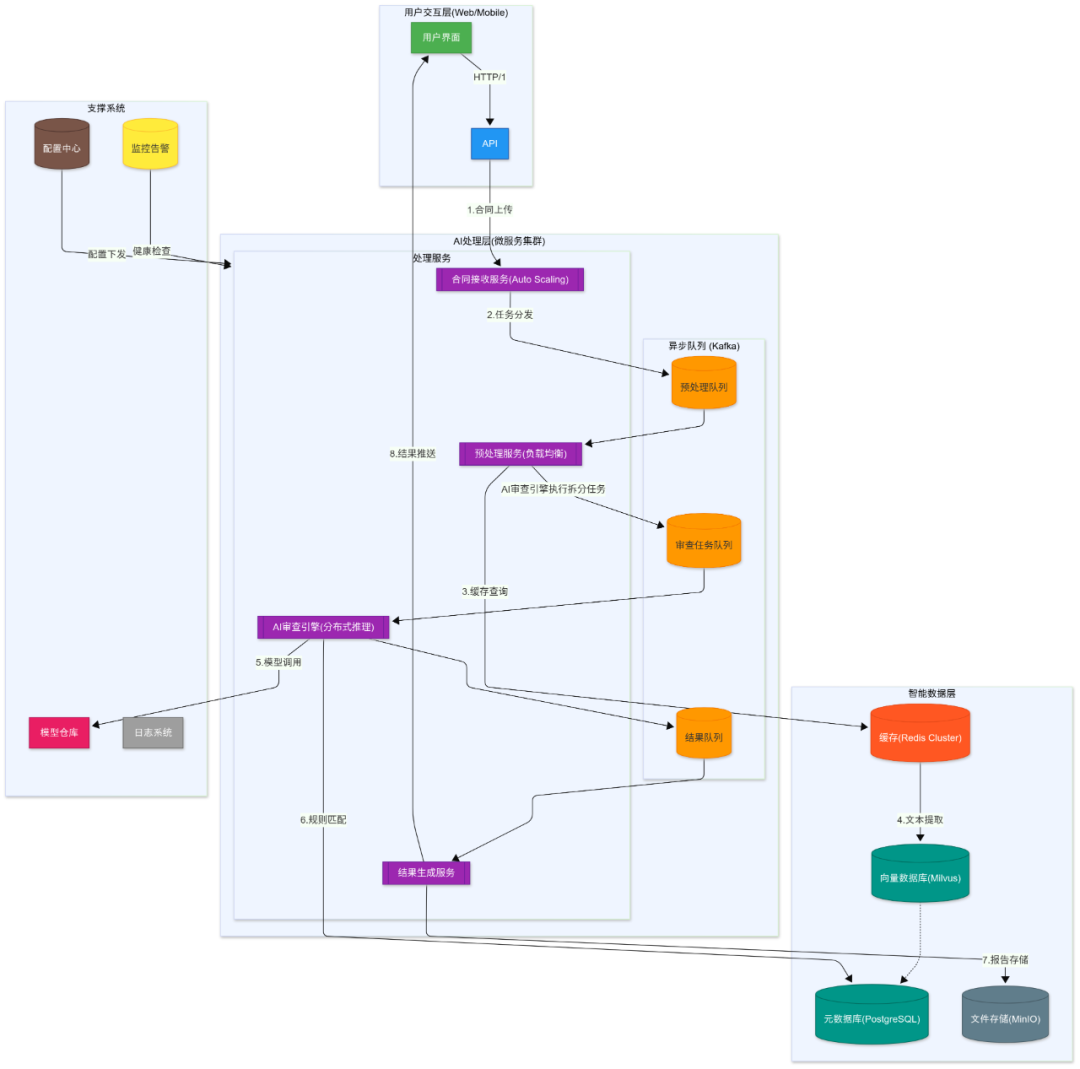

AI+合同审查项目落地分享(中)

接AI+合同审查项目落地分享(上)发布后,有很多行业内的小伙伴感兴趣,如果文章能给大家工作带来一些些帮助,我非常开心,我写文章的本意也是想借由自己的一些项目经历,让别人看到项目的价值同时少踩一些坑。根据大家留言私信的情况,我可能会对分享的安排做一些微调,所以欢迎你留下自己的想法,让更多人看见~整体的分享目录如下:AI+合同审查项目落地分享(上) 上期回顾:项目价值定位;用户与场景;核心功能与解决方…- 3

- 0

-

Prompt、Context、Memory:一组漫画带你了解大模型交互的三段技术演进

你说:“帮我列下今天的会议日程。” 它迅速回复:“9 点产品部,11 点市场部,下午 2 点财务汇报。”——完美。 你接着说:“那顺便把上次年会的讨论要点也整理一下吧。” 它却停顿了片刻,回复道:“很抱歉,我找不到相关记录。” 这是当下所有大模型的共性问题:反应迅速,却没有记忆;任务执行高效,却无法延续认知。 每次对话都像“第一次见你”,每轮任务都要从头讲起,它可以生成内容,却无法积累状态,也无法…- 3

- 0

-

OpenAI 工程师最新演讲:代码只占程序员核心价值的 10%,未来属于“结构化沟通”

编译自 ai.engineer出品 | CSDN(ID:CSDNnews)原文 | https://www.youtube.com/watch?v=8rABwKRsec4投稿或寻求报道 | zhanghy@csdn.net最近外网看到了一个很火的 AI 工程师大会,叫 AI Engineer World's Fair,拿了微软和亚马逊的赞助,不清楚背后组织人是谁。会议阵容比较豪华,所以精…- 2

- 0

-

大模型如何赋能 Web 渗透测试?

背景和目标在网络安全领域,漏洞检测是一项至关重要且复杂的工作。随着Web应用规模的扩大和攻击手段的多样化,传统的人工检测方式已难以应对日益增长的安全需求。传统Web安全扫描器依赖预设规则库和模式匹配,难以应对新型漏洞及复杂业务逻辑中的隐性风险,且易产生误报和漏报;人工测试虽能深入分析漏洞,但受限于人力成本高、执行周期长,面对海量代码和频繁更新的应用时效率低下。 而大语言模型(LLM)凭借其强大的上…- 5

- 0

-

深度研究-Context Engineer上下文工程+MCP集成能否取代AI Agent+Workflow?

大家好,我是人月聊IT,今天继续分析关于AI上下文工程和AIAgent的深度研究分析,具体提示词如下:请详细分析论证当前AI大模型里面提出的上下文工程context engineer+MCP的结合 能否完全取代AI Agent+workflow。如果不能完全取代,那么哪些能取代,哪些还不能完全取代,不能取代的地方有没有其他变通方法解决。下面是Google DeepResearch研究报告参考: 第…- 2

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 2

- 0

-

分析为什么AI代码生成赛道如此火热?

前言:史无前例的赛道热度 当你看到百度文心快码、字节跳动Trae、阿里巴巴通义灵码、腾讯CodeBuddy、Google Gemini CLI、Amazon Kiro、Microsoft GitHub Copilot、OpenAI Codex、Anthropic Claude Code等巨头产品同时出现在一个赛道时,同时在加上很多创业公司的产品:Cursor、Replit、windsurf、Bol…- 1

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 2

- 0

-

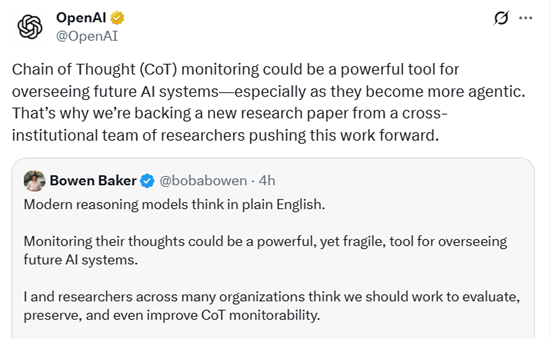

刚刚,OpenAI发布CoT监控,增强AI Agent自主能力

专注AIGC领域的专业社区,关注微软&OpenAI、百度文心一言、讯飞星火等大语言模型(LLM)的发展和应用落地,聚焦LLM的市场研究和AIGC开发者生态,欢迎关注!今天凌晨,OpenAI发布了最新技术论文思维链(CoT)监控,用来监督AI Agent等AI系统使得它们的自主性更强。 有网友表示,针对生产环境中的AI Agent而言,这一点至关重要。几个月来,我们一直在运行Mario和Er…- 4

- 0

-

AI Agent&MCP的工程化实践-系列4-模型的可观测工程

写在前面 👀在Trajectory的实现中,参照了一些开源的实现,主要是字节的trae Agent和langgraph的源码。这里在看字节的Trae agent的过程中,也顺带改了一个小bug,下一篇会讲下trae agent的源码解析,主要聚焦在几个方面: prompt是怎么写的? benchmark是如何做的? 有一个奇怪的多轮对话的报错,是为什么? 另外下一步会看下PromptX的实现,据说…- 6

- 0

-

让审批快起来!DeepSeek大模型赋能政务申办受理平台的实践路径

审批提速,早就不是“可选项”,而是“刚需”。 一边是老百姓盼着少跑腿、快办事;另一边是政府部门顶着压力,推进流程再造和系统整合。 特别是在建设“数字政府”成为全国共识之后,各地都在加速推动政务服务的统一入口建设。而在这个过程中,北京市提出的“统一申办受理平台”被寄予厚望,目标是打造一个“只进一个门,办遍全事项”的政务服务底座。 但平台做得再统一,如果流程还是靠人判断、材料还要一张张看、政策更新还得…- 4

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 3

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 1

- 0

-

瓦力不哭,Agent 不写 SQL

在Agentbase 登场进入倒计时" data-itemshowtype="0" linktype="text" data-linktype="2">老夫聊发少年狂:扎克伯格豪赌华人天才少年,Meta 下注数据智能未来;数据库退场,Agentbase 登场进入倒计时一文中,我写了这么一句话: “AI Agent 开启另一…- 4

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 3

- 0

❯

购物车

优惠劵

搜索

扫码打开当前页

联系我们

返回顶部

幸运之星正在降临...

点击领取今天的签到奖励!

恭喜!您今天获得了{{mission.data.mission.credit}}积分

我的优惠劵

-

¥优惠劵使用时效:无法使用使用时效:

之前

使用时效:永久有效优惠劵ID:×

没有优惠劵可用!