-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 1

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

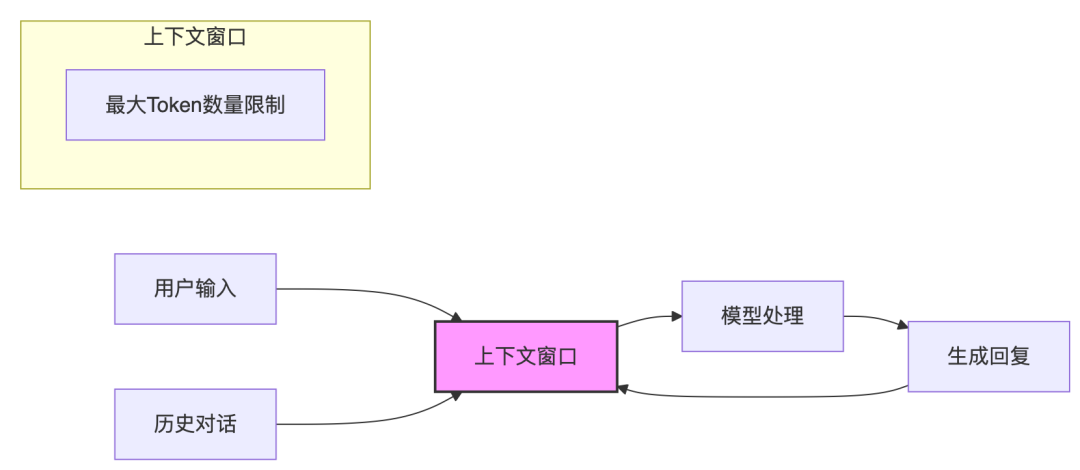

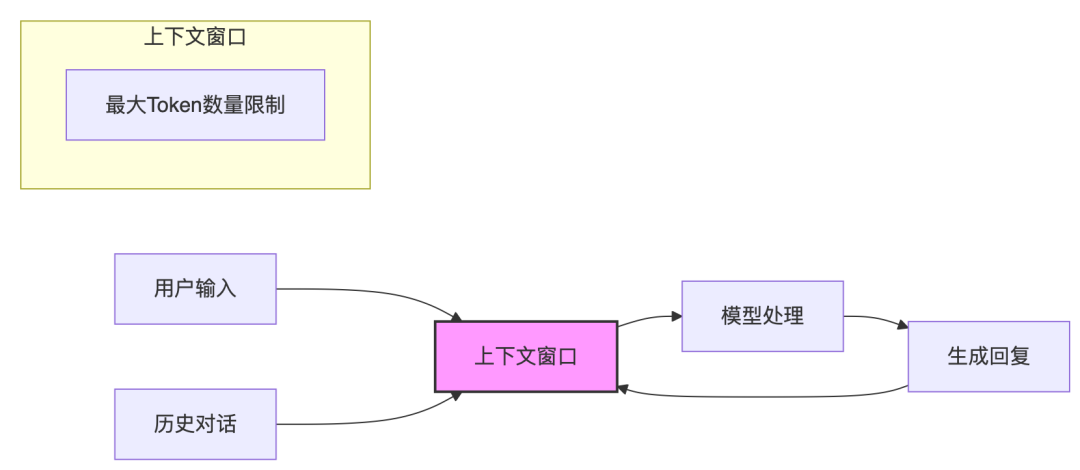

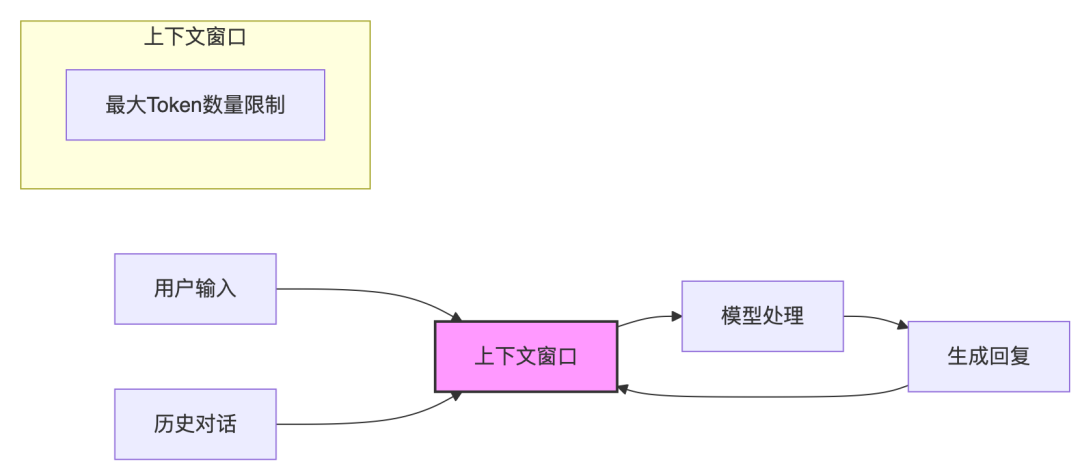

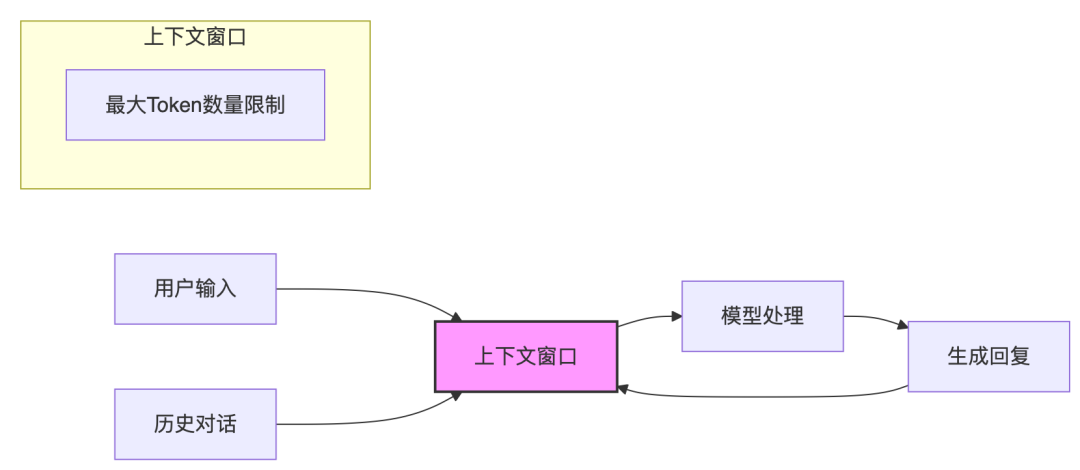

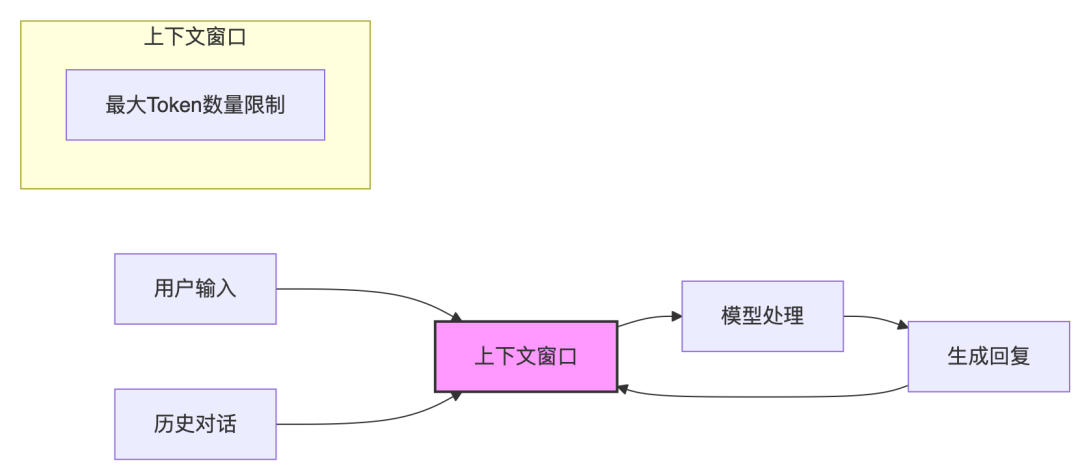

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 4

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 3

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 1

- 0

-

Google GenAI Processors:重新定义实时AI开发架构

文|祝融 编辑|郭嘉 <------最重要的是订阅“鲁班模锤”------>构建复杂的AI应用,特别是处理多模态输入并需要实时响应的应用,经常感觉像是在拼装复杂拼图:需要将不同的数据处理步骤、异步API调用和自定义逻辑拼接在一起。随着复杂性的增长,这可能导致脆弱、难以维护的代码。2025年7月,Google DeepMind发布了GenAI Processors,这是一个专为解决这些技…- 5

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 3

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 2

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 3

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 3

- 0

-

麦肯锡:为什么 90% 的工作汇报都是 “无效输出”?

(本文及展示的PPT模板,来自于《麦肯锡思维与图表轻松学》,见文末) 你是否经历过这样的场景: 财务专员小林拿着厚厚的成本分析报告,从各项费用明细讲到数据来源,汇报了十分钟,领导却打断他:“所以这个项目到底能不能盈利?”; 运营岗小陈分享活动方案时,先讲活动流程设计,再谈物料准备,最后才提到 “预计能带来 5000 笔订单”,但领导早已失去耐心。 更让人无奈的是,经常在汇报结束后,汇报者得到的答复…- 2

- 0

-

生成、并购、竞速:ToB AI 有下半场吗?

从 Lovable 七个月干出 8000 万美金,到英伟达一年翻倍市值破 4 万亿,再到飞书、钉钉、阿里、腾讯一个个把 AI 办公工具卷到细胞级自动化,ToB AI 的赛道已经没有观众席,谁都得下场跑。 一边是初创团队 35 个人就能跑出传统科层制 1/5 的开发周期,一边是巨头们花几亿美金挖人、买技术、抢芯片,还顺手把 “生成即用” 从 PPT、表格做到视频、原型和浏览器,连写周报都要 AI …- 5

- 0

-

DASF:可落地,易执行的AI安全框架

随着AI大量使用,对AI的安全担忧越来越多。如何完整梳理AI系统面临的安全风险,及如何消减风险,需要一个完整的系统化的方法论。之前我们介绍过Google的SAIF(Google的AI安全框架(SAIF)),该框架比较完整,但比较高阶,讲明白了原理,但不够具体,可操作性差。此次介绍 Databricks的安全框架(Databricks AI Security Framework (DASF) ),非…- 3

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 1

- 0

-

Agentbase 协议:记忆、任务与系统重构的三部曲

本文来讲讲我提出 Agentbase 的来龙去脉,探讨其核心要素,会催生哪些新的职业,以及对每个人的新机遇。 让我用 Dead poet society 中的一句话开篇:Carpe Diem, seize the day boys, make your lives extraordinary. That the powerful play goes on, and you may cont…- 11

- 0

-

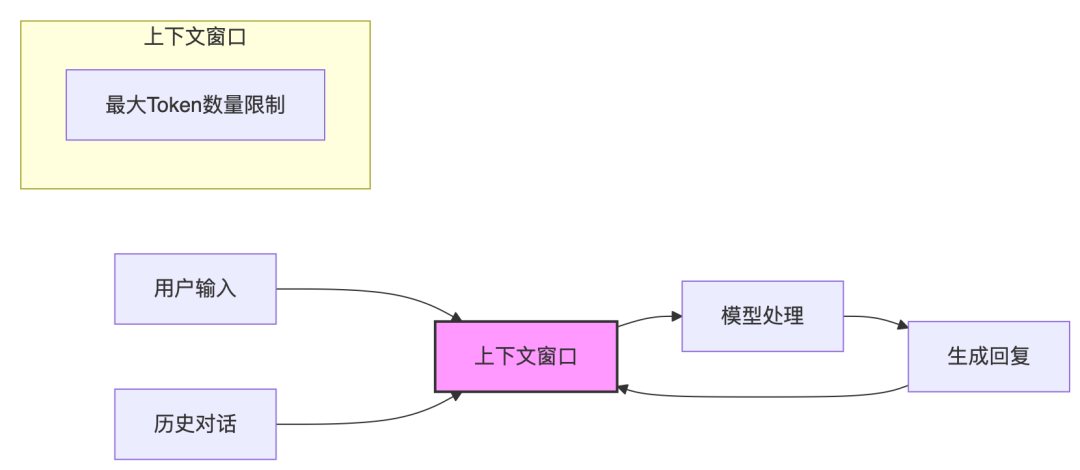

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 6

- 0

-

中顺洁柔CIO杨森林:决策AI实战,不生成图文,只生成利润

这几年的AI热潮里,生成式AI显然得到了更多关注。相较而言,决策式AI的叙事有点低调。相比于看得见的图文、视频生成结果,决策式AI的成果更多藏在我们看不到的地方。 比如一盒平平无奇的纸巾,从工厂生产出来再历经仓储、运输、经销、售卖、结账成交,最终来到你的手里,整个环节里,哪一条运输路线是最优选择?在哪些超市上架更容易被目标消费者买到?在上海应该怎样定价?在四川攀枝花又该怎么定价?&nbs…- 5

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 3

- 0

-

深度解读 | 麦肯锡:全球企业使用生成式AI调研报告

2025年3月,麦肯锡对全球1491名企业高管及员工进行的调研,旨在调研企业使用生成式AI的情况,并发布了调研报告《The State of AI: How Organizations Are Rewiring to Capture Value(企业如何重塑组织结构以释放生成式AI价值)》。这篇调研报告为大家揭示了全球企业实际使用生成式 AI的现状和问题,点击阅读原文可以下载报告。 本文对报告的核…- 4

- 0

-

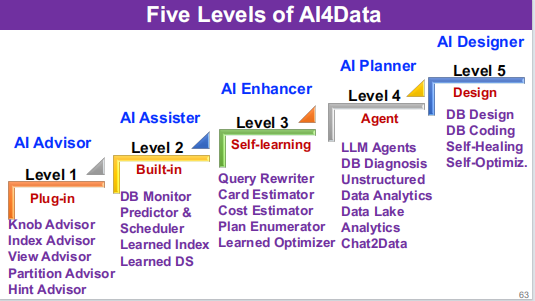

Data Agent:开启数据与 AI 融合的新时代

在人工智能飞速发展的当下,数据与 AI 之间的协同却面临着诸多阻碍。而 Data Agent 的出现,正为打破这一局面带来了曙光。一、Data Agent概念Data Agent 是一种具备自主性的系统,它凭借知识理解、自动规划和自我反思能力来执行数据任务。这一特性让它能够摆脱对人工的过度依赖,自主地完成复杂的数据处理工作。其目标主要有两个方面。一方面,是弥合数据与 AI 之间的语义鸿沟,包括数据…- 9

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 7

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 3

- 0

-

【深度】一文看懂Grok 4及“多智能体内生化”的AI新范式

就在几天前,马斯克的xAI正式发布Grok 4大模型,号称世界最强AI。我们团队这几天仔细研究了Grok 4相关的研究资料,有一些新发现,对未来AI产业趋势及算力展望具有一定价值,遂整理成此文,用一篇文章的篇幅给大家介绍清楚Grok 4的发展脉络。核心要点:Grok 4的核心创新是在训练阶段引入多智能协作,即“多智能体内生化”OpenAI o1实现了“思维链内生化”;Gemini实现了“多模态内生…- 6

- 0

-

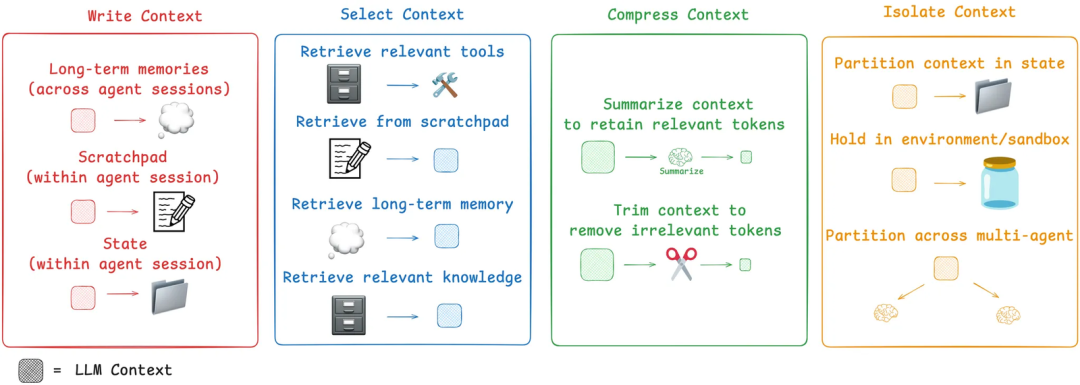

Context Engineering(上下文工程)是 AI Agent 成功的关键吗?

前段时间 OpenAI 的前研究员 Andrej Karpathy 提出一个新的名词:Context Engineering。他将 LLM 比作计算机的处理器(CPU),而其上下文窗口则相当于内存(RAM)。最近看到一篇发表在 langchain 博客里面的文章:Context Engineering(链接见文末),让我对这个概念的理解更加深刻。 上下文工程(Context Engineeri…- 5

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 2

- 0

❯

购物车

优惠劵

搜索

扫码打开当前页

联系我们

返回顶部

幸运之星正在降临...

点击领取今天的签到奖励!

恭喜!您今天获得了{{mission.data.mission.credit}}积分

我的优惠劵

-

¥优惠劵使用时效:无法使用使用时效:

之前

使用时效:永久有效优惠劵ID:×

没有优惠劵可用!