-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

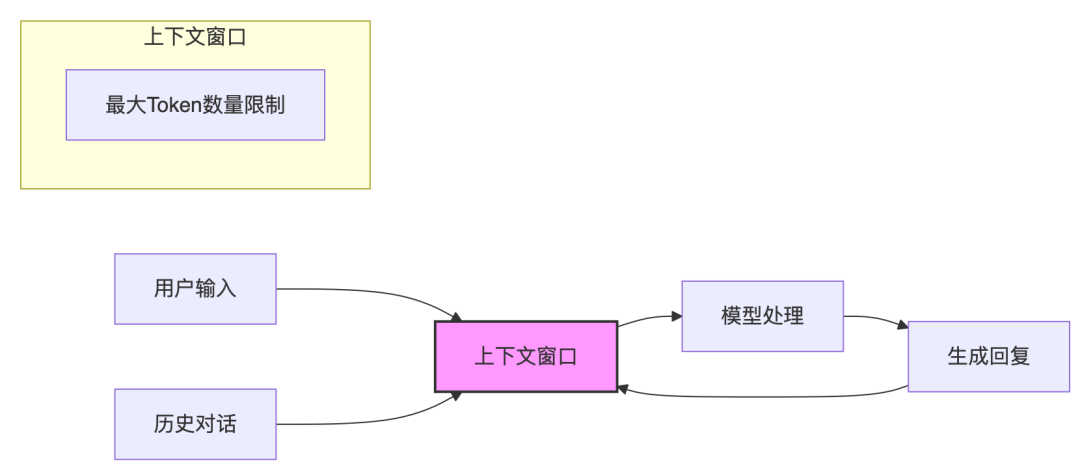

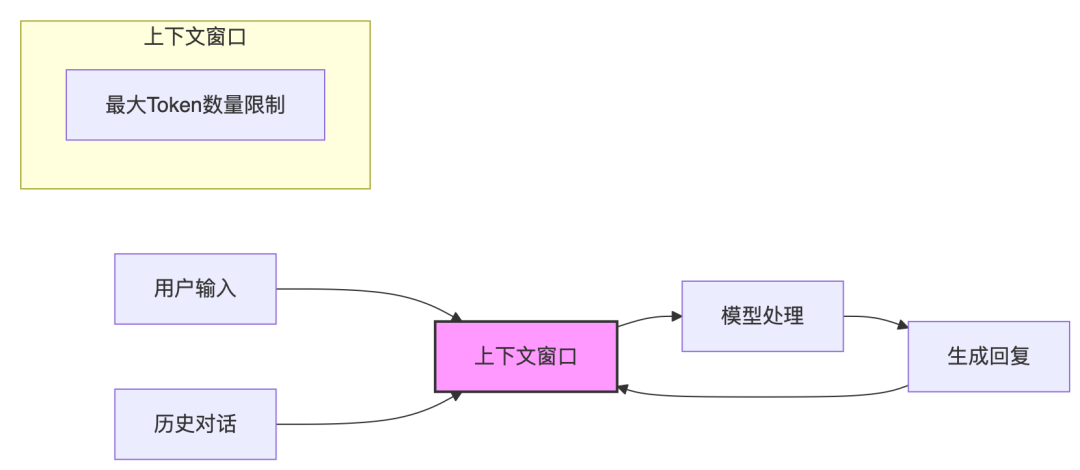

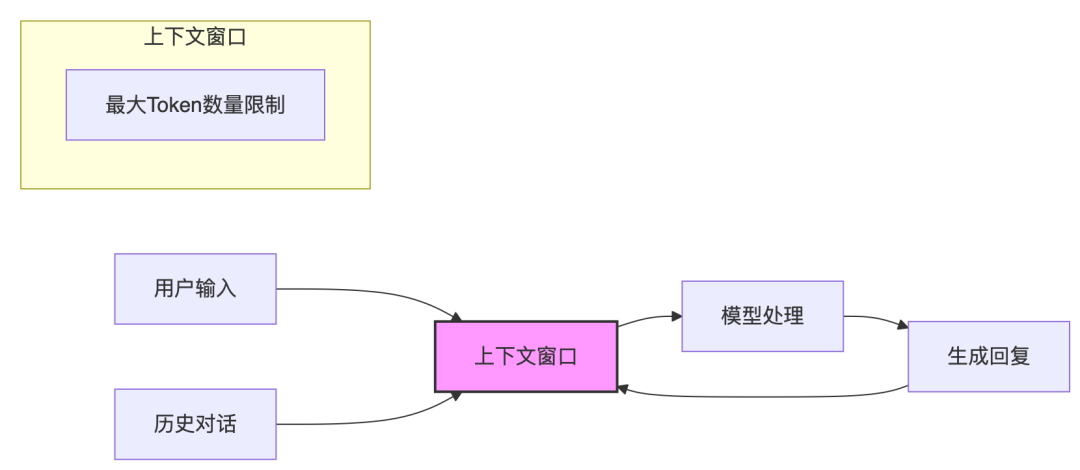

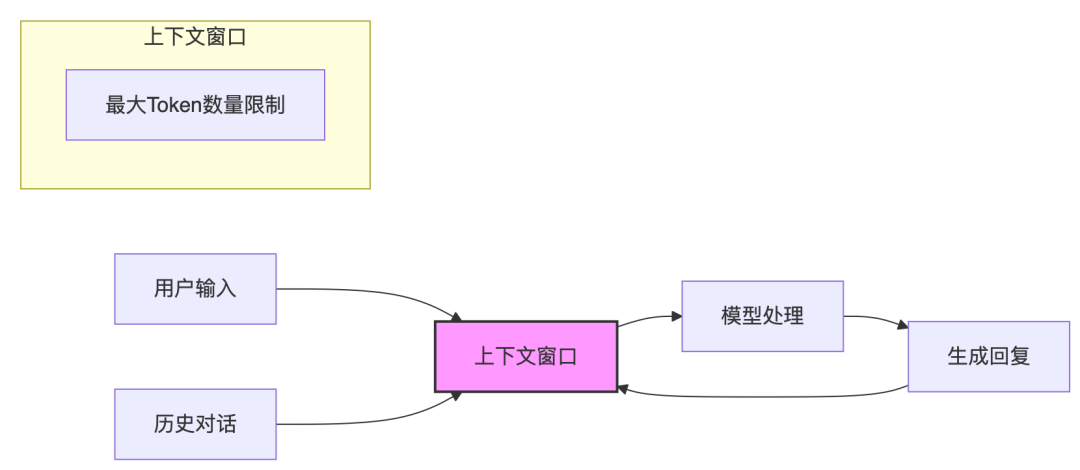

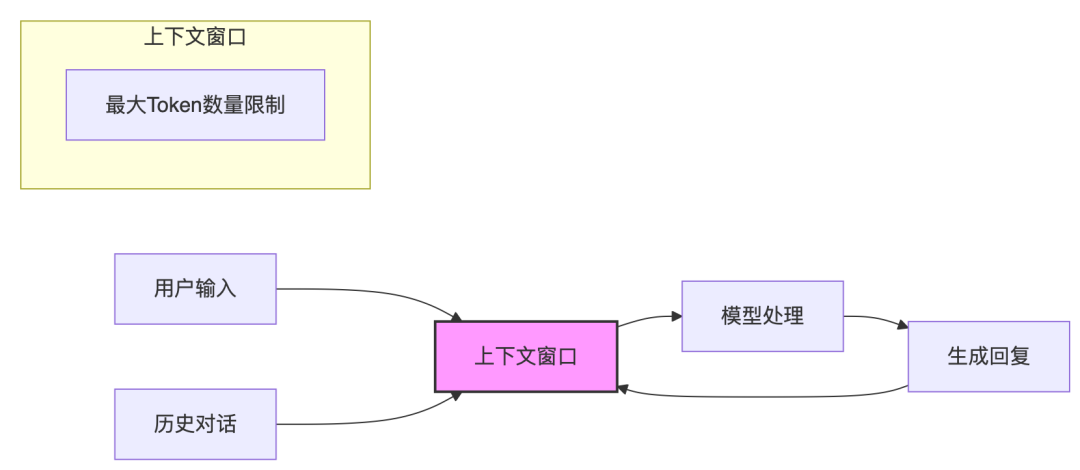

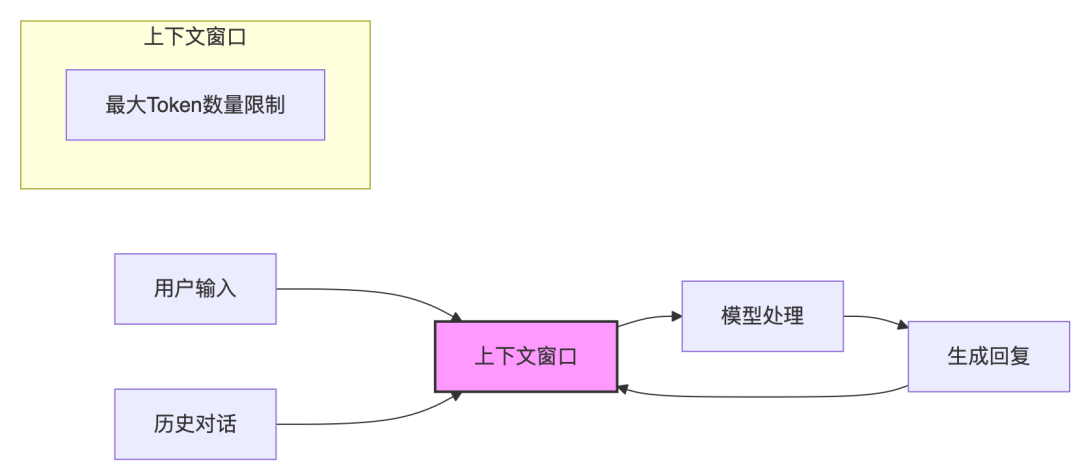

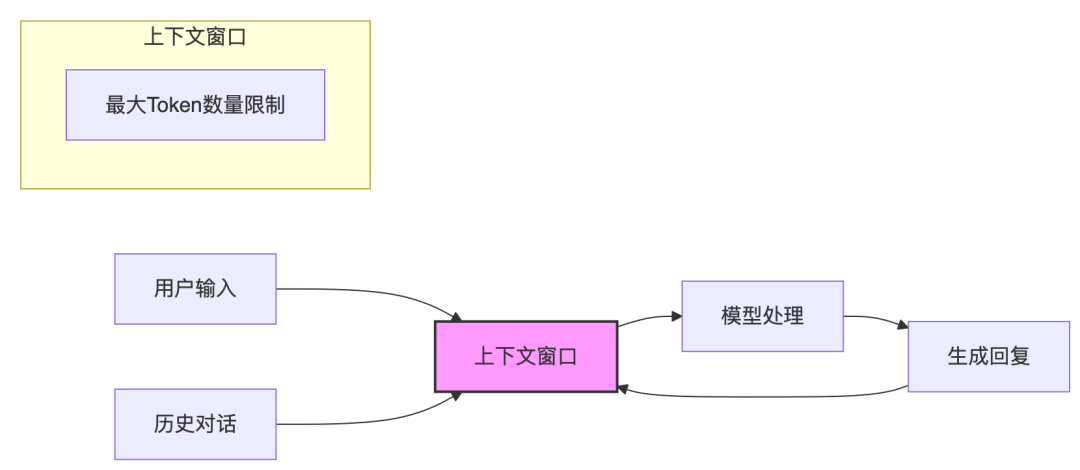

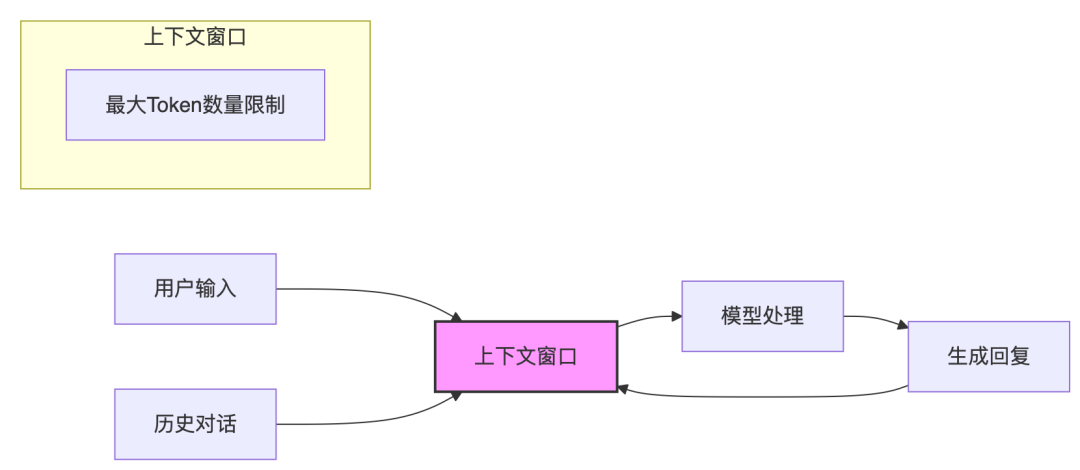

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 6

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 3

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 5

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 4

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 5

- 0

-

AI圈演义:我躺平两年多,终于看懂了这场“智能的游戏”

点击上方蓝字关注我们题图:才说完Grok 4,KIMI K2也想挤进圈:以Agentic的名义? “𝕀²·ℙarad𝕚g𝕞智能平方范式研究的另一种写法特大号范式 笑看大模型公司轮番上阵加速演进,而Meta在囤人,看来这两年躺平观察是上策啊?! 按:正说完Grok 4,还在琢磨下一个是不是DeepSeek呢,KIMI 1T参数K2开源了,嘴里还叨叨着啥“agentic”?而OpenAI叨叨好久的开源…- 5

- 0

-

结果交付:企业级LLM+MCP+RAG+Agent融合架构正在重构AI基建标准!

在AI开发的浪潮中,我们经常面临这样的困境:RAG系统能够基于外部知识回答问题,但缺乏执行复杂任务的能力;而Agent系统虽然能调用各种工具,但往往缺乏深度的知识理解。如何将二者优势结合,打造一个既能"博览群书"又能"动手实践"的智能系统? 经过几个月的技术探索和实践,我们基于MCP(Model Context Protocol)协议,成功构建了一套&quo…- 8

- 0

-

深度|a16z内部复盘:AI社交产品或许从根本上就不成立,AI只是模拟“表达”,从未触碰“关系”本身

图片来源:a16z 在过去十年里,每一次消费级产品的爆发,几乎都伴随着一次社交范式的重构:从 Facebook 的好友动态到 TikTok 的算法推荐,我们逐渐学会用产品定义自我、表达身份。 那时的产品,是人在表达,产品在辅助;而如今,AI 正在悄然完成一次角色反转——它不再是人的工具,而开始成为表达的主体、连接的中介,甚至情感的承载者。从 ChatGPT 到 Veo3,从 11 Labs 到 C…- 7

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 3

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 3

- 0

-

飞书搞了个AI分级体系,一上线就把一堆产品打回原形了

“飞书想建立AI产品分级体系,它的底气是什么?大数据产业创新服务媒体——聚焦数据 · 改变商业 2025年,AI几乎无处不在。从智能助理到AI会议纪要,几乎每一家To B软件公司都在快速叠加AI能力,争抢“AI+办公”的未来入场券。对企业而言,仿佛不接入AI,就像还在用功能机时代的办公系统。但热闹背后,越来越多企业管理者陷入一种“AI疲劳”:许多AI功能看起来令人惊艳,真正上线使用后,却不是响应缓…- 3

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 5

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 7

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 8

- 0

-

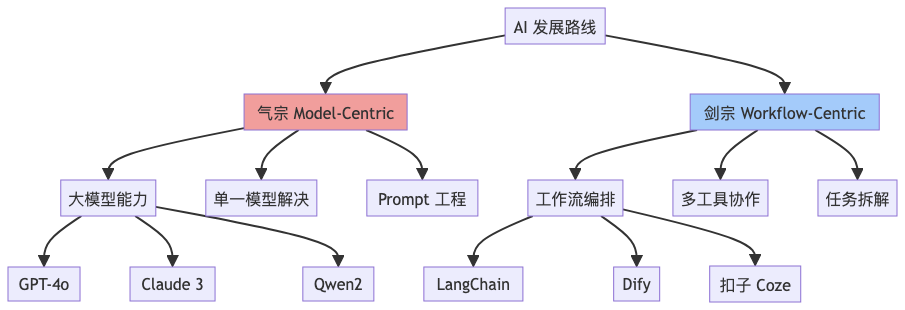

Auto Agent:气宗还是剑宗?——Workflow 还是强大模型?

Agent%E6%9E%84%E5%BB%BA%E6%9C%89%E4%BA%86%E4%B8%80%E5%AE%9A%E7%9A%84%E4%BA%86%E8%A7%A3%EF%BC%8C%E8%BF%99%E7%AF%87%E6%96%87%E7%AB%A0%E4%B8%BB%E8%A6%81%E6%A0%B9%E6%8D%AE%E4%B8%AA%E4%BA%BA%E7%BB%8F%E9%AA…- 8

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 5

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 1

- 0

-

“内卷”到向量空间:Qwen3-Embedding 是真香还是跟风?

在这个大模型“千模一面”的时代,就连“词向量”都开始内卷了。 还记得小时候玩过的七巧板吗?每一块形状不同,但拼在一起能组成一只鸟、一个房子、甚至是一颗爱心。而 embedding,就是给文字、图片甚至一段代码,找出它们在“高维空间”里那一小块属于自己的形状。这样AI就能“看图识意”“读字识人”。 今天,我们就来聊聊阿里出品的 Qwen3-Embedding,看看它在一堆“向量卷王”里,到底是实力派…- 3

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 8

- 0

-

AI安全审计模型哪家好?

很久没更新安全这块,最近也在沉浸学习AI应用落地,也积累了一些心得经验。我们这边使用的是本地部署的GPU模式,算力不算很大,能够测试搭建Demo也是不错的。很多人可能更多的会使用付费或者免费的外部模型进行,但涉及到内部的敏感数据,可能也不是长久之计。因此在AI时代,数据安全也呈现挑战。一边需要员工使用AI进行提效,另一边还得加强AI数据安全合规,先说说提效的方面吧,本次主题也是使用AI来进行审计,…- 5

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 3

- 0

-

Agent KB:让Agent越用越聪明!

很值得仔细琢磨的一篇论文,58页,作者主要来自oppo,oppo最近还发了好几篇Agent的论文,都挺不错的~这个工作讲的是如何沉淀Agent过去的执行经验,让Agent性能越来越好。论文:https://arxiv.org/pdf/2507.06229代码:https://github.com/OPPO-PersonalAI/Agent-KB先看结果,提升很大。 分别在GAIA、SWE 上验证了…- 5

- 0

-

GitHub上5.4k+Star爆火,构建生产级Agent 的12因素

这是一篇在GitHub上获得5.3k+星标的重要技术文档,其中蕴含的洞察值得每一位AI产品开发者深度思考。作者Dex是一位资深的AI工程师,他试遍了市面上几乎所有的Agent框架——从广受欢迎的LangChain到号称"生产级"的LangGraph,从协作式的CrewAI到各种新兴的解决方案。并且他与大量来自Y Combinator的技术创始人深入交流,观察他们如何在实际商业环…- 6

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 4

- 0

❯

购物车

优惠劵

搜索

扫码打开当前页

联系我们

返回顶部

幸运之星正在降临...

点击领取今天的签到奖励!

恭喜!您今天获得了{{mission.data.mission.credit}}积分

我的优惠劵

-

¥优惠劵使用时效:无法使用使用时效:

之前

使用时效:永久有效优惠劵ID:×

没有优惠劵可用!