-

你的大脑真的在被AI“腐蚀”吗?

最近,MIT一份关于“使用ChatGPT是导致认知债务累积”的研究报告引发了不小的争议。不少媒体报道,216页的研究报告直指使用AI可能让大脑降智。“ChatGPT让大脑萎缩47%”等耸人听闻的标题层出不穷,不少AI使用者感到焦虑。然而,仔细研读这份长达206页的研究报告就会发现:媒体的解读很大程度上偏离了核心结论,复杂的科学研究被简化为了非黑即白的断言。实际上,MIT的研究并没有支持“使用AI会…- 6

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

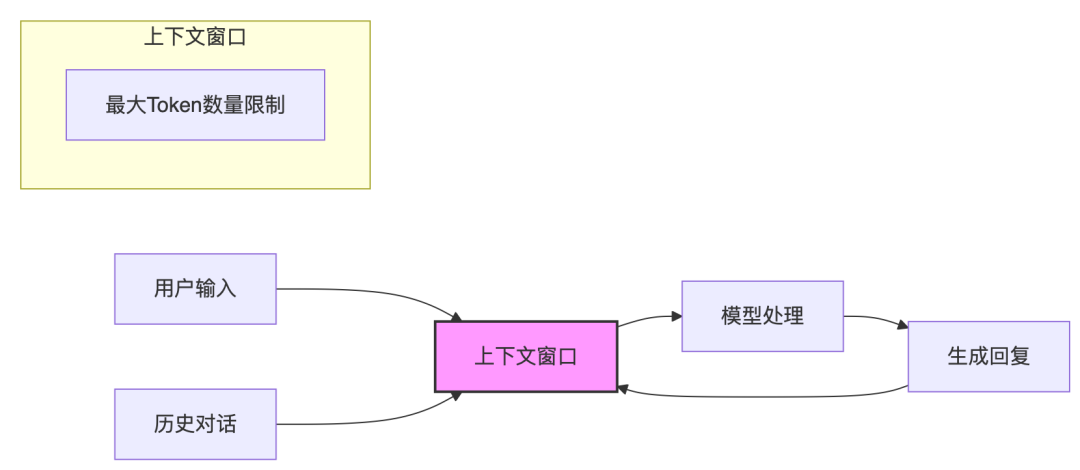

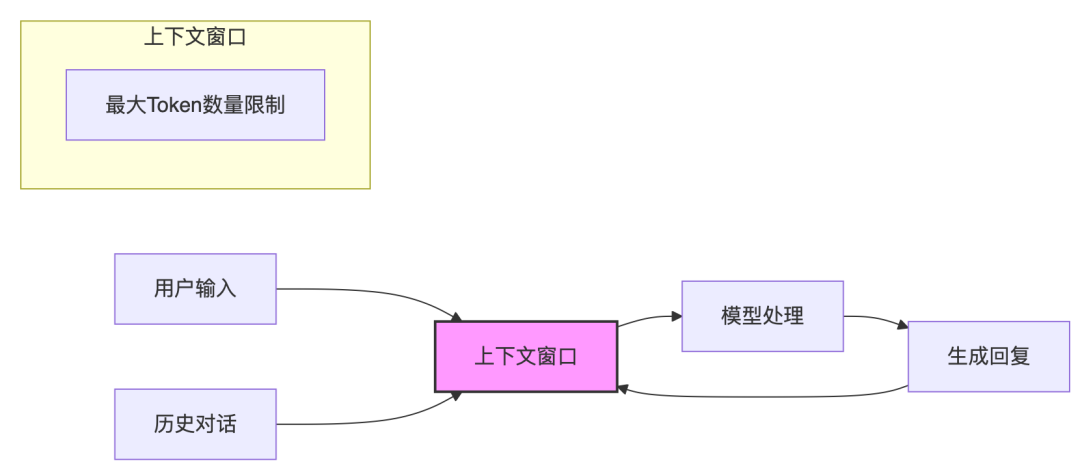

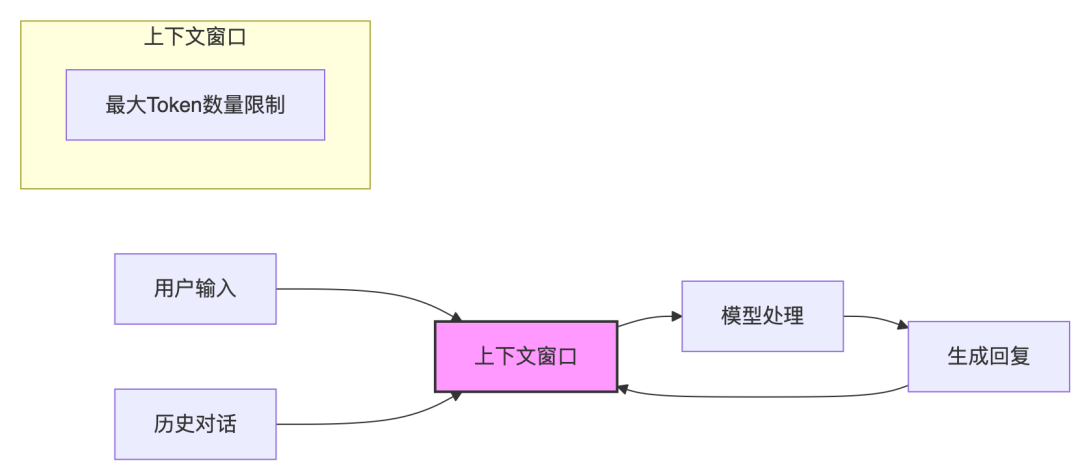

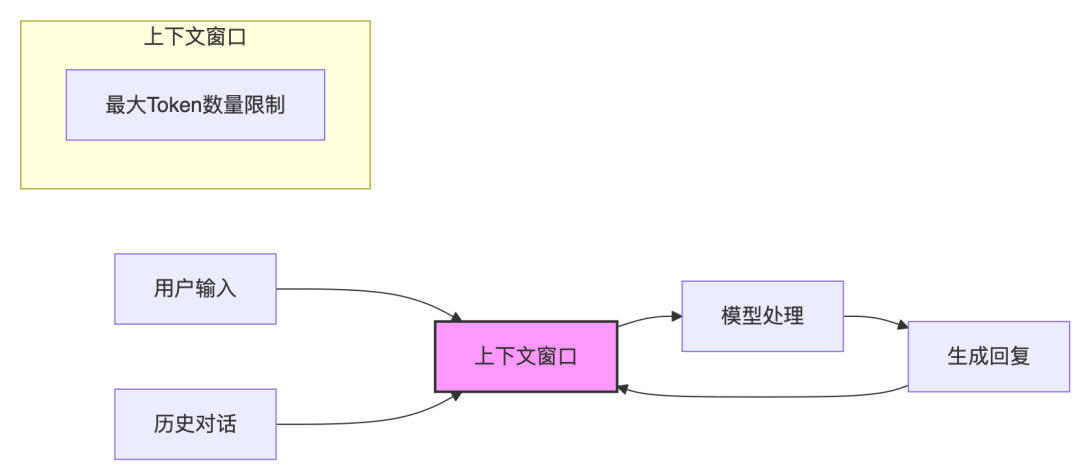

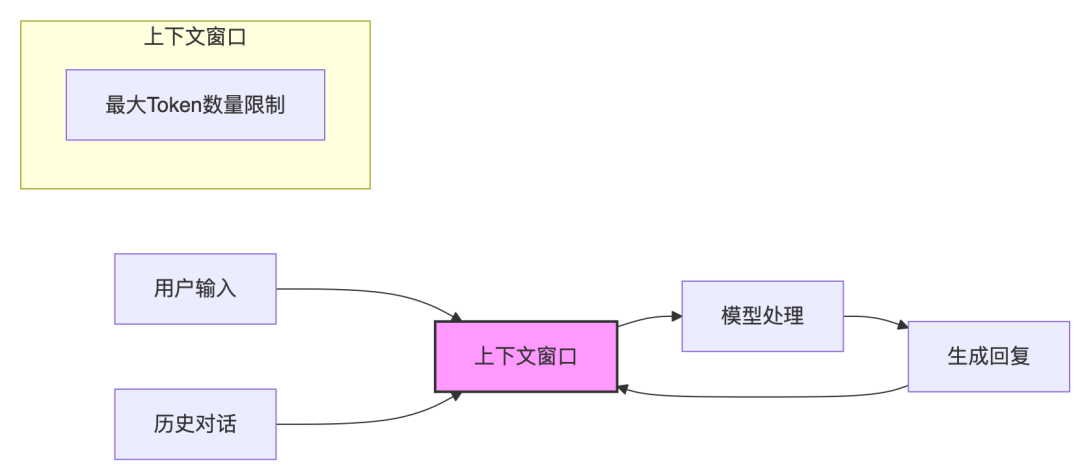

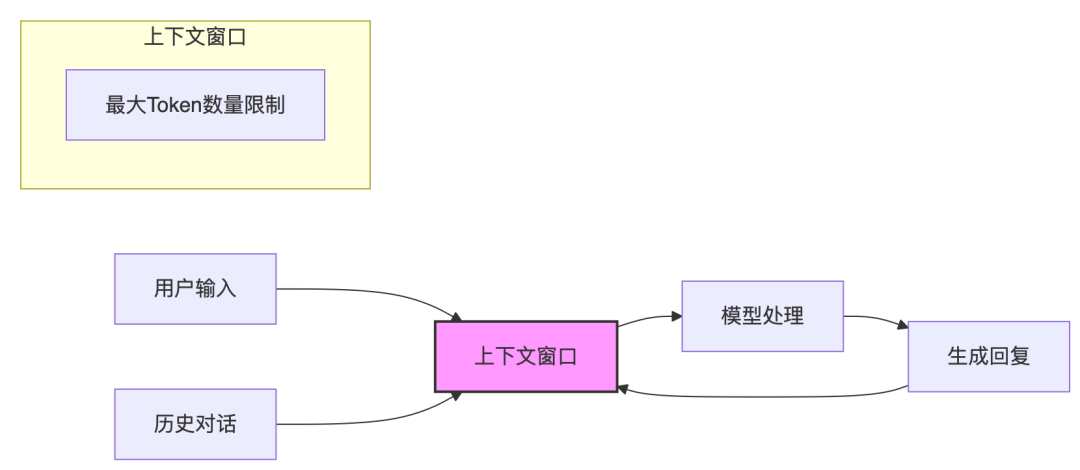

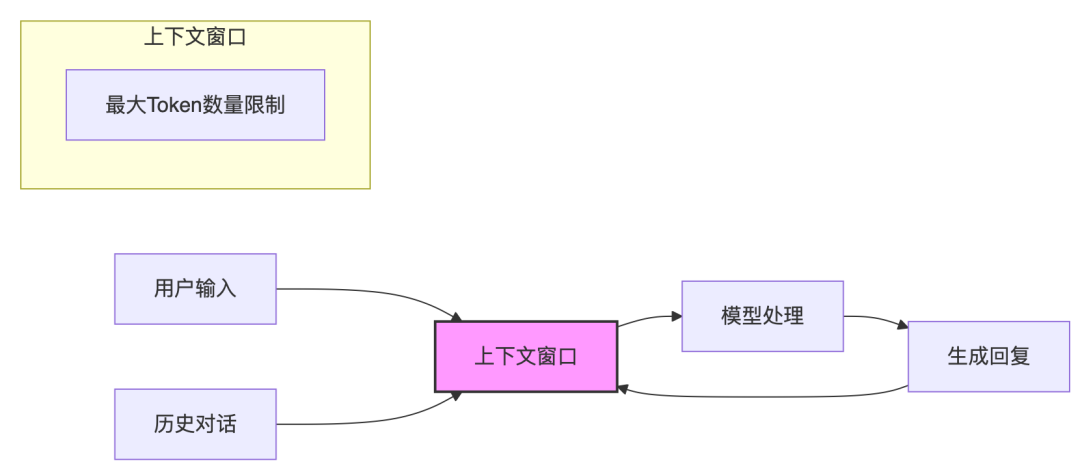

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 5

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 3

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 4

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 4

- 0

-

字节跳动的野心:从豆包、飞书到生态,一个万亿巨头的AI进化论

今年3月,微软CTO Kevin Scott接受采访时表达:"AI模型本身不是产品,价值只有通过产品与用户需求联系起来时才能体现。" 他提到一个常见现象:"有些团队建好了平台、训练好了模型、拉好了算力,然后发现没人用,才开始慌了。" 这就像4G、5G技术很重要,但真正将人与人直接的联系拉近与点燃的是2018年夏天的抖音,模型是基础设施,产品才是引爆点 在这…- 3

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 5

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 5

- 0

-

MemOS:一个为AI系统设计的记忆操作系统

今天,我们要深入探讨一个可能会重塑我们与AI交互方式的重磅研究。你是否曾感觉,尽管今天的大语言模型(LLM)能力超凡,但在记忆力方面却像个“金鱼”?它们在长对话中会忘记之前的约定,无法真正记住你的偏好,更别提持续更新知识库了。这种“失忆症”极大地限制了LLM成为真正智能助手的潜力。为了解决这个问题,来自MemTensor、上海交大等机构的研究者们提出了一项极具开创性的工作——MEMOS(Memor…- 3

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 3

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 4

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 4

- 0

-

AI 上新|我让 AI「偷窥」了我的屏幕,它有机会变成我第二个大脑

AI 助手,向着「低调实用」方向发展。作者|张勇毅编辑|靖宇几周前,我为了一份行业深度文章的撰写,在堆积如山的数据分析文件和浏览器标签页中挣扎了整整两天。 那种感觉,就像在自己的知识库里溺水——你明确地记得看过某个数据、某段论述,却无论如何也无法在信息的洪流中重新定位它。 我们早已习惯了这种数字时代的「失忆症」,也习惯了将希望寄托于 AI。我们像一个耐心的饲养员,不断地在应用之间复制、粘贴、切换,…- 8

- 0

-

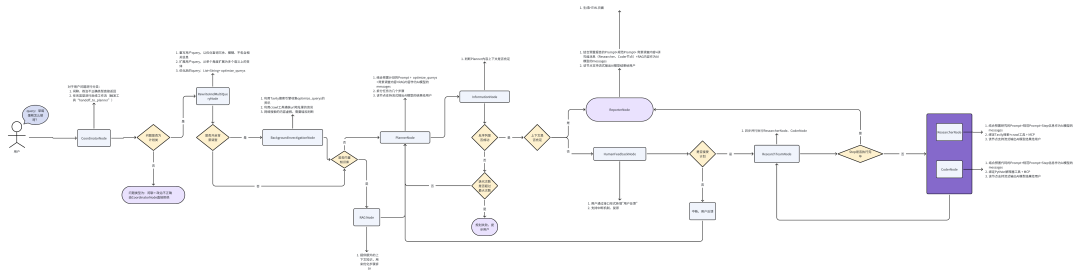

如何在 Elasticsearch 中构建你的智能 AI 助手?

在微服务、容器化和云原生架构的推动下,现代系统产生的日志量正以指数级增长。面对 TB 级的日志数据,传统的“人工排查 + 固定规则告警”方式已经显得力不从心。日志查不准、异常发现慢、响应效率低等问题,正在不断侵蚀系统的稳定性与运维效率。 本文将带你探索一种全新的思路:如何基于 Elasticsearch 快速构建一个具备自然语言理解能力、异常检测和安全威胁识别能力的智能运维 AI 助手 。我们将围…- 6

- 0

-

提示词能力:短期是刚需,长期是辅助

前几天看到一篇讨论市场上各种AI产品的文章,作者从交互方式聊到了提示词工程,最后重点提到了AI产品设计的核心在于系统性构架思维,个人比较认同其中的部分观点,故摘取整理了其中一些观点,分享给大家。 原文名称:《Are we designing AI products all wrong?》 地址:https://uxdesign.cc/where-should-ai-sit-in-your-ui-1…- 7

- 0

-

垂直和领域 Agent 的下一课:上下文工程

💡 目录 💡 01 从一个场景开始,感受上下文工程的魔力 02 提示词->提示词工程->上下文工程的演进 03 上下文工程不等同于上下文 04 构建上下文工程…- 9

- 0

-

Agent 框架协议“三部曲”:MCP、A2A、AG-UI

近期关注AI行业动态的人士应该能观察到一个趋势,基础模型训练领域正日益呈现出寡头垄断的特征,而AI应用创新的前景和空间依然开阔,令人兴奋的AI应用层出不穷。一个完整的AI应用系统中常常包括三个主要角色:用户、AI Agent、外部工具,AI交互系统的核心之一是解决这三个角色之间的通信问题。 本文针对Agent框架的三个主流协议进行介绍,包括MCP协议——解决AI Agent和外部工具交互问题;A2…- 10

- 0

-

8分钟了解Deep Research与上下文工程

一句话总结全文:介绍了Deep Research的概念,Spring Ai Alibaba的Deep Research实现以及为什么需要Mem0这种记忆管理框架增强其性能。本文主要以Spring Ai Alibaba的Deep Research项目展开。开源地址:MCP0llxxx2io">https://github.com/alibaba/spring-ai-alibaba/t…- 6

- 0

-

Jina Embeddings v4 的量化感知训练

在 AI 领域,我们对模型的期待总是既要、又要、还要:模型要强,速度要快,成本还要低。但实际应用时,高质量的向量表征往往意味着庞大的数据体积,既拖慢检索速度,也推高存储和内存消耗。量化(Quantization)正是破解这一矛盾、实现规模化应用的关键技术。量化是一种常用的神经网络模型压缩技术,本质并不复杂:通过把高精度的小数四舍五入成更粗的整数,主动牺牲一部分精度,换来模型体积的大幅缩减。量化不仅…- 5

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 8

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 4

- 0

-

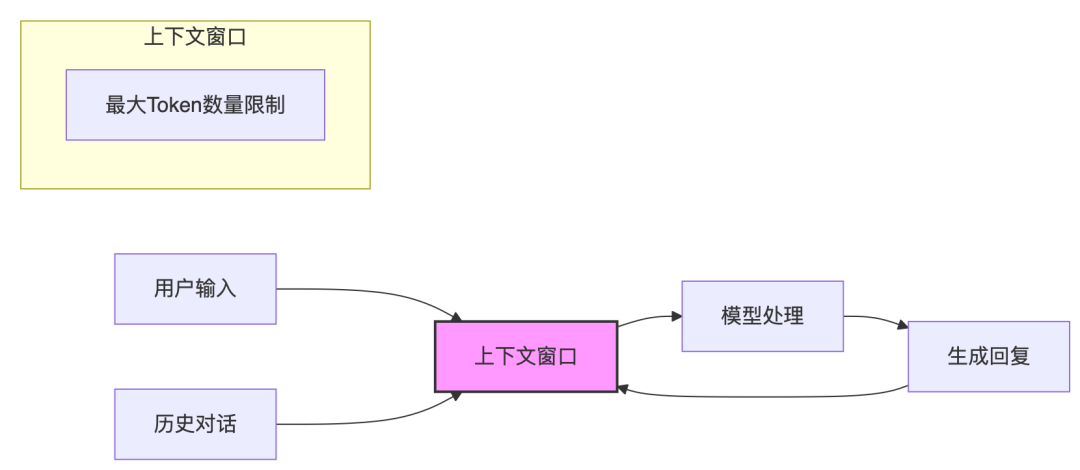

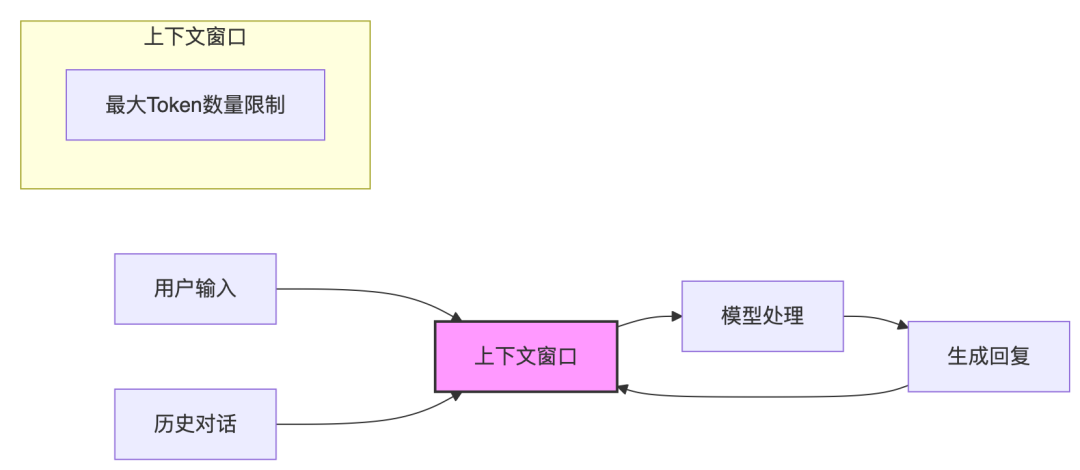

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 7

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 9

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 8

- 0

❯

购物车

优惠劵

搜索

扫码打开当前页

联系我们

返回顶部

幸运之星正在降临...

点击领取今天的签到奖励!

恭喜!您今天获得了{{mission.data.mission.credit}}积分

我的优惠劵

-

¥优惠劵使用时效:无法使用使用时效:

之前

使用时效:永久有效优惠劵ID:×

没有优惠劵可用!