-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 9

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

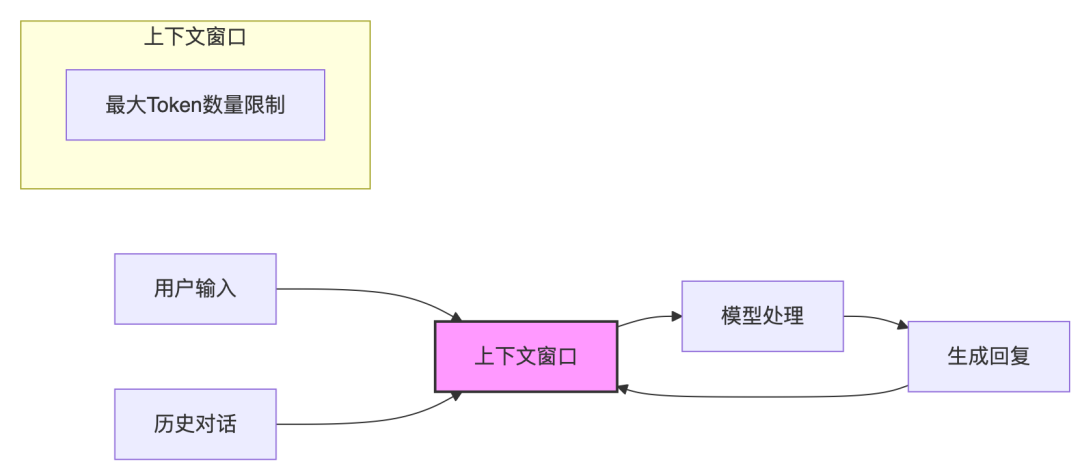

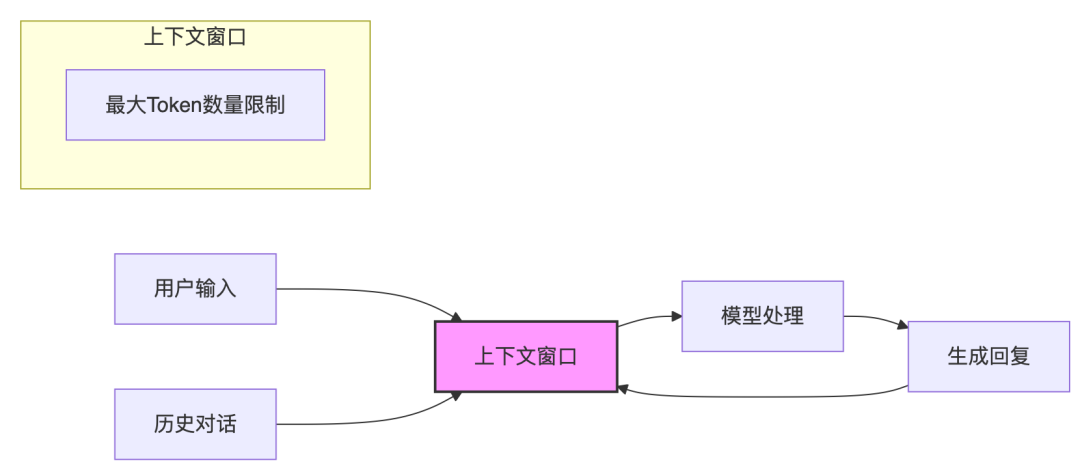

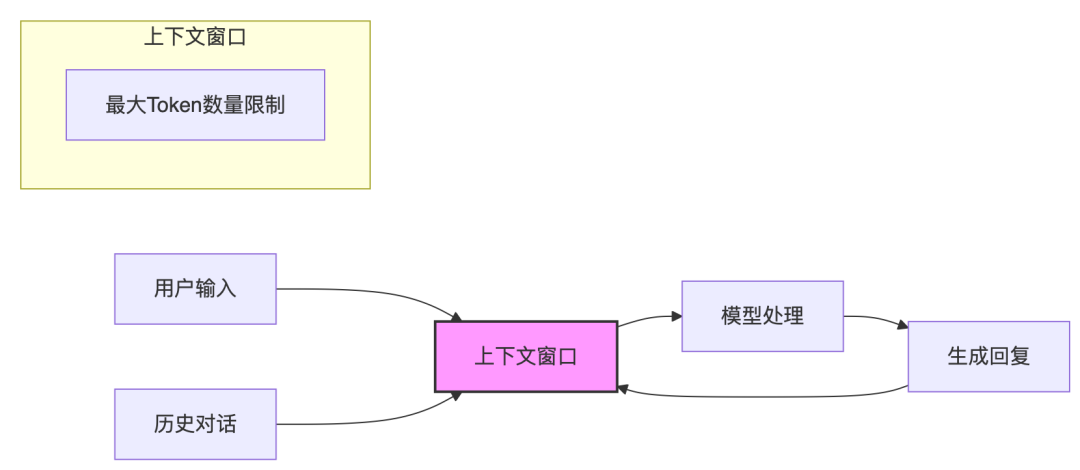

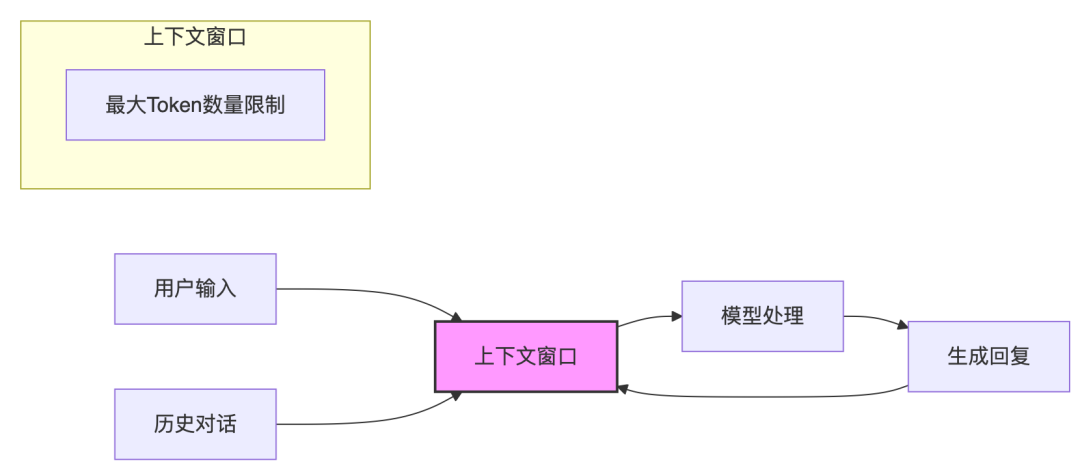

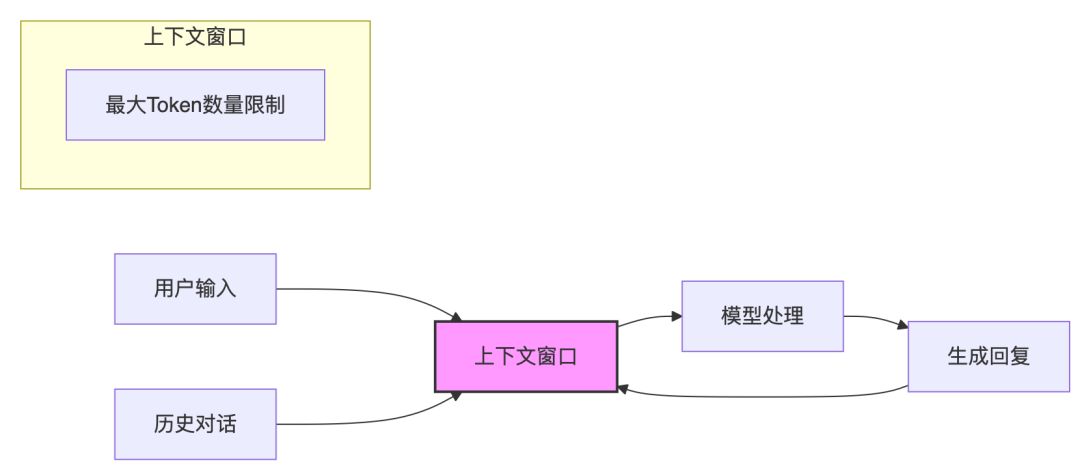

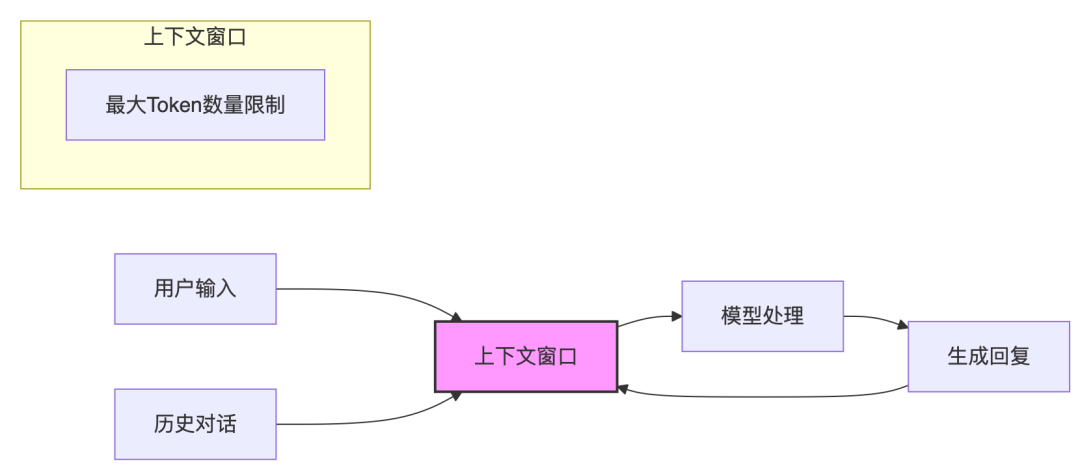

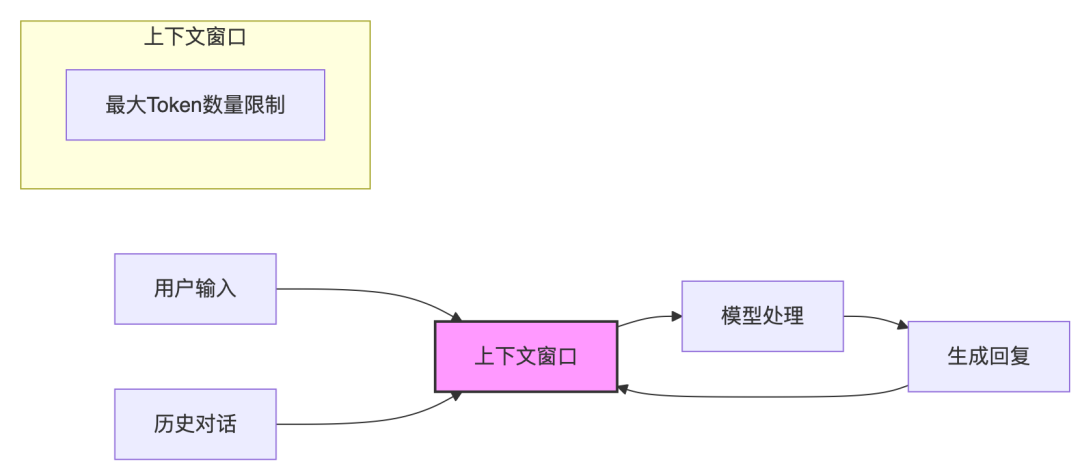

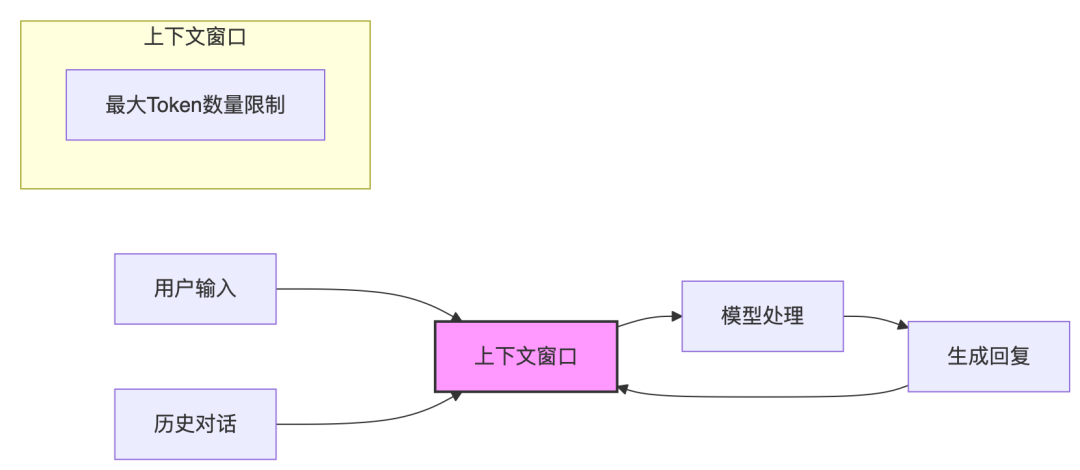

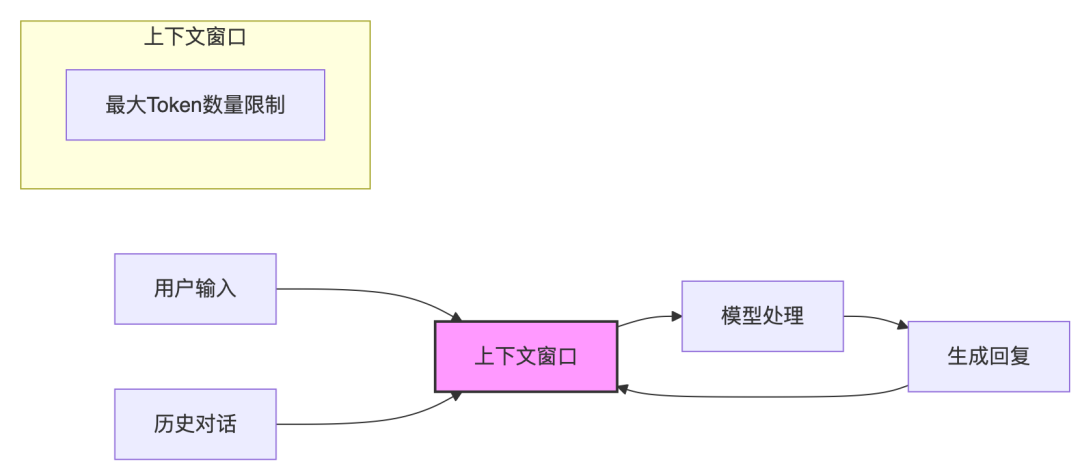

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 6

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 7

- 0

-

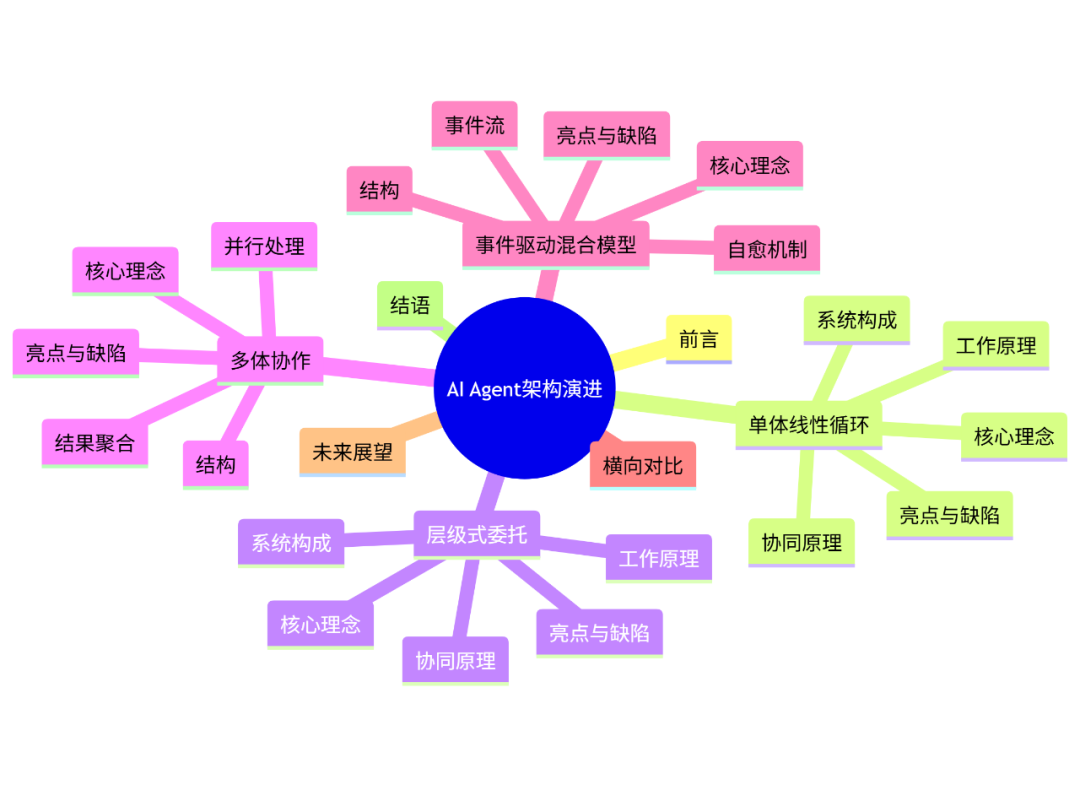

【速读版】Agent不同设计范式 vs 模型上下文长度

0. 背景:内存枷锁与Agent架构的演化 LLM(大语言模型)与Agent的 核心矛盾在于: “任务所需信息量” > “模型可持有上下文窗口” 当LLM的上下文窗口有限(如1M tokens),Agent系统必须通过外部“上下文管理策略”来弥补记忆短板。四大范式正是为此而生。 一、 单体线性循环:极简可靠的工匠范式 系统轮廓 +-------------------------------…- 8

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 6

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 5

- 0

-

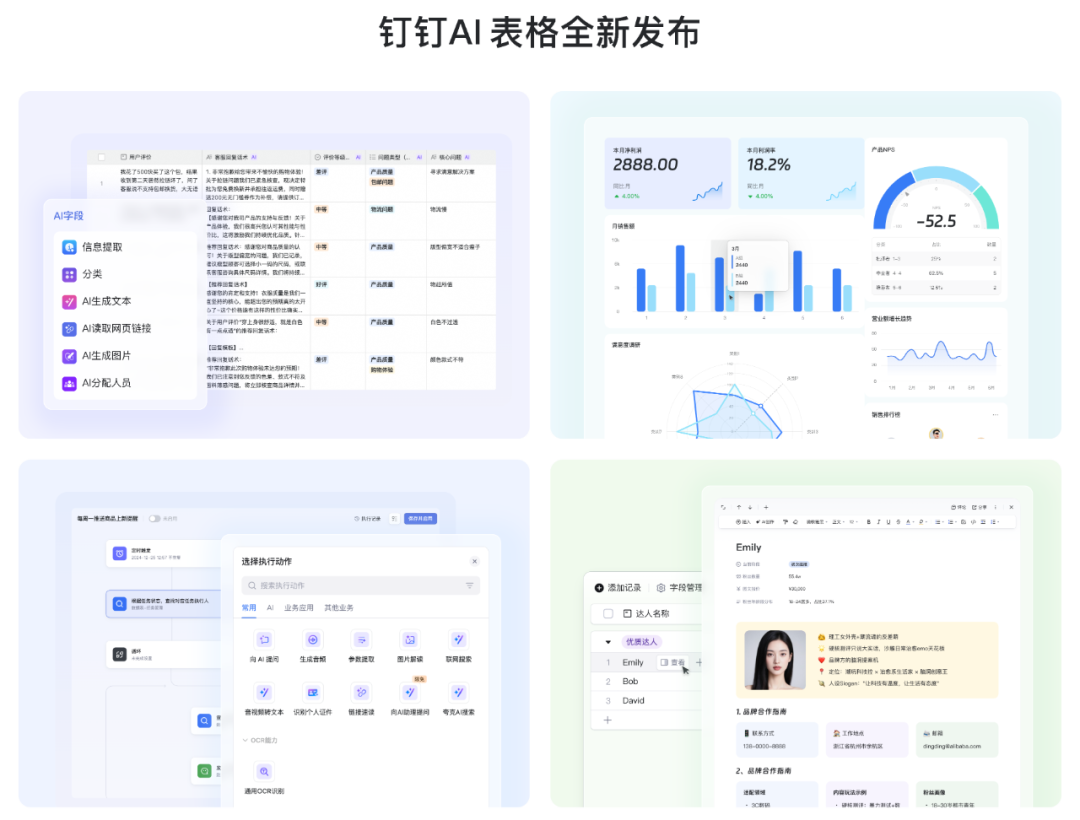

钉钉全新发布“AI表格”

钉钉全新发布「AI 表格」面向 AI 时代打造新应用的入口。在钉钉 AI 表格里,AI 已成为原生能力,每一个单元格都是 AI 的入口,也是一个智能工作流。所有企业、用户都可以基于钉钉 AI 表格构建自己的业务系统,批量处理任务,让业务数据真正流动并产生价值。同时,钉钉 AI 表格创新推出“表格即文档”功能,首次将文档融入数据表。这意味着,表格每一行记录都是一个独立的文档,用户可以像平时写文档一样…- 6

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 5

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 3

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 6

- 0

-

AI科普:带你看懂AI大模型的“参数规模”与“激活参数”

老铁们,我是雨哥! 人到中年,不进则退!跟随雨哥从小白开始接触AI,分享学习历程。 ------------ 我们在看一些新的大模型发布的时候,经常会听到什么“175亿参数”、“1万亿参数”,提起来很厉害的数字。那这些听上去很庞大的数字但到底代表什么? 是不是参数越多,模型就越强?还有一种新词叫激活参数,又是什么意思?今天,我们就来一起拆解这个AI术语背后的秘密。 01. 什么是“参数规模”? 通…- 26

- 0

-

上下文为王:AI Agent架构的四大范式深度赏析与工程选型指南

上下文为王:AI Agent架构的四大范式深度赏析与工程选型指南 文章导览 前言:AI Agent的“石器时代”与上下文枷锁 欢迎来到AI Agent探索的黎明时分!我们正沉浸在激动人心的技术浪潮中,热烈讨论着各式精巧的Agent架构:从经典的思考-行动(ReAct)框架,到复杂多变的多智能体协作系统,再到灵动响应的事件驱动模型。我们精心绘制流程图,细致打磨协作协议,仿佛正在构建通往通用人工智…- 10

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 4

- 0

-

当操作系统遇见智能体,OS Agent和AgentOS驱动的人机交互变革及启示

AI Agent能够自主使用工具,操作系统为应用(工具)运行提供环境,操作系统智能体(OS Agent)和智能体操作系统(AgentOS)应运而生。前者侧重基于现有操作系统发挥Agent的能力,是“外接型”轻量适配;后者侧重重构操作系统使其原生支持Agent,是“内置型”深度集成。无论外接还是内置,OS与Agent的碰撞都将把人机交互推向新纪元。OS Agent:让Agent“能用”操作系统和应用…- 9

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 4

- 0

-

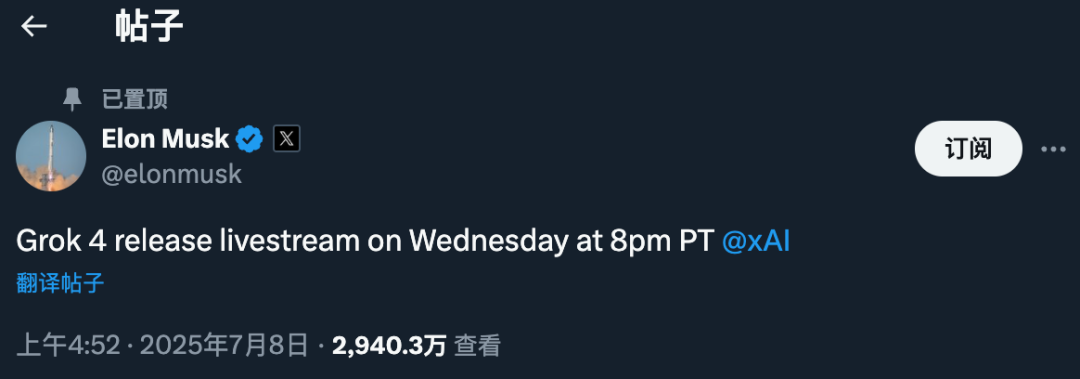

Grok 4要来了!!北京时间周四上午 11 点,马斯克宣布“重写人类知识库”!

马斯克的Grok4千呼万唤,总算是要来了! 老马也算是时间管理大师了,搞完火箭搞政治,搞完了政治,中途还成立了一个美国党,Grok4从上个月一直跳票到现在,现在终于有了板上钉钉的时间。 马斯克在自己的官方网站宣布 xAI 的 Grok 4 发布会将于太平洋时间周三晚 8 点进行线上直播。也就是北京时间周四上午 11 点。 上次Grok3直播的时候我们是采用的视频直播,中途被掐了,这次学乖了,直接在…- 6

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 5

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 3

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 6

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 6

- 0

-

超150次提及“AI”!读懂Figma IPO背后的三大关键问题

导语:资本市场从不缺故事,但很少有哪个像Figma这样充满戏剧性。当价值200亿美元的“世纪婚约”被监管机构无情撕毁,所有人都以为这会是一个挫折的开始。然而,Figma却用一份惊艳的S-1招股书,宣告了一个更强者的归来。在这场奔向纳斯达克的狂欢背后,真正的机会与风险,藏在何处?这正是我们需要穿透喧嚣,去探寻的答案。7月初,Figma向纳斯达克递交了S-1文件,正式叩响了资本市场的大门。这无疑是年度…- 6

- 0

-

基于业务知识和代码库增强的大模型生成代码实践

1.源起李明是今年刚加入某互联网公司的研发新人,满怀期待地开始了他的职业生涯。然而,短短两周后,他的热情就被现实浇了一盆冷水。第一周:当他第一次接手需求时,mentor只是简单交代了几句:“这个功能之前做过类似的,你参考下历史代码。”可当他打开代码仓库,却发现注释寥寥,变量名像密码一样难懂,更找不到任何需求文档。他硬着头皮修改,结果上线后引发了线上故障——原来有个隐藏的业务规则,只有老员工才知道。…- 6

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 5

- 0

-

万字盘点2025上半年,值得推荐的AI模型与产品清单

今年已经过去了一半,突然心血来潮,来更新一期「2025 年上半年,我最推荐的 AI 清单」了。综合我半年使用的个人看法,不覆盖所有的产品,凭自己印象,直接码出这篇文章。实在没记起来的好产品,也就不算“我的上半年推荐”了,还请包容。评选标准如下:类型划分:分为模型与产品。部分品类由于国内和国外还是存在代差,但在国内有做得很好,会按国内、国外分开推荐。上榜的原因大致有四:「最常用」、「惊喜时刻」、「有…- 6

- 0

❯

购物车

优惠劵

搜索

扫码打开当前页

联系我们

返回顶部

幸运之星正在降临...

点击领取今天的签到奖励!

恭喜!您今天获得了{{mission.data.mission.credit}}积分

我的优惠劵

-

¥优惠劵使用时效:无法使用使用时效:

之前

使用时效:永久有效优惠劵ID:×

没有优惠劵可用!