-

纳米AI一句话成片功能实测:从文字到视频只需等待

大家好,我是歸藏(guizang),今天带来纳米 AI 超级搜索一句话成片功能的测试。 之前我测试纳米 AI 的 MCP 能力的时候看到有视频生成的 MCP 就提到过,要是可以直接自动生成完整的视频就好了。 最近他们终于开始好好搞这个流程,做了一个一句话成片的功能。 现在真的可以一句话生成完整视频了,而且成功率高的离谱,用来生成新闻介绍、科普视频、小说情节等都非常好用,发了提示词等一段时间回来收菜…- 7

- 0

-

超级黑马Read AI如何在美国把会议转录做成一门大生意

同样是办公软件,中国与美国市场的差异,可谓天差地别: 在中国,只要一个飞书、钉钉,或者企业微信,就能解决企业从消息沟通、会议、写文档、做表格、做PPT、做会议纪要等多重需求。 而在美国,往往不同功能对应不同软件。想要检索一个历史文档中的信息,或者会议中的细节,有时候,甚至需要来回在四五个软件之间跳转,繁琐且低效。 那么,怎么高效地找到散落不同软件中的精准信息,降低信息整合的成本?针对这个需求,20…- 6

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

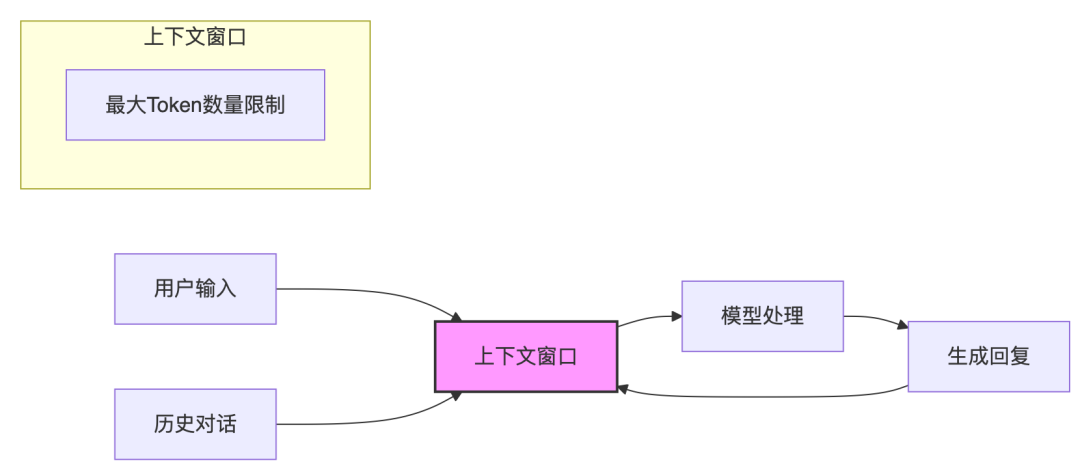

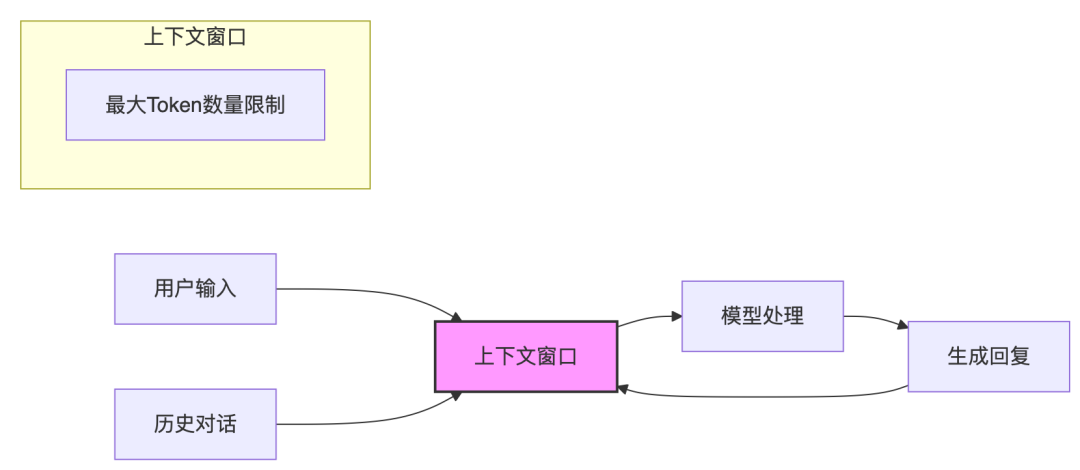

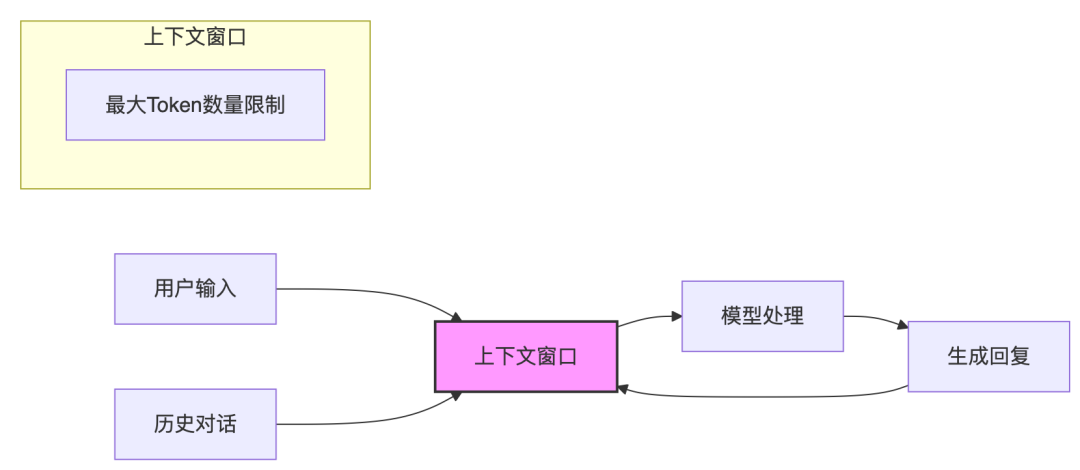

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 7

- 0

-

MemAgent:当LLM学会记笔记,350万字超长文本处理难题迎刃而解

今天,我们要聊一个让所有大模型开发者都头疼的问题——长上下文(Long-Context)处理。想象一下,让AI阅读一本几十万字的小说并回答一个横跨多个章节的细节问题,或者让它分析一个包含数百万行代码的整个项目。这些任务对于当前的大模型来说,几乎是不可能完成的任务。 问题的根源在于Transformer架构的天生缺陷——O(n^2)的计算复杂度。这意味着上下文长度(n)每增加一倍,计算量和内存消耗就…- 15

- 0

-

大模型落地及Agent记忆的有趣观点:兼看SVG生成用多模态大模型怎么做?

今天是2025年4月11日,星期五,北京,天气晴,预报晚上有大风。 本文来看两个问题。 第一个问题,关于大模型落地以及Agent记忆的有趣观点,是一些大道理的总结,懂得读懂,懂了还那样,不会有什么变化,清风徐来,水波不兴。 第二个问题,顺着昨天图文描述生成caption的工作,我们看SVG生成用多模态大模型怎么做?三个代表工作,看看底层技术细节,实现思路。 抓住根本问题,做根因,专题化,体系化,会…- 5

- 0

-

刚刚,Karpathy 又造新词 :”细菌式编程”诞生记,兼论上下文工程演进史

Andej Karpathy之前提出“#氛围编程”(vibe coding)大火特火,今天AK又造了一个新词“#细菌式编程” 在软件开发的世界里,我们时常陷入关于最佳实践的无尽讨论中:是应该构建一个大而全的单体应用(Monolith),还是拥抱灵活的微服务(Microservices)?是该追求零依赖,还是善用成熟的第三方库? 01细菌式编程一、细菌编码的三大法则 Karpathy 指出,如果我们…- 5

- 0

-

基于AI(LLM)和Playwright MCP(模型上下文协议)的测试自动化

编译整理|TesterHome社区 作者|Kailash Pathak以下为作者观点:在快节奏的软件开发领域,大规模交付高质量应用始终是一项挑战。传统测试自动化虽然功能强大,但常面临动态用户界面、不稳定测试和耗时的脚本维护等难题。生成式AI(GenAI)与Playwright MCP(模型上下文协议)——这对改变游戏规则的组合,正在重新定义现代测试自动化。 MCP(模型上下文协议) 本文将探讨这些…- 11

- 0

-

AI Agent 凭什么火?看懂 60 年软件演进史,你就明白了

大家好,我是孟健。 前几天,一位做了很多年开发的朋友跟我说: "现在的 AI Agent 让我想起当年第一次用 Spring 框架的感觉——既兴奋又迷茫。" 我深有同感。 每一次技术范式的转变,都会让我们重新审视"什么是软件"这个根本问题。 最近在研究 12-Factor Agent,看到了一篇特别有意思的软件简史。 作者用一个简单却深刻的视角,带我们回顾了…- 6

- 0

-

用子模优化法为DeepResearch生成多样性查询

在开发DeepResearch时,生成多样化的查询 (query) 是一个关键细节。我们在开发时会在至少两处遇到这个问题。第一处是在解析用户的原始输入,并生成网页搜索查询,因为直接把原始输入抛给搜索引擎,效果往往不尽人意。第二处,是许多 DeepResearch 系统会前置一个“研究方案规划器”,负责将原始问题分解为多个正交的子问题,然后调用 Agent 来分而治之的解决这些子问题,最后再整合它们…- 6

- 0

-

几个故事,理解AI Agent规划的不同实现方式

在o1将多步推理能力内化到模型之前,Agent规划的实现,依赖开发者在外部搭建的工作流。根据工作流的构建方式,可以分为“硬”和“软”两种。 [1] 硬工作流: 系统流程 类似扣子、dify等低代码平台,由开发者根据预设任务逻辑,搭建一个包含分支、判断条件的固定流程图。模型是被动的执行器,完全遵从预设好的硬编码流程,在指定节点执行某个具体任务。 [2] 软工作流:模型提示词 开发者通过设计提示词或最…- 6

- 0

-

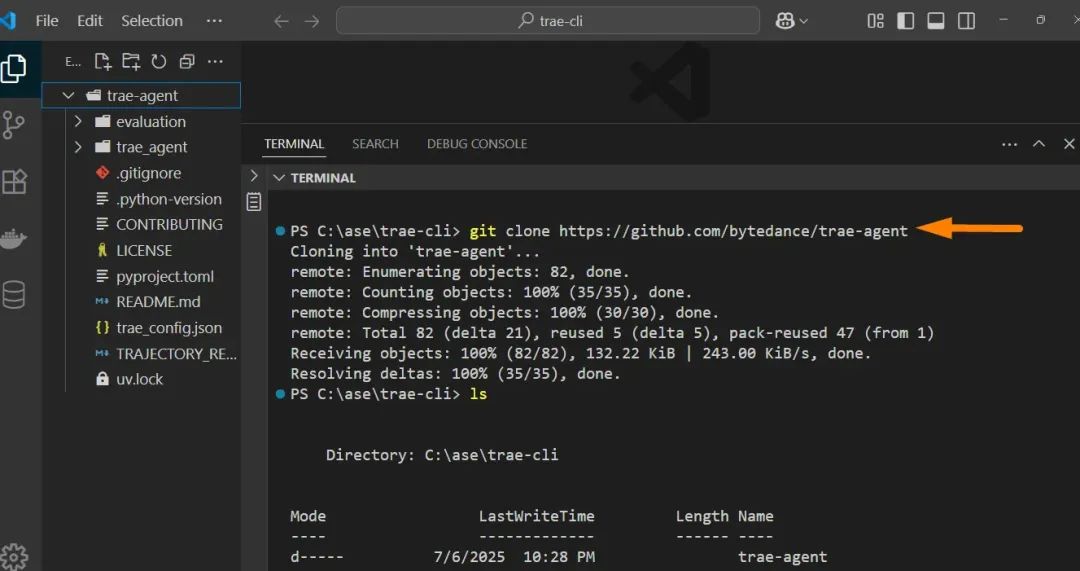

字节推出 Claude Code 和 Gemini CLI 替代品(我测试了)

字节跳动刚刚推出了一个终端 AI 编程工具,类似于 Claude Code 或 Gemini CLI。我刚测试过,可能会让你失望。字节跳动 一直在慢慢追赶 Cursor、Claude 和其他 AI 编程助手,试图在编程助手市场中建立自己的立足点。Trae AI,并没有达到我的期望,尽管后来的更新令人印象深刻,显示出显著的改进。让我带你了解设置过程,这不像 Gemini CLI …- 7

- 0

-

为什么我觉得AGI并不会马上到来

持续学习是一大瓶颈“事情往往比你预期的慢,但一旦发生,又快得超出你的想象。”— 鲁迪格·多恩布什(Rudiger Dornbusch)在我的播客[1]中,我经常跟嘉宾聊到实现AGI(通用人工智能)的时间表。有些嘉宾认为还需要20年[2],而有些人则认为2年就够[3]。截至2025年6月,我自己的观点如下。持续学习能力问题有时候人们会说,即使现在AI技术不再进步,当下的AI智能体也会比互…- 5

- 0

-

当微信支付开放MCP之后,我却有一点后怕。

前两天,微信开放了自己的微信支付MCP。补上了智能体链路的最后一块拼图。虽然现在还只能在腾讯自己家的腾讯元器上用,但,影响也还是足够的大。很多人可能不知道微信支付MCP到底意味着什么,但我正好是为数不多提前拿到正式版的体验者,还用它搓了几个小Demo。这两天,那种一边用一边产生那种兴奋与后怕交织的复杂感受,是真实得不能再真实了。所以,我也想,分享一下我自己真实客观的体验,和想法。先给完全不懂的用户…- 5

- 0

-

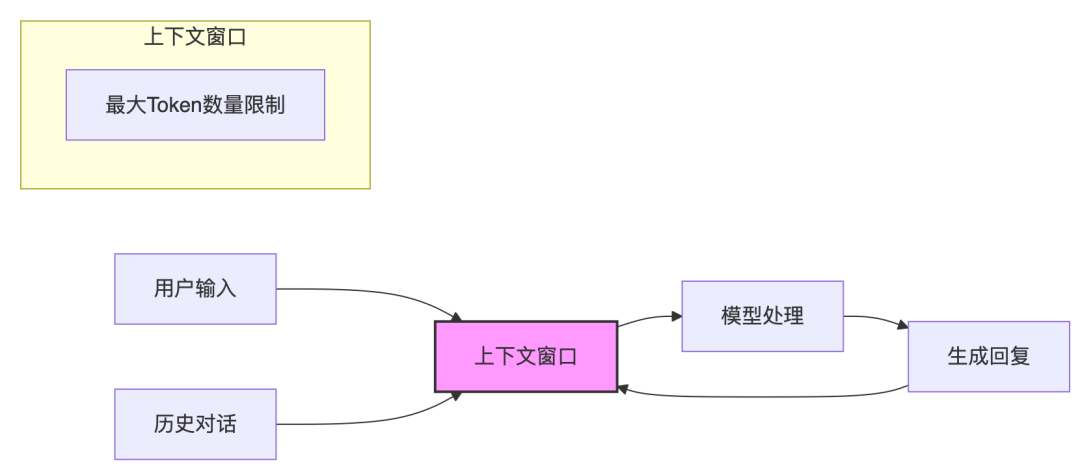

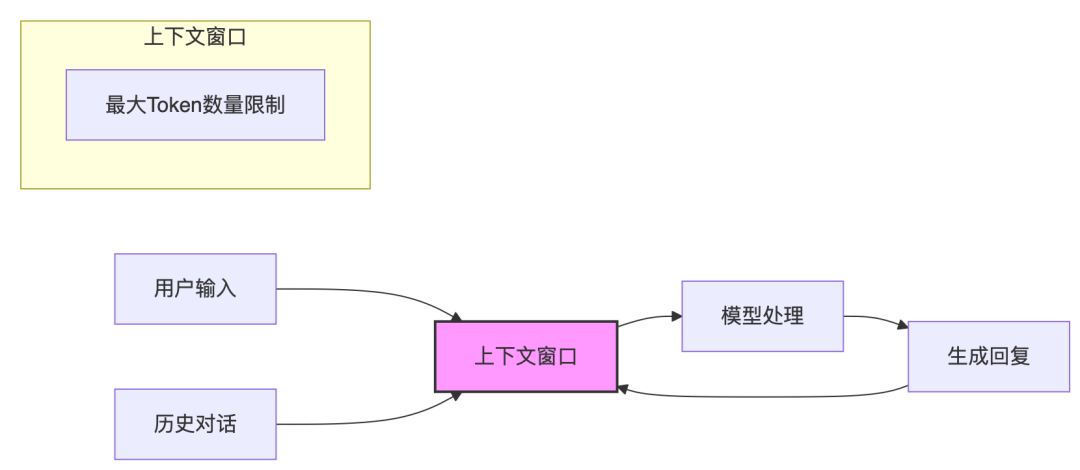

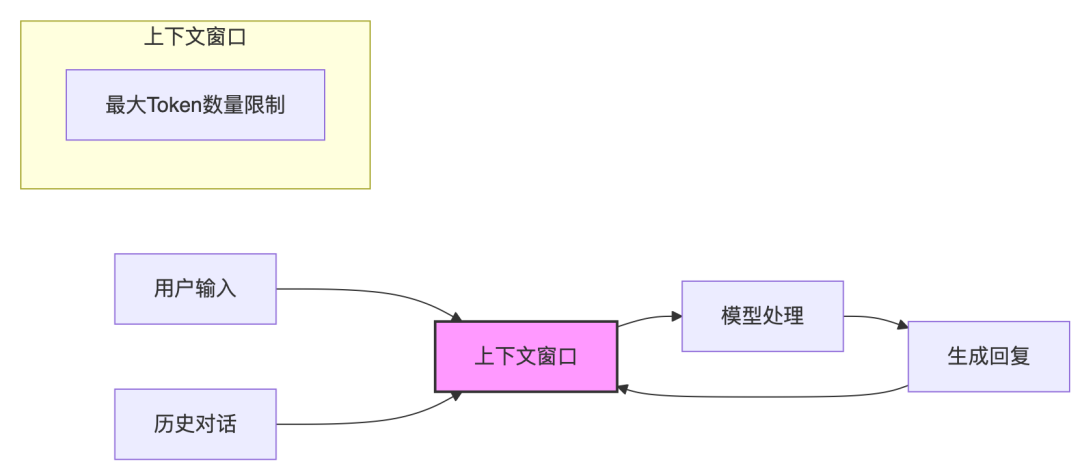

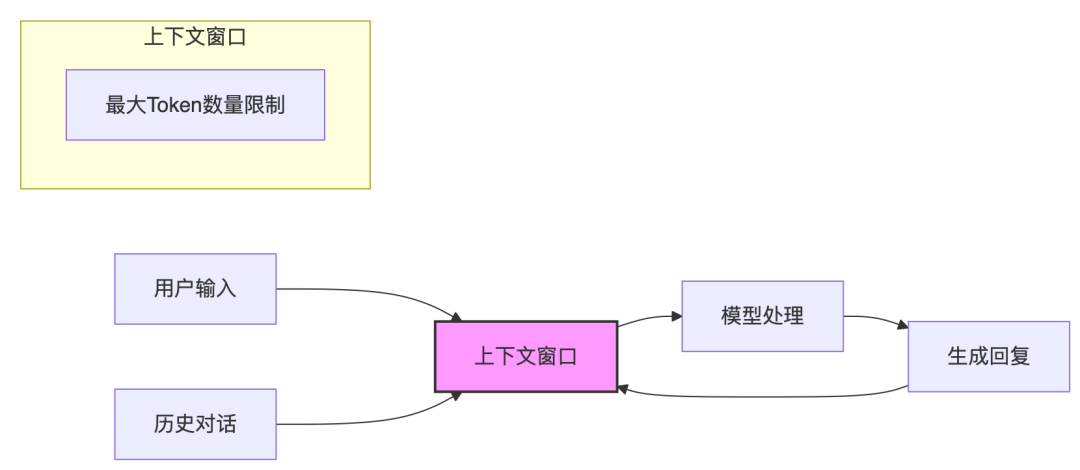

🧠 解码大语言模型的记忆力:上下文长度的前世今生

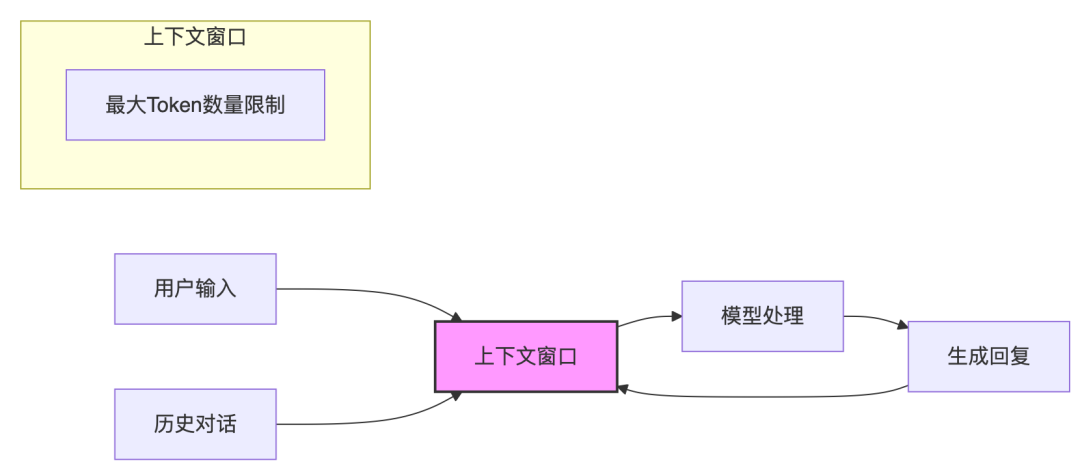

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 8

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 7

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 7

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 7

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 7

- 0

-

再见AI Agents,你好Agentic AI

AI Agents被定义为由大型语言模型(LLMs)和大型图像模型(LIMs)驱动的模块化系统,用于特定任务的自动化。Agentic AI的出现是为了解决AI Agents在处理复杂、多步骤或需要协作的场景中的局限性,它代表了一种范式转变,强调多智能体协作、动态任务分解、持久记忆和协调自主性。从基础AI Agents到Agentic AI系统、应用、局限性和解决方案策略的方法论流程图一、AI Ag…- 6

- 0

-

「上下文工程」硅谷爆火,Karpathy亲自站台!提示工程瞬间失宠

新智元报道 编辑:桃子【新智元导读】继提示工程之后,「上下文工程」又红了!这一概念深得Karpathy等硅谷大佬的喜欢,堪称「全新的氛围编程」。而智能体成败的关键,不在于精湛的代码,而是上下文工程。硅谷如今炙手可热的,不再是提示词工程,而是上下文工程(Context Engineering)! 就连AI大神Karpathy,都为「上下文工程」投下了一票。 还有Shopify CEO Tob…- 7

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 7

- 0

-

10分钟搞定Excel世锦赛难题!首个超越人类Excel Agent,网友:想给它磕一个

机器之心报道编辑:杨文这个AI让打工人「磕头」致谢。 前段时间,我们报道了 5 款大模型参加了今年山东高考的事儿,为了弄清楚各大模型在 9 个科目中的具体表现,我们对着测评明细表挨个儿分析,搞得狼狈又崩溃。要是哪个 AI 能一键分析表格,我当场就能给它磕一个。 现在,终于有 AI 来整顿 Excel 表格了! 这款 AI 工具名为 Shortcut,号称是「第一个超越人类的 Excel Agent…- 5

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 8

- 0

-

行业大模型的“燃料革命”:高质量数据集助推产业智能升级

在数字化转型浪潮中,行业大模型被视为推动产业升级的核心引擎。但是,当前大多数行业大模型面临着训练数据的质量缺陷导致模型“逻辑混乱的伪推理”巨大挑战。2025年4月30日全国数据标准化技术委员会秘书处发布了《高质量数据集建设指南(征求意见稿)》,对高质量数据集建设的全生命周期要求,包括数据需求、数据规划、数据采集、数据预处理、数据标注、模型验证等阶段提出了建设指南,同时对高质量数据集分类、质量评测规…- 8

- 0

❯

购物车

优惠劵

搜索

扫码打开当前页

联系我们

返回顶部

幸运之星正在降临...

点击领取今天的签到奖励!

恭喜!您今天获得了{{mission.data.mission.credit}}积分

我的优惠劵

-

¥优惠劵使用时效:无法使用使用时效:

之前

使用时效:永久有效优惠劵ID:×

没有优惠劵可用!