-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

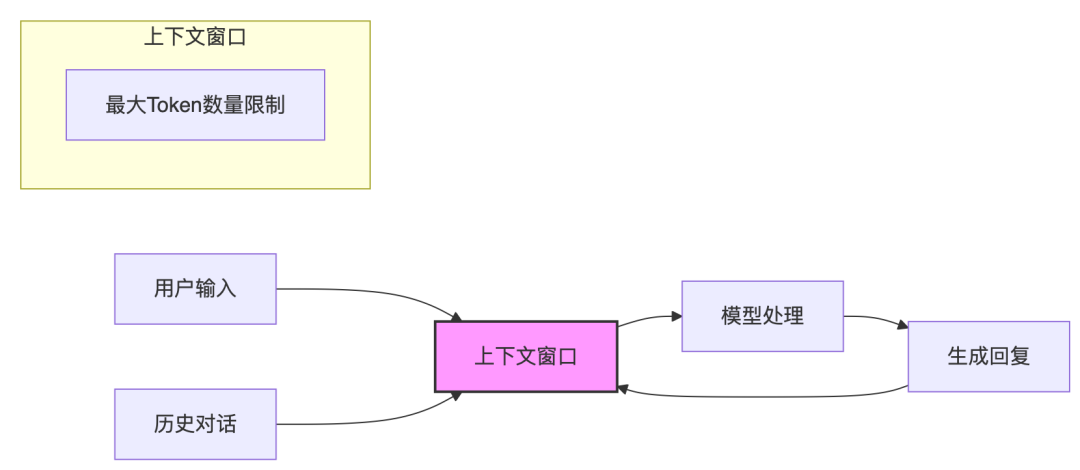

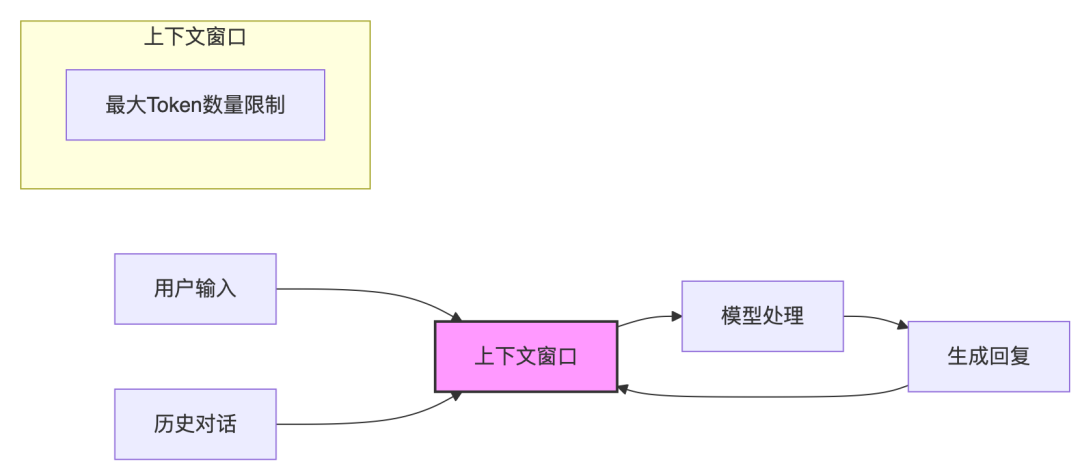

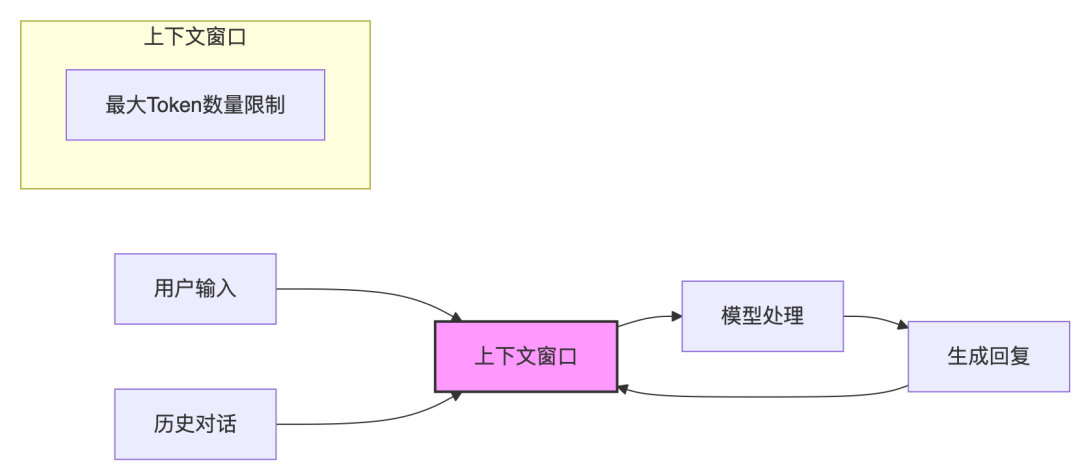

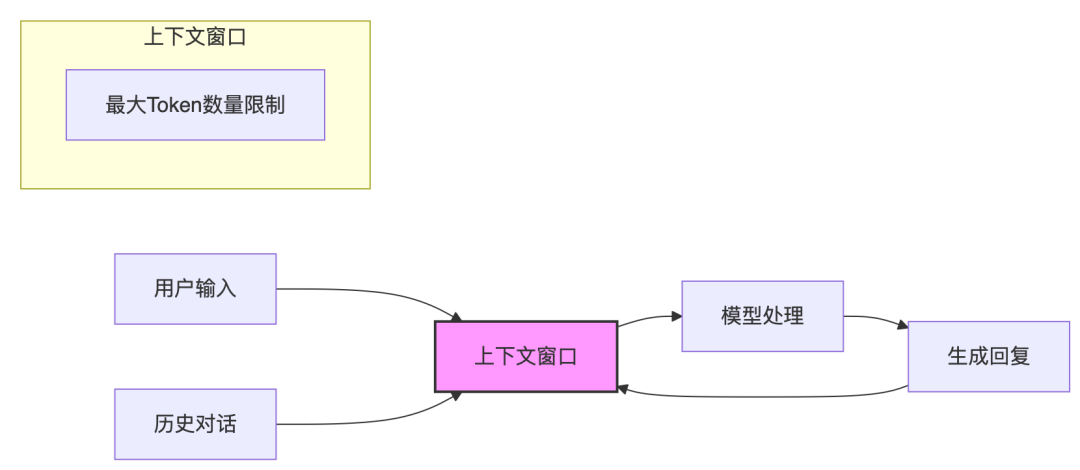

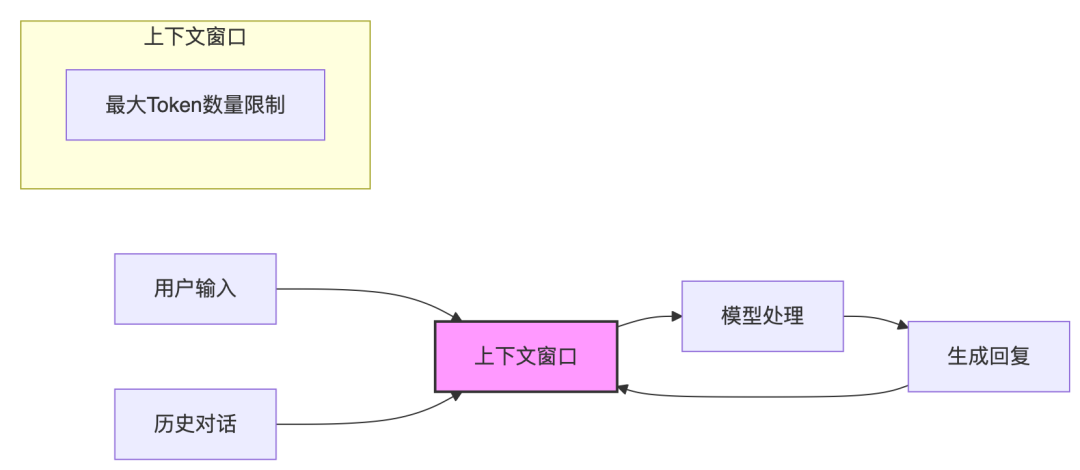

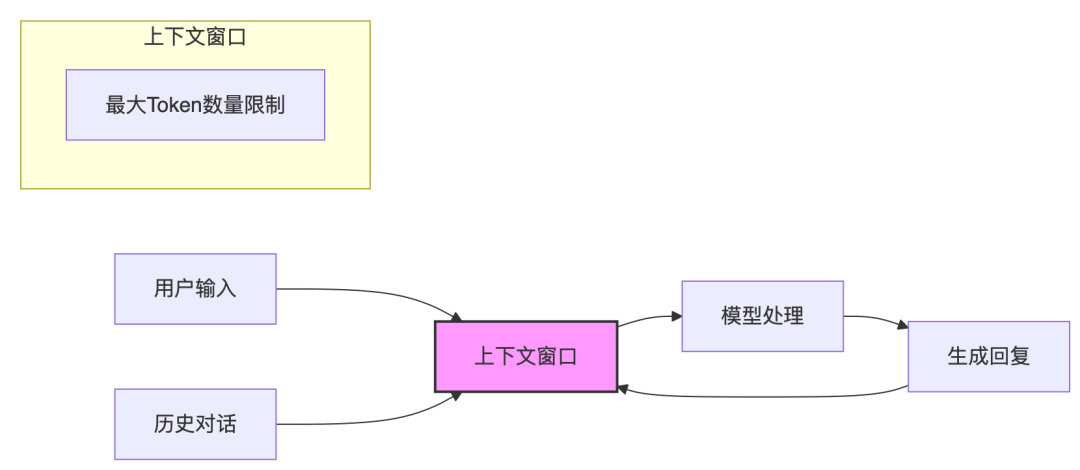

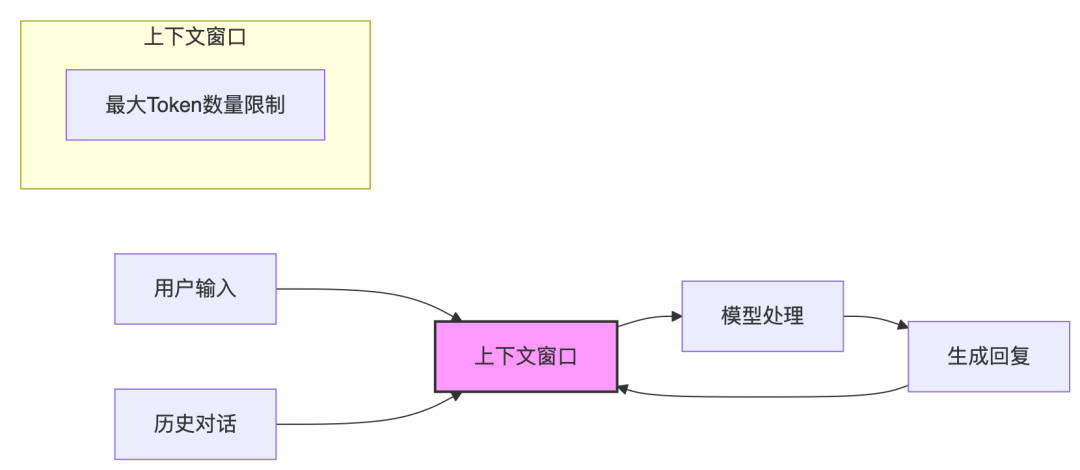

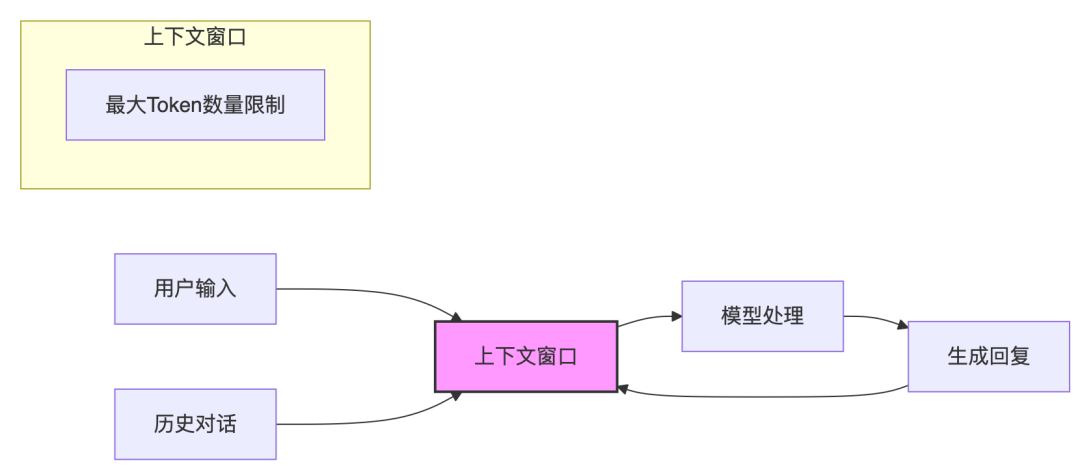

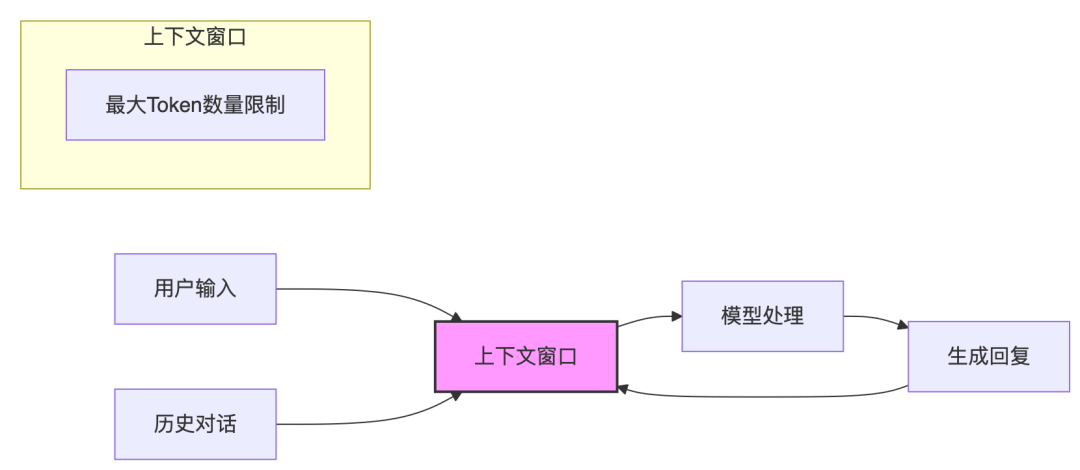

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 3

- 0

-

Multi-Agent记忆系统MIRIX:比RAG性能飙升35%,存储减少99.9%

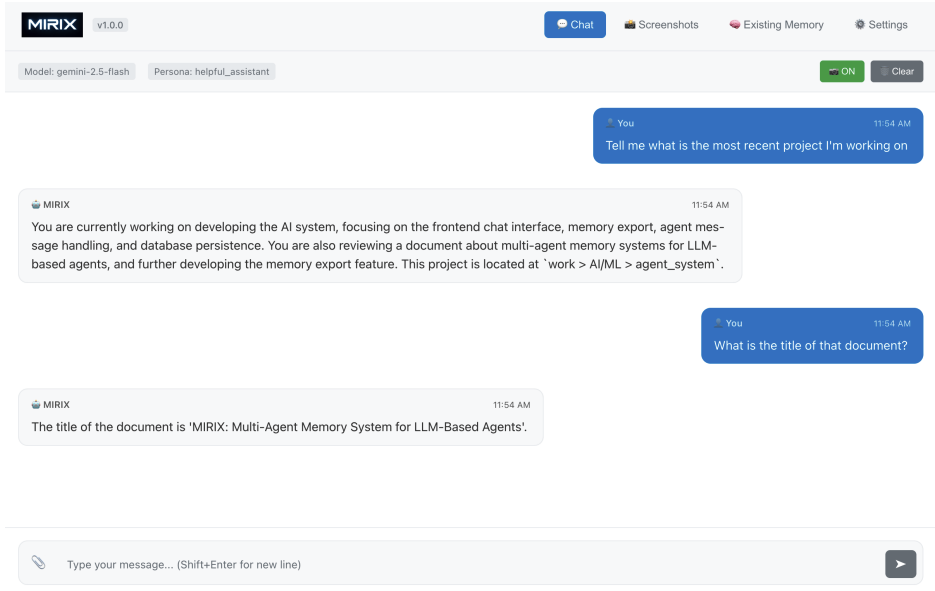

尽管AI Agent的记忆能力正受到越来越多的关注,但现有的解决方案本质上仍存在局限性。大多数方案依赖于平面化、狭窄的记忆组件,限制了它们个性化、抽象化以及可靠回忆用户特定信息的能力。MiRIX对话窗口为此,提出了MIRIX,这是一个模块化的多智能体记忆系统(Multi-Agent Memory System),通过解决该领域最关键的问题——让语言模型真正具备记忆能力——重新定义了AI记忆的未来。…- 2

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 3

- 0

-

蓝色光标:未来一年,AI视频生成能力是突破重点

7月26日-28日,2025世界人工智能大会(WAIC)暨人工智能全球治理高级别会议在上海世博中心和世博展览馆举办。作为中国科技创新面向世界的重要平台,WAIC 2025以“智能时代 同球共济”为主题,覆盖人工智能安全治理、大模型创新应用、算力新基建、Al for Science、开源开放、新型工业化等前沿议题,全面展现AI技术前沿、产业趋势与全球治理的最新实践。期间,蓝色光标CEO潘飞出席WAI…- 4

- 0

-

34.5K Star!AI智能体的记忆革命:比OpenAI Memory快91%还便宜90%

AI聊天机器人健忘症终于有解了。 Mem0给AI装上了"大脑",让它能记住用户偏好、学习行为习惯,甚至在跨平台对话中保持上下文连续性。 关键是它的性能数据很吓人:比OpenAI原生Memory功能准确率高26%,响应速度快91%,Token使用量减少90%。这不是小修小补,这是颠覆性的技术突破。 三层记忆架构,让AI真正"懂你" 传统AI每次对话都从零开…- 3

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 1

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 1

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 6

- 0

-

一文搞懂大模型、RAG、函数调用、Agent、知识库、向量数据库、知识图谱、AGI的概念和联系

技术的意义不在于堆砌概念,而在于解决真实世界的问题。 你是否曾在阅读科技文章时,被“大模型”、“RAG”、“Agent”、“知识图谱”这些术语轮番轰炸,感觉它们既相互关联又界限模糊? 仿佛面对一个庞大乐高城市,分不清哪块积木支撑着核心结构,哪块又是实现特定功能的精巧组件? 今天,我们就拨开迷雾,深入探究这些构建智能未来的核心要素,厘清它们各自的角色与协同之道。01 基石之力:大模型,智能涌现的引…- 5

- 0

-

WAIC-Day3: 谈谈Agent场景及Agent OS基础设施

TL;DR 看到今年Agent和具身智能爆火, 是否还记得去年云栖大会吴妈的一段话: “我们认为AI最大的想象力绝对不是在手机屏幕上,AI最大的想象力是在通过渗透数字世界,接管数字世界,并改变物理世界” 那个时候还没有MCP也没有Manus/Flowith, 而如今我们看到了一条清晰的Agent渗透数字世界,接管数字世界的路径, 同时也看到了具身智能逐渐改变物理世界的趋势... 别问我Day2干嘛…- 8

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 6

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 1

- 0

-

OpenAI深夜发布ChatGPT Study:免费AI家教,彻底颠覆传统教育

专注AIGC领域的专业社区,关注微软&OpenAI、百度文心一言、讯飞星火等大语言模型(LLM)的发展和应用落地,聚焦LLM的市场研究和AIGC开发者生态,欢迎关注!今天凌晨1点,OpenAI发布了ChatGPT Study学习模式。 该模式主要面向教育领域,提供交互式提示、支架式回应、个性化教育、知识点检查四种方法,可以深度解读每一道难题的解题思路和流程,而不是仅仅给出答案。 也就是说C…- 1

- 0

-

微软进军 AI 浏览器,维持巨头的平庸

Edge 能读懂网页了,仅此而已。 作者|薛星星编辑|蒋浇封面|Edge 截图 经过了两年对 Edge 浏览器 AI 功能的小修小补之后,微软在今天为 Edge 浏览器加入 Copilot 模式,正式进军 AI 浏览器市场。 具体来说,Edge 浏览器中的 AI 功能不再像以前一样只是一个聊天侧边栏,新推出的 Copilot 模式可以让 AI 阅读和理解网页内容,比如帮你做一个技术文档页面的解读或…- 0

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 1

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 2

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 2

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 5

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 5

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 2

- 0

-

Higress ,助力企业构建私有 AI 网关和 MCP 市场

Higress 为 Agent 开发、LLM API 管理,提供易用、可靠的集成服务。已支持 100 多种大语言模型和版本,提供开源和云上商业化版本。在 AI 应用快速发展的当下,如何高效地将存量数据服务与新兴的模型调用需求对接,成为企业和开发者关注的焦点。 AI 网关能够将外部调用不同大模型的请求,通过统一的调用方式转发到内部对应的大模型上,使得后端模型调度更加灵活;Higress AI 网关支…- 21

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 7

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 5

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 9

- 0

❯

购物车

优惠劵

搜索

扫码打开当前页

联系我们

返回顶部

幸运之星正在降临...

点击领取今天的签到奖励!

恭喜!您今天获得了{{mission.data.mission.credit}}积分

我的优惠劵

-

¥优惠劵使用时效:无法使用使用时效:

之前

使用时效:永久有效优惠劵ID:×

没有优惠劵可用!