-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

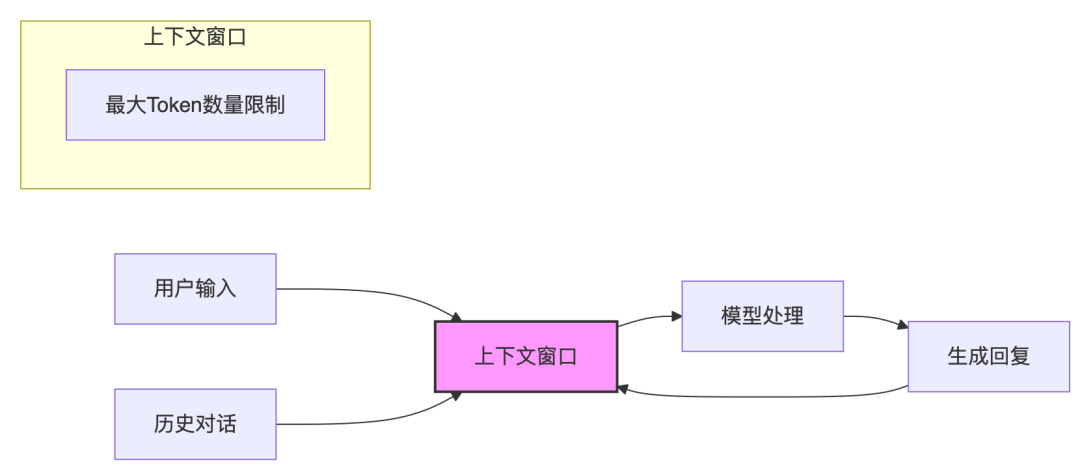

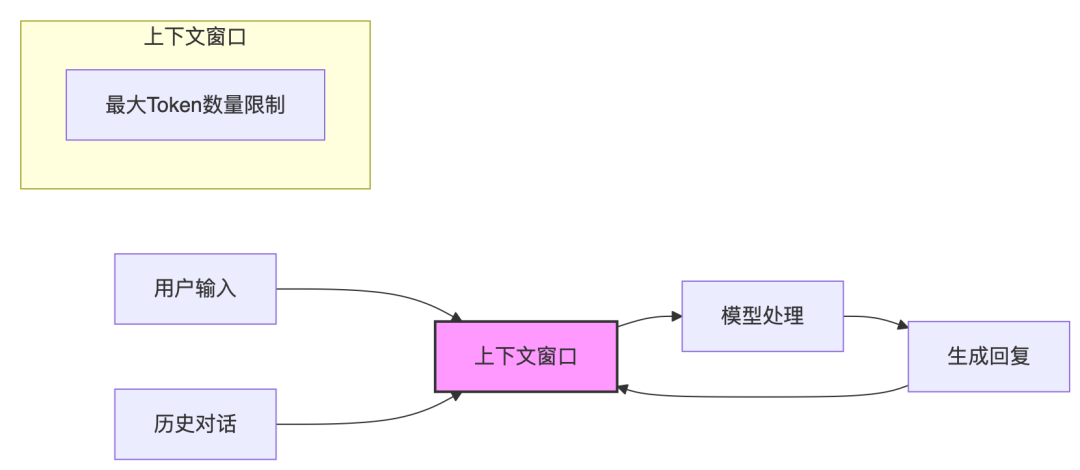

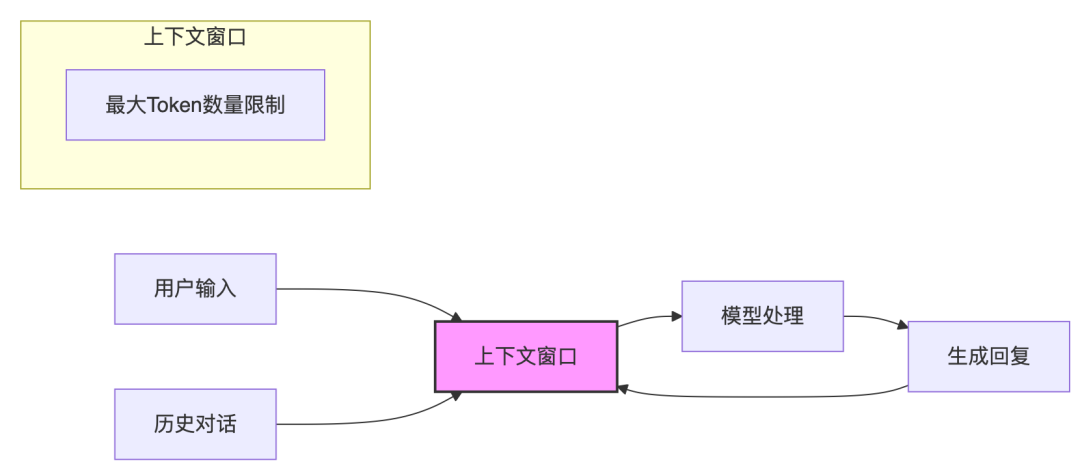

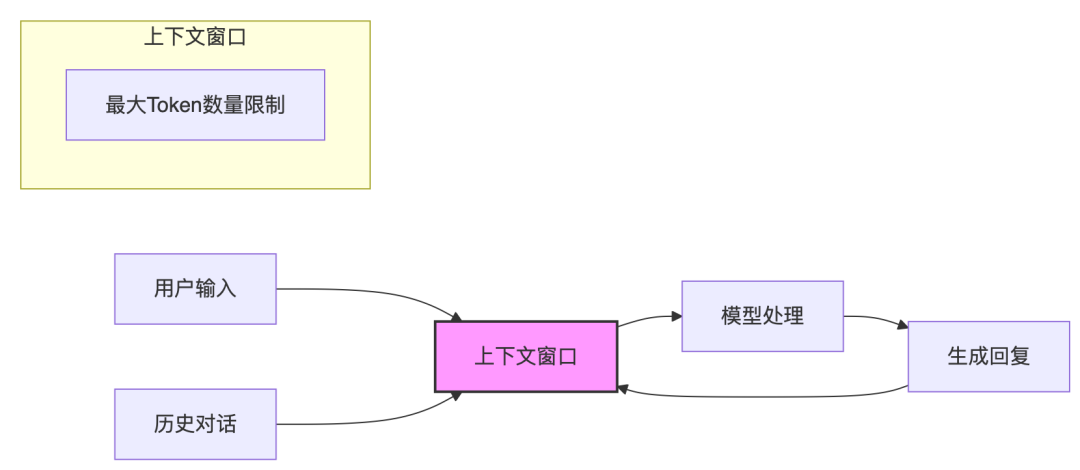

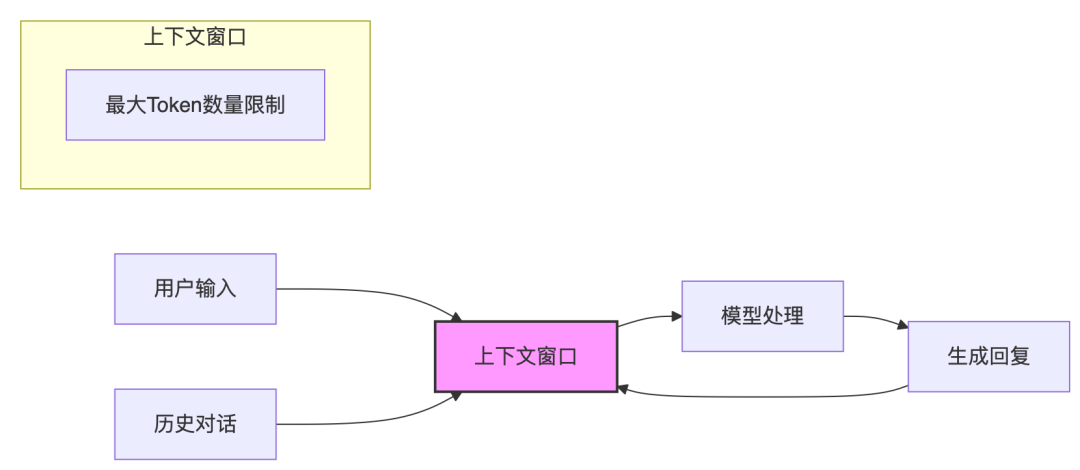

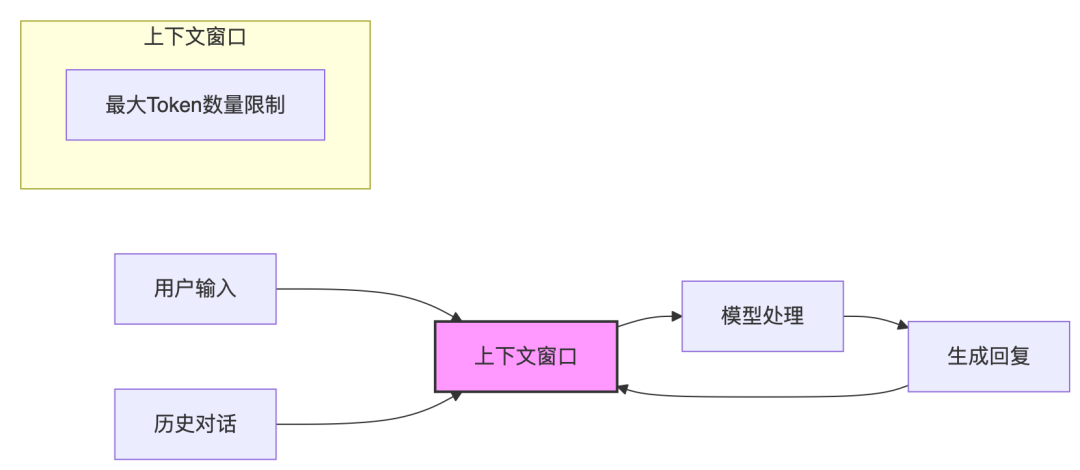

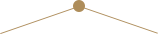

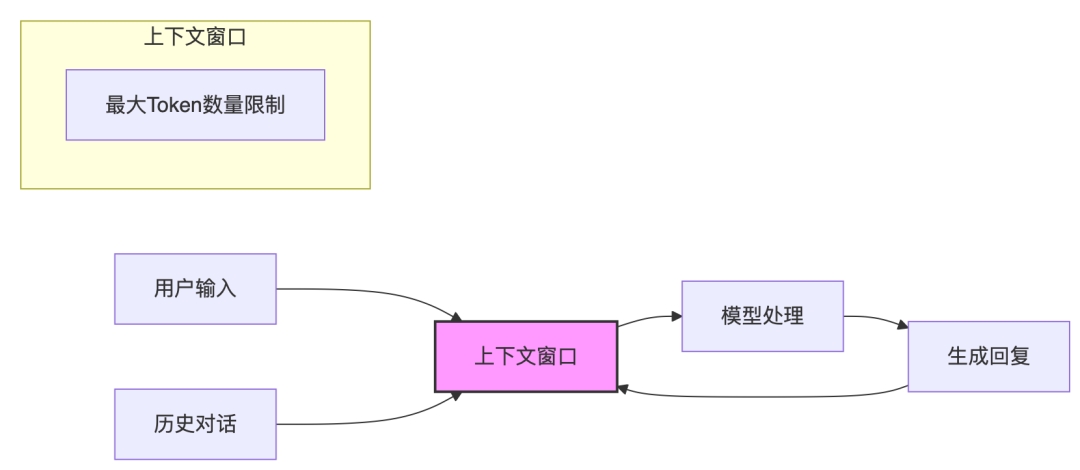

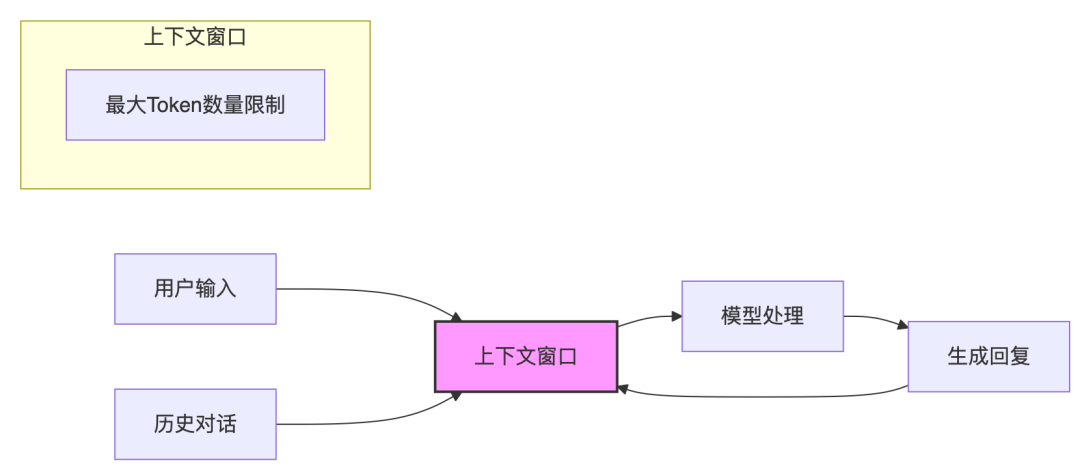

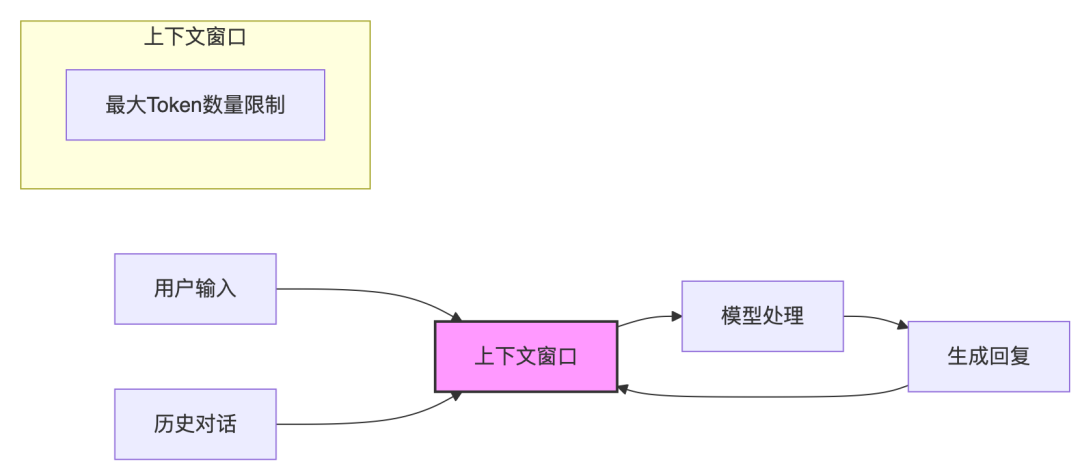

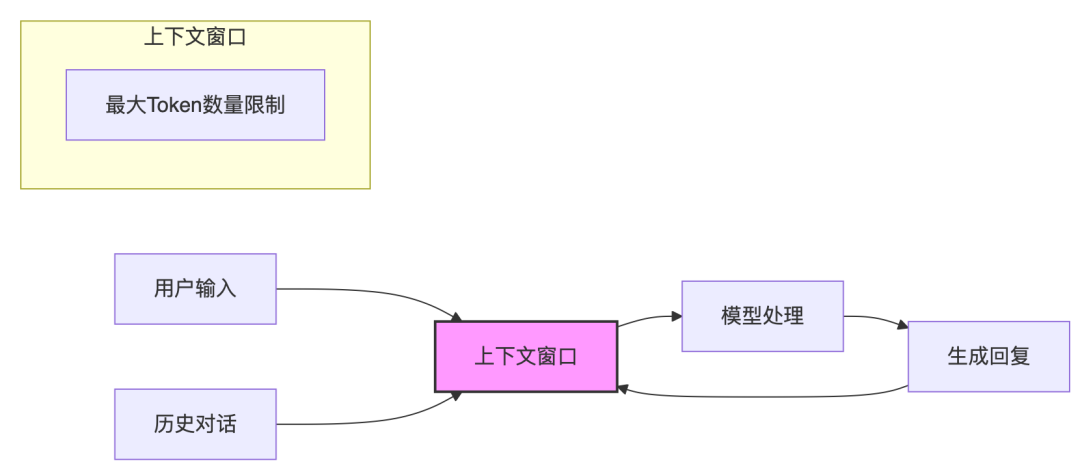

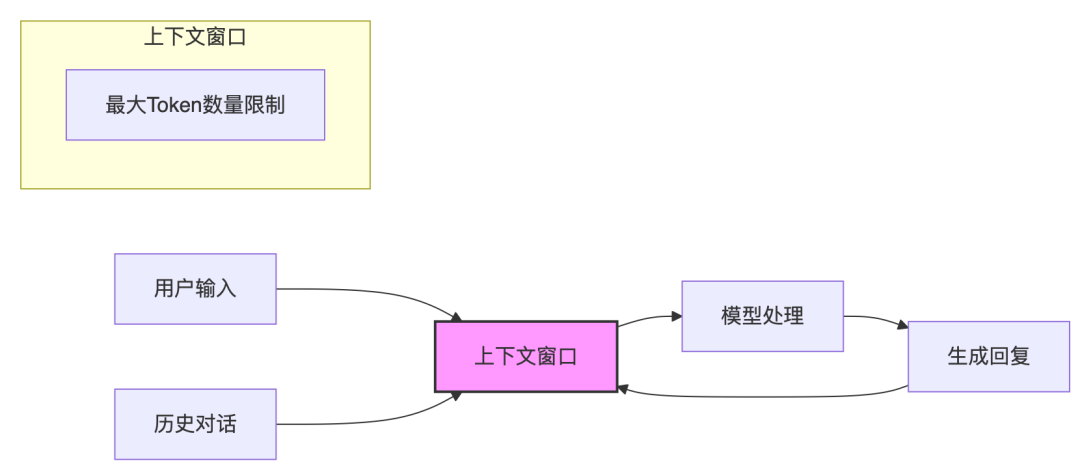

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 2

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 5

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 1

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 5

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 1

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 3

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 1

- 0

-

一个Claude Code的远程遥控器

在公司启动了一个需要跑几小时的数据分析任务,人又想溜,但又怕任务出错或跑完后无法及时进行下一步怎么办? JessyTsui开发了一款远程的Claude Code遥控器,通过收发邮件,远程控制本地的Claude Code。 也就是说,你可以在办公室启动Claude Code,然后潇洒地回家,等任务一完成,你的邮箱立刻会收到通知。 还支持连续对话,只需直接回复这封邮件,写下新的指令,比如“继续重构下一…- 4

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 7

- 0

-

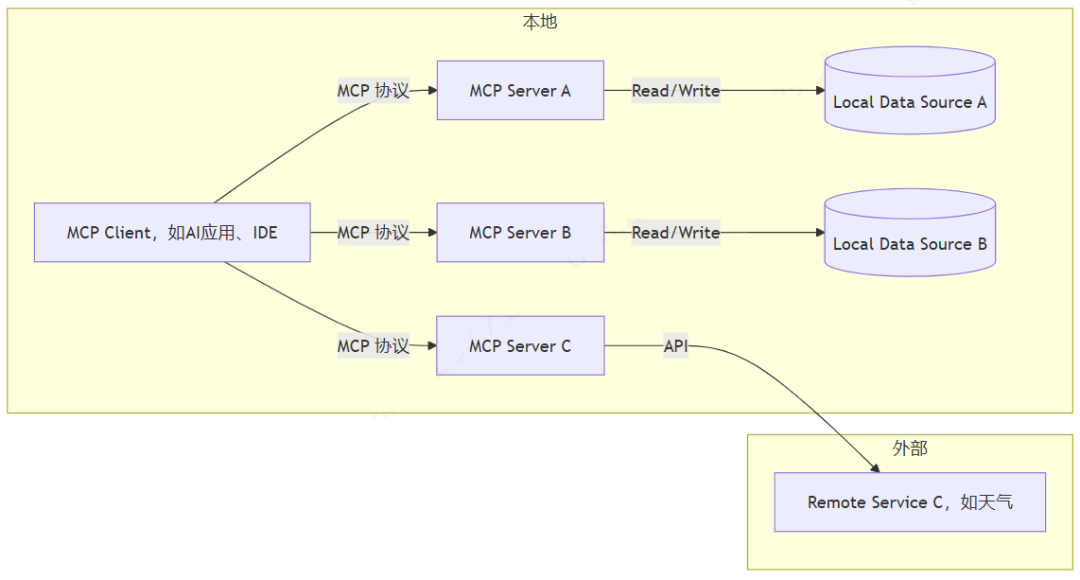

AI应用 之 MCP调用及SOC智能问数

智能问数在AI应用领域越来越广泛,如果是从数仓中问数,还需要IT团队专门建设相关的数据中台系统。如果我们问的数据本身关联性不太强,但又涉及多个领域,那么,MCP服务+智能问数则是最快捷方便的途径。PS:新书发布的进程正在推进,预计8月份可以和大家见面了。欢迎大家在文末评论!!内容提要1. MCP是什么2. 安装使用步骤3. 实战案例01MCP是什么MCP(Model Context Pr…- 6

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 9

- 0

-

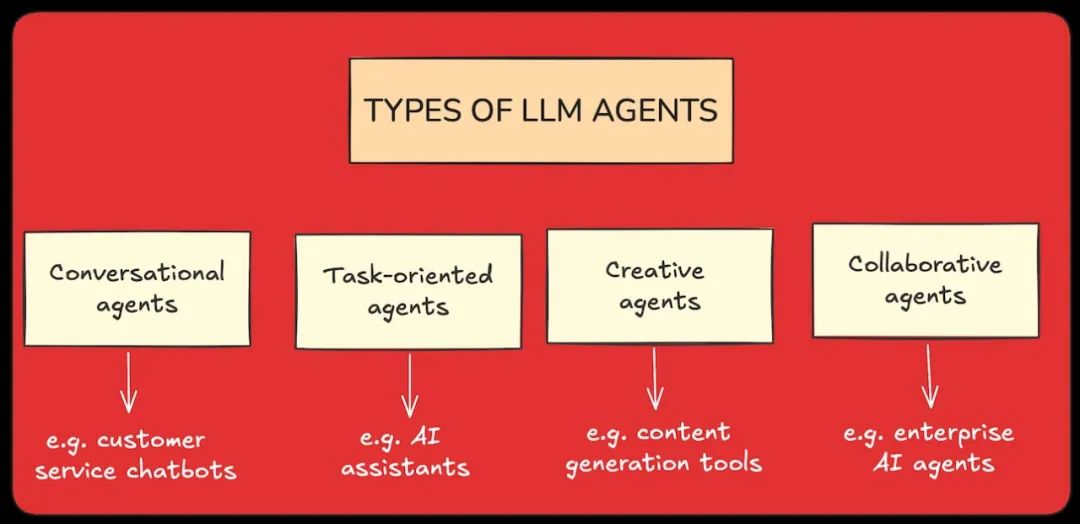

企业级智能体,从“效率孤岛”到“价值共振”的实践路径

(智能体的不同类型,从对话智能体到面向协作的企业级智能体) 在当下的技术浪潮中,如果说大型语言模型(LLM)是点燃引线的火花,那么企业级AI智能体(Agent)无疑是即将引爆生产力革命的炸药。从硅谷的最新动态到国内厂商的纷纷布局,Agent正迅速从一个技术概念,演变为企业数字化转型的核心议题。 然而,喧嚣之下,许多企业同行依然心存困惑:Agent与过去的RPA、Chatbot究竟有何本质区别?它真…- 7

- 0

-

LLM记忆终极指南:从上下文窗口到高级智能体记忆系统

点击“蓝字” 关注我们当你向聊天机器人报上姓名,片刻后它却再次询问"你叫什么"时,这种数字失忆现象暴露出人工智能的关键短板:大型语言模型(LLMs)本质上是无状态的。它们像金鱼一样"记不住"过去的对话,每次交互都被视为全新事件。ChatGPT等应用展现的记忆能力,实则是通过在每轮对话中强行插入历史记录制造的 illusion(假象)。这种"上下文管…- 7

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 7

- 0

-

迈向Agentic AI时代,百花齐放背后的三条主线 | 高榕 X 火山引擎

我们正迈向Agentic AI的时代。在这一新浪潮里,我们不再满足于对话和生成,同时追求行动和自主执行;除了驱动创新应用,Agentic AI也正大步走向更加广阔的产业实践和深度场景中。AI能力向自主执行跃迁背后,有赖于大模型推理能力、多模态理解能力以及处理多步骤复杂任务能力的进阶,也有赖于AI Infra的全面升级。近期,火山引擎发布了豆包大模型1.6、豆包·视频生成模型Seedance 1.0…- 7

- 0

-

谈几点 Qwen3-Coder 的使用体验

最近一直在用 Qwen3-Coder 模型去开发网页工具,谈几点自己的使用体验。首先,大家最关心的问题,Qwen3-Coder 的性能究竟如何。在前端网页开发中,Qwen3 Coder 的编程能力,审美方向都要优于 K2。而由于 DeepSeek R1 是推理模型,在只给少量提示词的情况下,DeepSeek 给出的代码从UI美观度,细节方面要优于 Qwen 3。对比 Claude 来说,整体编码能…- 6

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 1

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 5

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 4

- 0

-

Apache Flink 2.0:实战数据湖与 AI 实时化

导读 本次分享题目为 Apache Flink 2.0:助力数据湖 & AI 实时化。 主要介绍:1. Flink 2.0 概述 2. 存算分离状态管理 3. Streaming Lakehouse 4. AI 实时化探索 5. 问答环节分享嘉宾|宋辛童 阿里云 Flink Java 引擎负责人 编辑整理|张静瑜 内容校对|李瑶 出品社区|DataFun 01 Flink 2.0 概述 1…- 4

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 4

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 7

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 3

- 0

-

Cursor Meetup 杭州站分享实录:小团队如何用 AI 撑起万级日活产品?

01🧠 Cursor 实战复盘:如何用 AI 撑起万级日活产品?我是 iMean AI 算法负责人孔德涵,今天想和大家聊聊:一个十人左右的小团队,如何借助 Cursor 快速迭代出能够稳定支撑万级日活的产品。这个标题包含两个关键点:我们的产品不是简单的 MVP 验证,而是需要保证长期稳定运行的生产级产品;我们是一个相对较小的团队,每个成员都是"超级个体",Cursor…- 3

- 0

❯

购物车

优惠劵

搜索

扫码打开当前页

联系我们

返回顶部

幸运之星正在降临...

点击领取今天的签到奖励!

恭喜!您今天获得了{{mission.data.mission.credit}}积分

我的优惠劵

-

¥优惠劵使用时效:无法使用使用时效:

之前

使用时效:永久有效优惠劵ID:×

没有优惠劵可用!