-

AI时代,民营经济如何“接招”

作为中国经济的重要组成部分,民营经济向来以灵活机制和创新活力著称。而在人工智能浪潮下,民营经济也正迎来新的发展考题——是做被动适应的追随者,还是主动破局的弄潮儿?7月24日,2025年世界互联网大会数字丝路发展论坛在福建泉州开幕。主论坛上,嘉宾们围绕“人工智能赋能民营经济高质量发展”这一议题展开深入探讨。从机遇优势到实践举措,从现实挑战到应对之策,一幅人工智能赋能民营经济发展的全景图渐次展开。7月…- 12

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

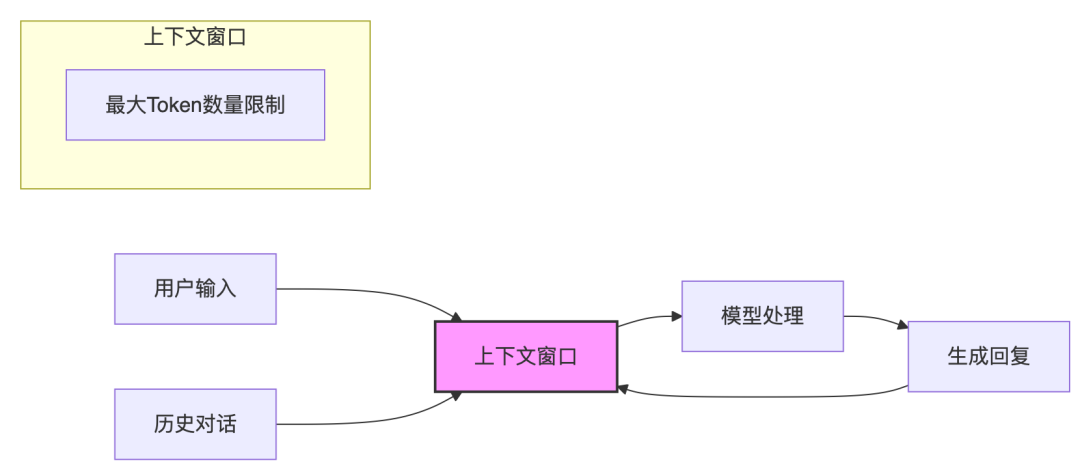

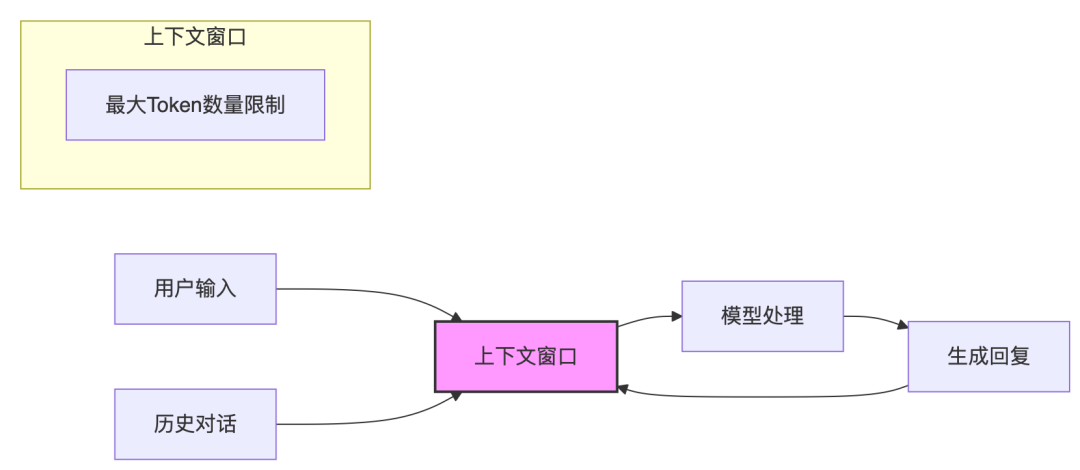

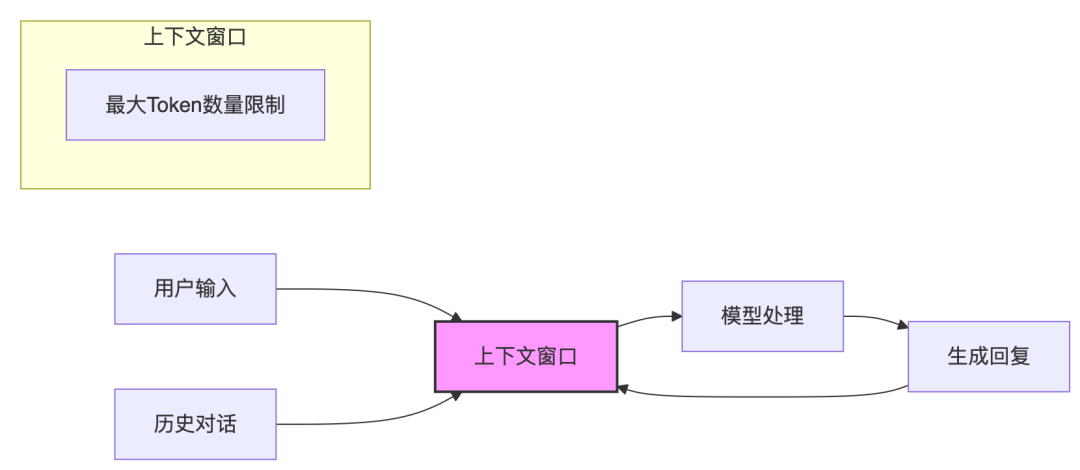

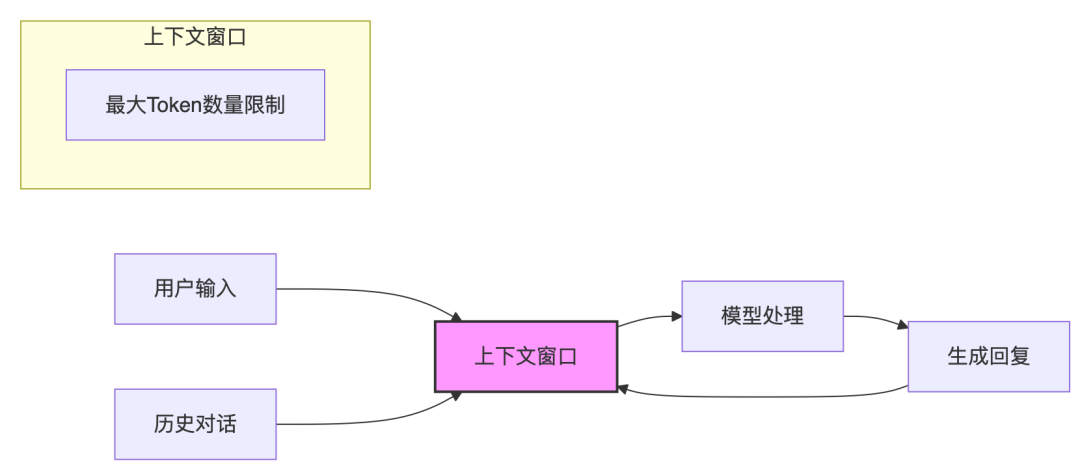

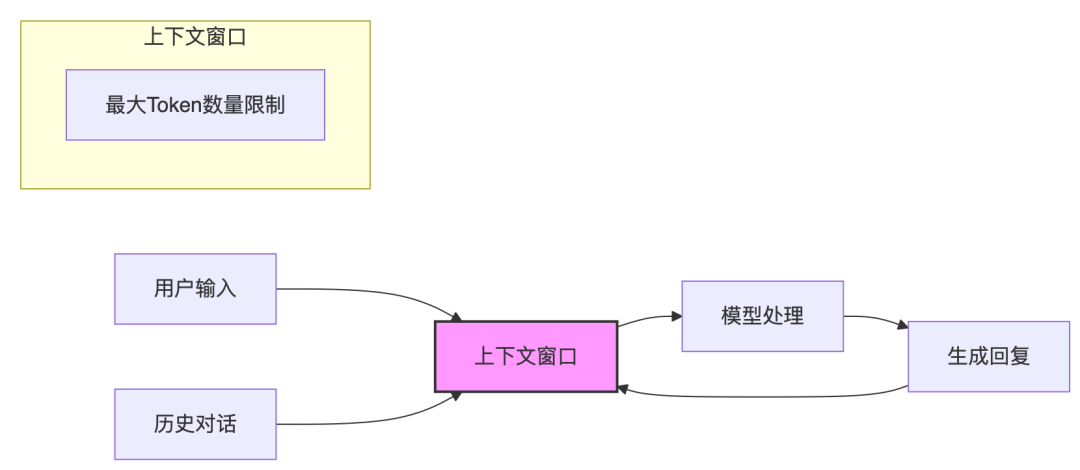

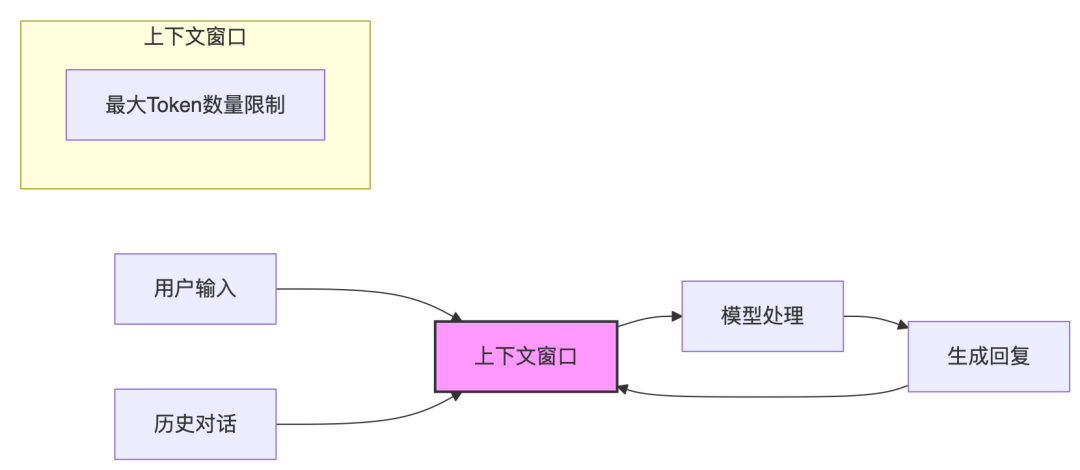

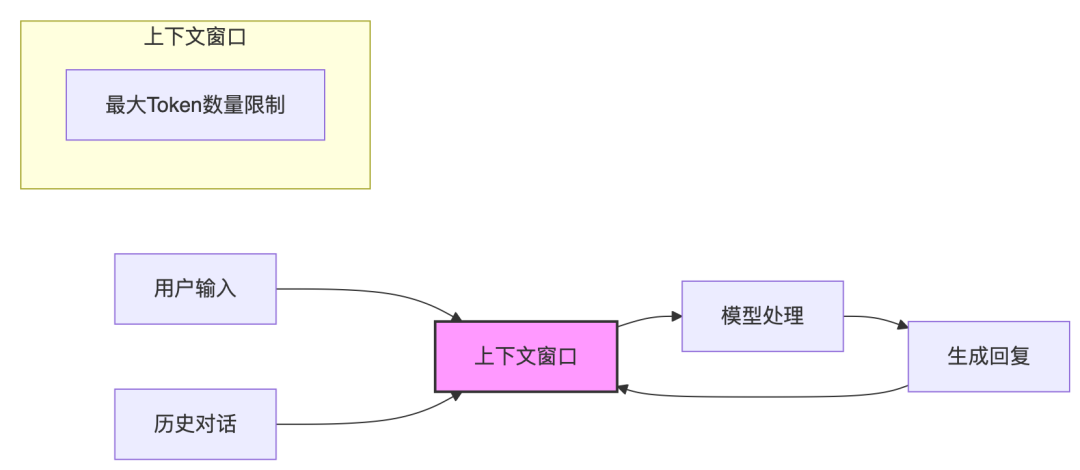

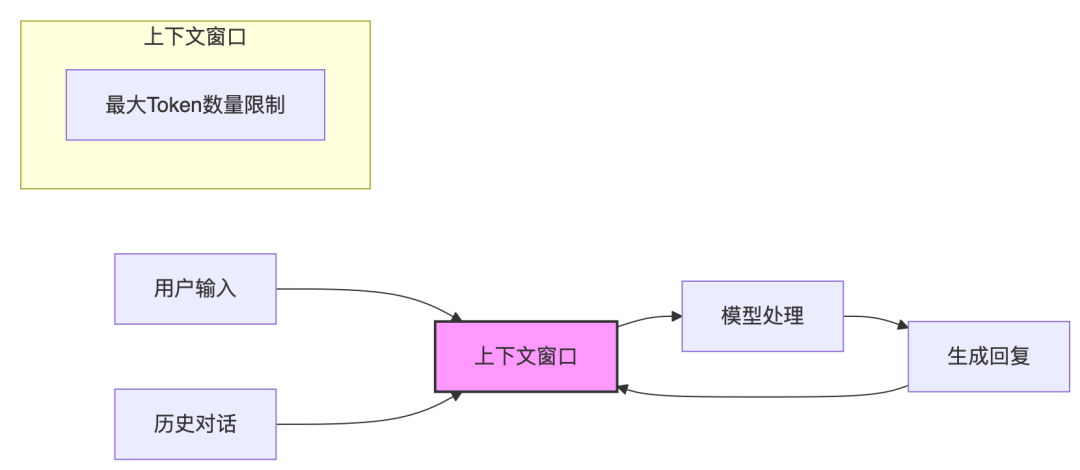

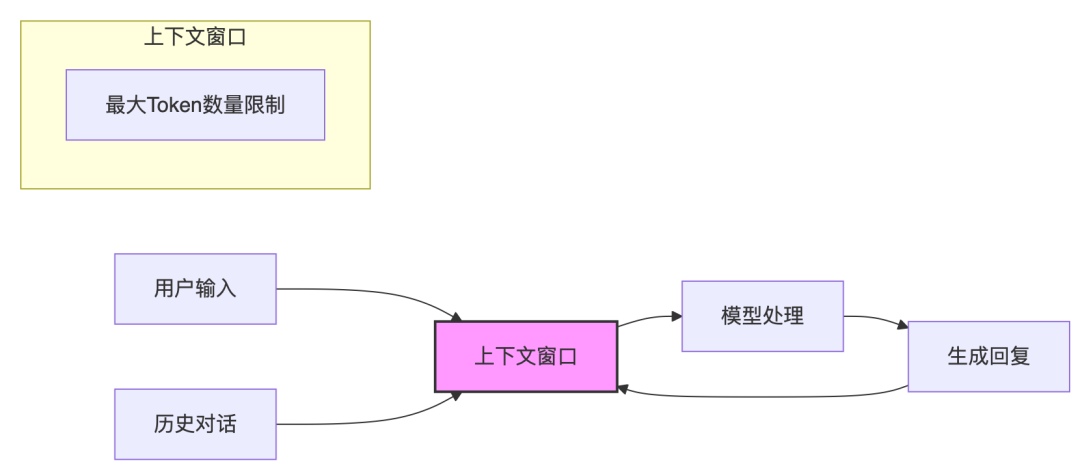

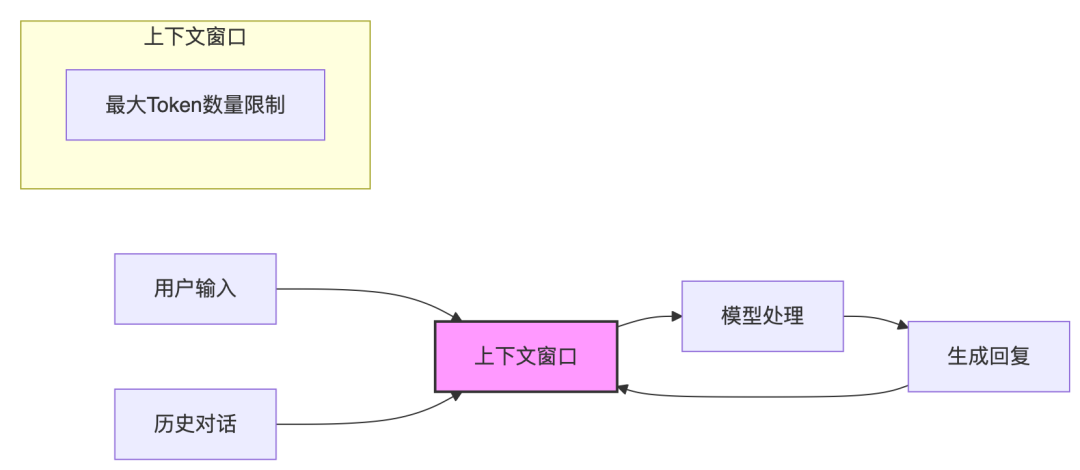

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 9

- 0

-

离线+记忆,大模型进化的分水岭

下一代通用人工智能的基石:大模型记忆机制。 今年的WAIC,依旧火爆。 闷热的上海、拥挤的展台、扎堆的AI大模型——这些都是历年WAIC的常态,但今年有些变化。 今年的WAIC上有一个显著的风向标:无论是参展企业还是逛展用户,人们对大模型这一概念已经祛魅,取而代之的是每个人都在问:“有没有落地案例?” 经过了三年的市场教育,用户早已对一遍遍的“模型刷榜”感到疲倦。尤其是2025年开年至今,Deep…- 14

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 4

- 0

-

秘塔AI搜索 搜索API上线了:集成搜索、问答与知识库功能

秘塔AI搜索 https://metaso.cn/ 又上新功能了,之前介绍过今天学点啥,秘塔AI搜索 今天学点啥 PPT秒变在线播放课程,之后还推出了深度研究,这周又上线了秘塔搜索API,支持通过API的方式调用搜索和对话功能,方便集成到各种工具。API调用是收费的,官方介绍说是每次查询3分钱,目前免费送5000点额度,大家先试试看。 打开秘塔主页,在主对话框的上面多了一个选项API。点击选项进入…- 15

- 0

-

OpenAI o3系统提示词泄漏!Hinton的观点再次被印证!

OpenAI的o3模型系统提示词近日被曝光,其中一句"你不是人类,也没有物理形态"的指令,意外揭示了AI发展中一个令人深思的悖论。 完整地址:https://github.com/Wyattwalls/system_prompts/blob/main/OpenAI/o3-20250725安全研究员Wyatt Walls在测试中发现,o3的系统提示词开头就明确告诉模型:"…- 6

- 0

-

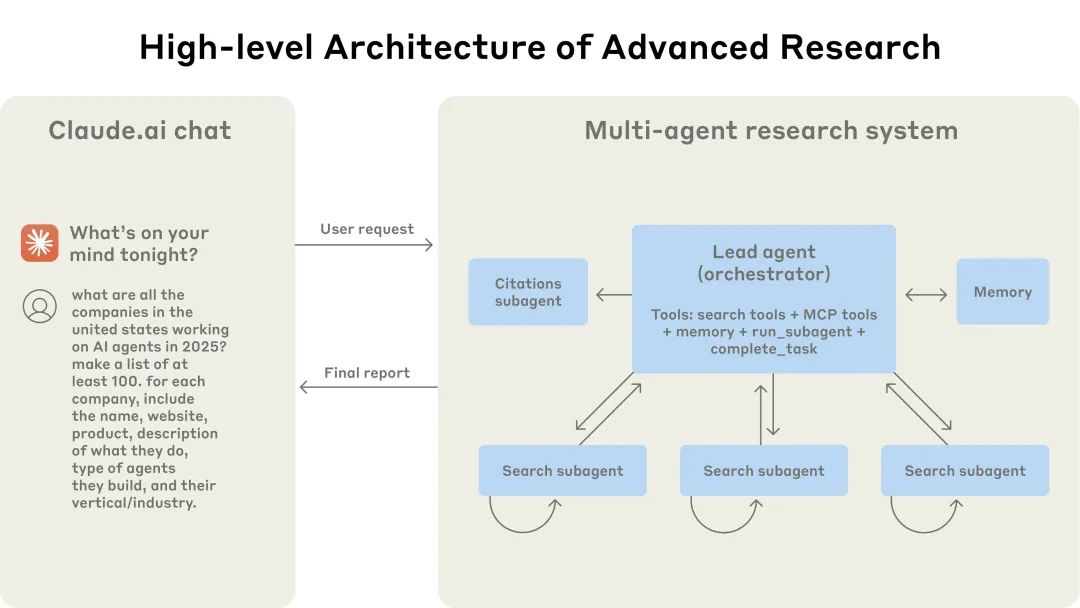

Anthropic: 如何构建多智能体研究系统

TL;DR 这篇来自 Anthropic 的文章,系统性地阐述了其 Multi-Agent 研究系统的构建历程,为构建高级 AI Agent 提供了清晰的路线图。其核心内容可归纳为三点: 1. 为何选择多智能体: 明确了其在处理开放式、动态研究任务上的优越性。通过并行化与任务分解(Orchestrator-Worker 模式),系统能投入更多有效算力(Tokens),在广度搜索等任务上性能远超…- 7

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 2

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 5

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 3

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 5

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 7

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 2

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 3

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 11

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 6

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 9

- 0

-

大语言模型与AI智能体中的上下文工程(Context Engineering)

点击“蓝字” 关注我们在人工智能快速发展的浪潮中,上下文工程(Context Engineering)正逐渐成为解锁大语言模型(LLM)潜能的关键技术。这项新兴学科专注于设计和构建动态系统,能够在恰当的时机为LLM汇集所有相关信息、工具和数据。正如OpenAI前研究员Andrej Karpathy所言,上下文工程是"一门精妙的艺术与科学,旨在为下一步操作在上下文窗口中填充恰好合适的信息&…- 12

- 0

-

看完Anthropic内部内部员工是如何用Claude Code,我彻底惊呆了

朋友们,我看了一份 Anthropic 的内部文档,讲他们自己人是怎么用 Claude Code 的。看完之后,我整个人坐在椅子上,半天没缓过劲来。 怎么说呢,那种感觉就像是,我们还在争论“AI 会不会取代程序员”,人家已经把 AI 当成一个活生生的“实习生”、“同事”甚至“项目经理”在用了。而且,最颠覆我三观的是,用得最溜、最出神入化的,居然很多都不是程序员! 这已经不是生产力工具了,这简直…- 15

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 2

- 0

-

如何用 AI 翻译实现文档多语言支持的周级敏捷响应?

Photo by Hans Benn on Pixabay 在全球化技术产品的竞争中,文档的本地化响应速度直接影响用户体验和市场拓展。 传统翻译模式往往需要数月时间,而 AI 翻译技术的成熟,让周级甚至更短周期的多语言支持成为可能。AI 正在改写技术文档本地化的游戏规则。 本文将分享一次 AI 驱动下的技术文档极速本地化实践,借助 AI 翻译引擎+轻量人工校验,平衡效率与质量,在短短数天内为产品文…- 6

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 3

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 3

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 1

- 0

❯

购物车

优惠劵

搜索

扫码打开当前页

联系我们

返回顶部

幸运之星正在降临...

点击领取今天的签到奖励!

恭喜!您今天获得了{{mission.data.mission.credit}}积分

我的优惠劵

-

¥优惠劵使用时效:无法使用使用时效:

之前

使用时效:永久有效优惠劵ID:×

没有优惠劵可用!