-

Spring AI Alibaba 游乐场开放!一站式体验AI 应用开发全流程

Playground 是社区以 Spring AI Alibaba 框架为基础搭建的 AI 应用体验平台,应用包含完善的前端 UI + 后端实现,具备对话、图片生成、工具调用、RAG、MCP 等众多 AI 相关功能。基于 Playground 项目源码,您可以快速复刻一个属于自己的 AI 应用。 访问以下地址快速体验 Playground:playground.java2ai.com 效果预览: …- 5

- 0

-

NVIDIA DOCA 3.0 助力 AI 平台开启网络新纪元

NVIDIA DOCA 框架已发展成为新一代 AI 基础设施的重要组成部分。从初始版本到备受期待的 NVIDIA DOCA 3.0 发布,每个版本都扩展了 NVIDIA BlueField DPU 和 ConnectX SuperNIC 的功能,从而实现了前所未有的 AI 平台可扩展性和性能。 通过丰富的库和服务生态系统,DOCA 充分利用 BlueField DPU 和 SuperNIC,实现了…- 4

- 0

-

AI大模型应用,看好这两个方向

如果说前年大家在跟随chatGPT做大模型,去年大家在跟着英伟达做GPU,那么今年的AI,端侧应用迎来井喷式发展。 做大模型需要很强的算法团队,而做GPU需要很强的芯片级的硬件团队,这两个领域门槛都很高,基本都是在工科名校的团队中诞生知名的公司。。清华在这一波AI产业浪潮中扮演了重要的角色。我们开玩笑说,现在清华就3个系最热门:计算机、电子系、自动化系。经管的可以做好金融服务沾点边喝口汤。 比如大…- 4

- 0

-

MCP协议迎来重大更新:8大新特性全解析

模型上下文协议(Model Context Protocol,MCP)作为连接AI模型与外部系统的重要桥梁,在2025年6月18日发布了重大更新。本次更新带来了8项重要改进,将大幅提升AI应用的安全性、交互性和实用性。🔧 核心架构优化1. 移除JSON-RPC批处理支持MCP团队决定简化协议复杂度,移除了对JSON-RPC批处理的支持。这一改变旨在:降低实现难度提高协议的可维护性减少潜在的安全漏洞…- 4

- 0

-

微软再裁 9000 人,白领「大屠杀」来袭:不用 AI 要被裁,用了 AI 也被裁

AI 裁员潮已经有了苗头。今天微软被曝确认了年内新一轮裁员计划,预计将影响约 9000 个工作岗位,占其全球员工总数的 4%。这是微软今年宣布的第二次大规模裁员,也是其在 18 个月内的第四次大规模人员调整。与此同时,微软正在要求部分管理者根据员工在内部使用 AI 工具的情况来评估其工作表现,并考虑在下一财年的绩效考核中,正式加入与 AI 使用相关的考核指标。一边裁员,一边强制留任员工提升 AI …- 4

- 0

-

智能重塑攻防:人工智能在网络安全领域的深度应用与未来范式

摘要 本文深入探讨了人工智能(AI),特别是大语言模型(LLM)与自主智能体(Agentic Agent),在网络安全领域的革命性应用。文章首先剖析了AI技术替代传统规则检测的根本优势,并系统性地阐述了模型微调、提示词工程等核心使能技术。通过对AI在安全运营中心(SOC)多个核心场景中的应用进行分析,本文展示了其在威胁检测、事件响应、威胁狩猎及漏洞管理等方面的实践价值。在此基础上,文章进一步展…- 5

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

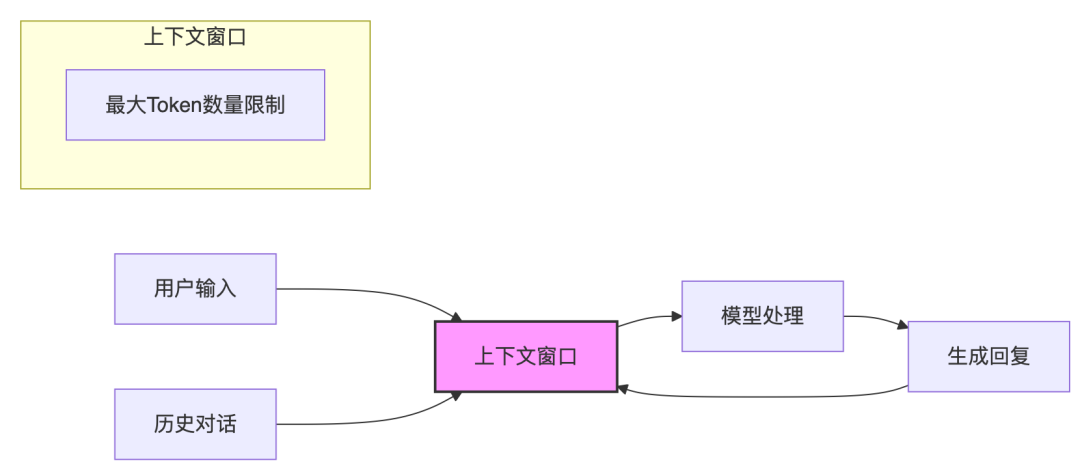

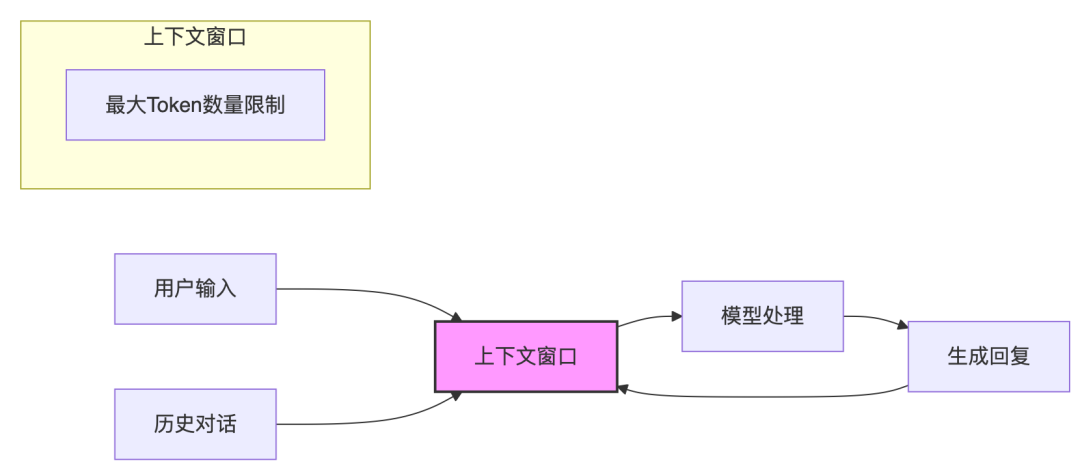

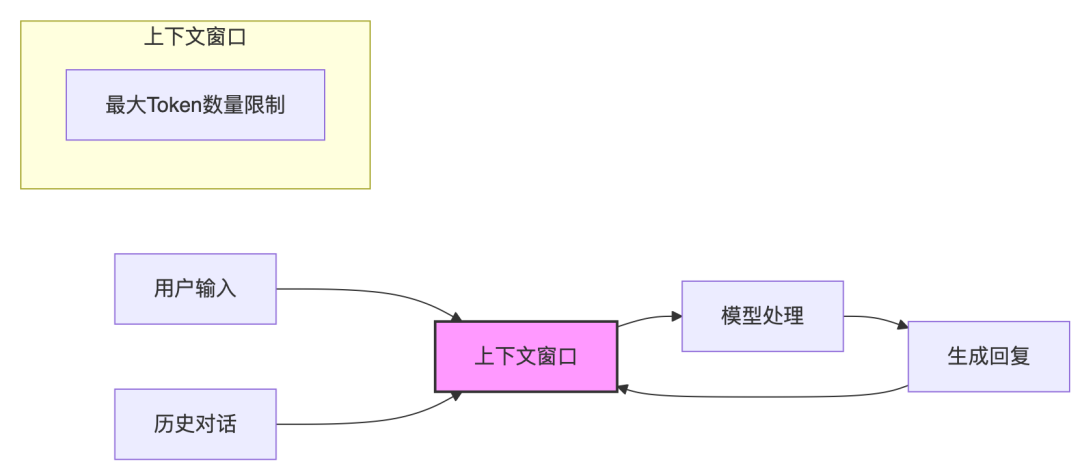

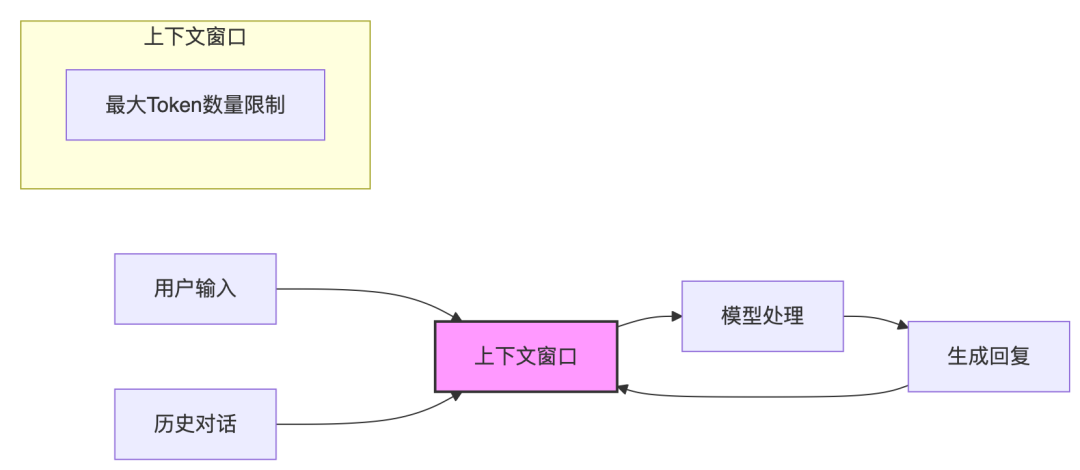

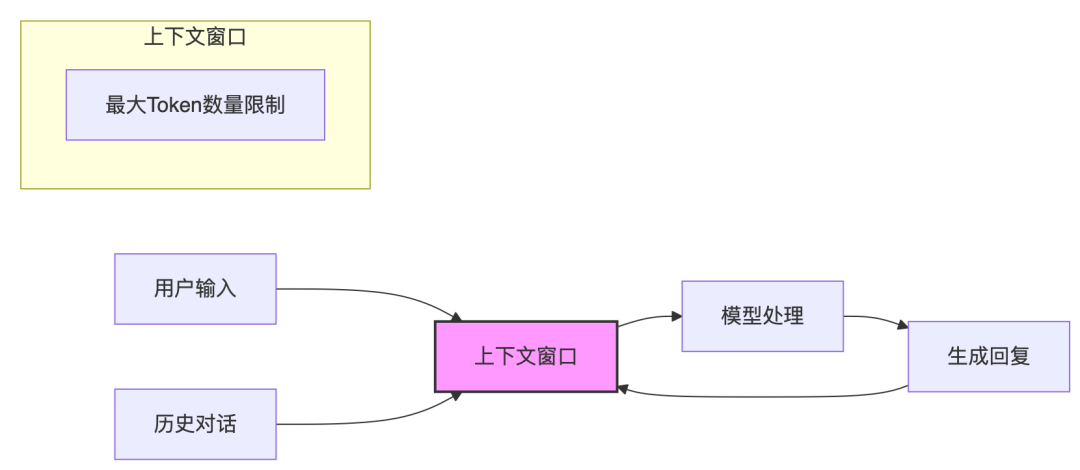

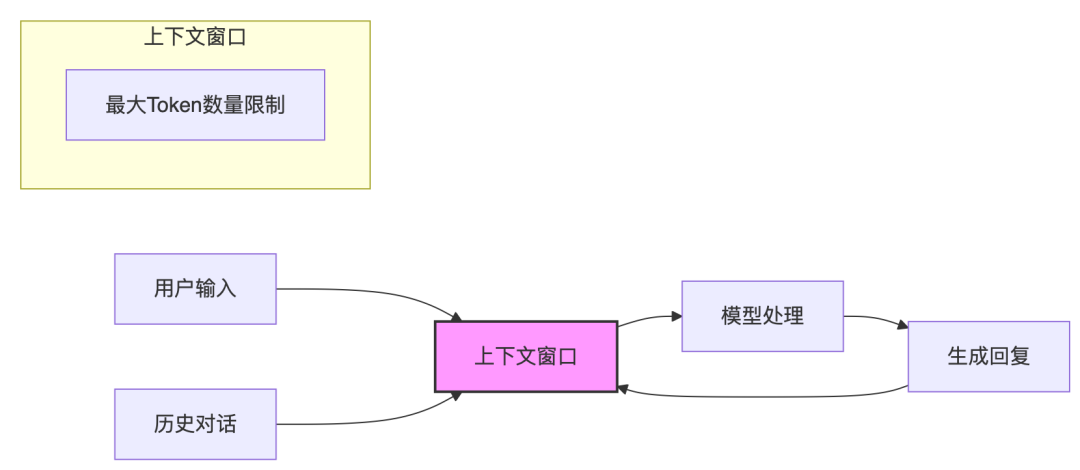

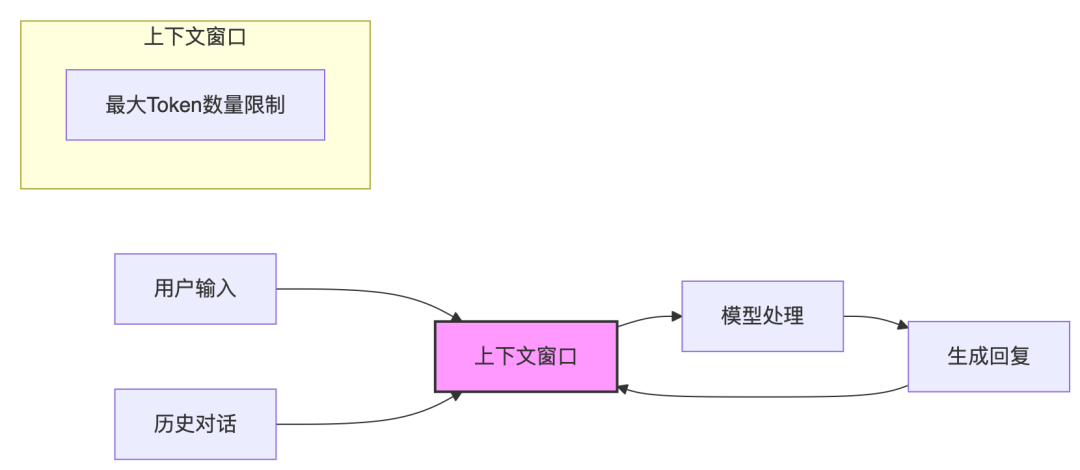

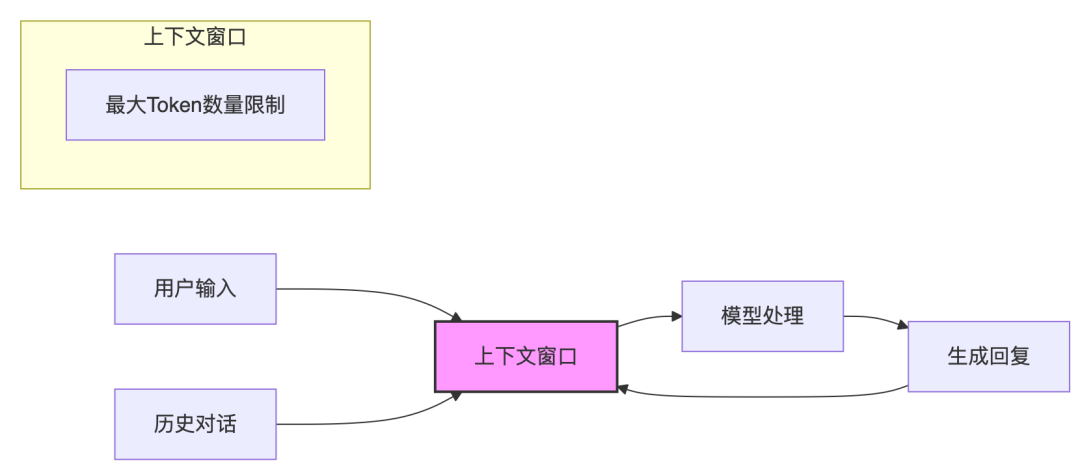

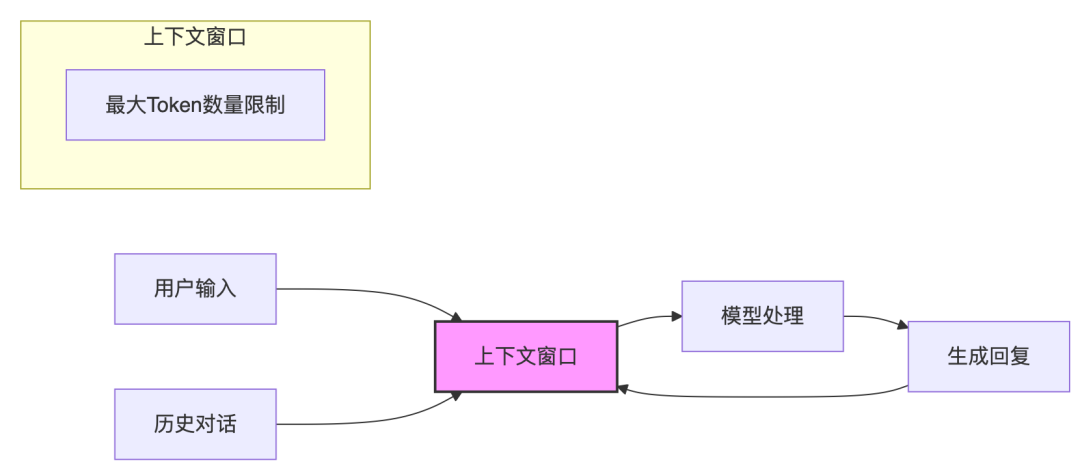

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 4

- 0

-

大模型在软件工程中的真实能力边界

之前写了这篇文章:人类软件工程师,是时候让位了!,更多体现AI/大模型能干什么,有读者希望我再写一篇文章,让人们知道AI/大模型不能干什么。今天就尝试写一写,虽然有点难,在结合上下文窗口扩展、智能体协作、深度检索、知识工程及 RAG 技术后,大模型在软件工程领域的能力会有较大的扩展和提升,理解能力和生成能力也趋于稳定,但其能力边界也会呈现出更复杂的形态。我们先从技术本质、工程实践等维度,结合最新研…- 3

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 4

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 4

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 3

- 0

-

vec2text 技术已开源!一定条件下,文本嵌入向量可“近乎完美地”还原

编者按:我们今天为大家带来的这篇文章,作者的观点是文本嵌入向量并非我们想象中的安全载体,在某些条件下,通过适当的技术手段可以高精度地还原出原始文本内容。 作者在本文介绍了其开发的 vec2text 方法 —— 一种基于迭代优化的文本反演技术,能够以 92% 的精确率还原 32 个词元的文本序列,BLEU 分数高达 97 分。这一技术为企业在部署 AI 系统时的数据安全策略敲响了警钟。本文系原作者观…- 4

- 0

-

临界知识:大语言模型时代的人机认知边界

TL;DR 识别“临界知识”,与大型语言模型(LLM)有效交互的核心在于:破除它“知道”任何事情的拟人化幻觉,并将其视为一个强大的、但有根本缺陷的统计模式匹配工具。 LLM的“知识”是参数化的幻象,而非事实:LLM的知识并非存储的事实,而是编码在其网络参数中的统计模式。这导致了三个无法根除的结构性缺陷:知识过时(有截止日期)、数据偏见(从互联网学到偏见)和知识分布不均(在某些领域是专家,在另一些领…- 6

- 0

-

AI文档智能体上线!AutoHub v0.7.0 全面升级,重构知识工作流

如何让每一个知识工作者都像专家一样高效? 这正是 OpenCSG AutoHub 想解决的问题。 无论你是产品经理、项目负责人、运维工程师,还是企业管理者,日常都要频繁处理各类文档:需求文档、项目报告、技术方案、会议纪要、市场调研……不仅耗时,还常常“写了像没写”。 AutoHub v0.7.0 的升级,正是围绕“如何让AI真正成为知识创作的合作者”展开的——不再是玩具,而是生产工具。 01 重塑…- 3

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 3

- 0

-

用点线面体理论聊AI项目落地的困境

最近看了一篇文章深有感触点技术、线流程、面场景、体生态——AI落地成功的金字塔法则! 和朋友聊天谈到AI项目的困境,智能客服项目做了1年的时间,受到领导的质疑说项目规划不清晰,没有达到高层预期的效果。今天借用点线面体的理论看是否能理清到底哪里出了问题? 第一个问题:可能是技术"点"的打磨不够扎实。 “点”的打磨不充分(技术组件孤立) …- 5

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 3

- 0

-

基于大语言模型(LLM)的应用分块策略

什么是分块(Chunking)? 在构建基于大语言模型(LLM)的应用时,**分块(Chunking)**是指将较长的文本分割成较小的片段,这些片段称为“块”。 这是一种重要的预处理技术,有助于优化最终存储在向量数据库中内容的关联性。关键在于找到大小适中的块:它们既要足够大以包含有意义的信息,又要足够小以确保应用的高性能和检索增强生成(Retrieval Augmented Generation,…- 3

- 0

-

AI 商业化,Salesforce 做对了什么?

Salesforce 的实践表明,场景聚焦、数据掌控、生态协同三者结合,才是让 AI 从概念走向规模化营收的核心逻辑。图由 AI 生成文|Alex编辑|燕子CRM 巨头也有自己的烦恼。 Salesforce 早在 2016 年就推出 Einstein AI,试图将 AI 融入销售软件。但是公司近年来面临 Sierra、Attio 等新兴 AI 公司的冲击,市场份额遭到蚕食。 在中国市场,Sales…- 5

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 4

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 4

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 3

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 4

- 0

❯

购物车

优惠劵

搜索

扫码打开当前页

联系我们

返回顶部

幸运之星正在降临...

点击领取今天的签到奖励!

恭喜!您今天获得了{{mission.data.mission.credit}}积分

我的优惠劵

-

¥优惠劵使用时效:无法使用使用时效:

之前

使用时效:永久有效优惠劵ID:×

没有优惠劵可用!